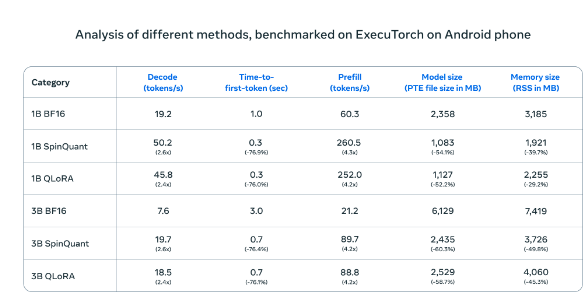

Meta Platformsは本日、Llamaモデルの新しい軽量版であるLlama 3.21Bと3Bを発表しました。これは、大規模言語モデルを一般的なスマートフォンやタブレットで安定して動作させることに初めて成功したものです。革新的な量子化トレーニング技術と最適化アルゴリズムを統合することで、処理品質を維持しながら、ファイルサイズを56%削減、メモリ使用量を41%削減、処理速度を元の4倍に向上させ、一度に8,000文字のテキストを連続処理できるようになりました。

Androidスマートフォンでのテストでは、Metaの圧縮AIモデル(SpinQuantとQLoRA)は、標準版と比較して速度と効率が大幅に向上しました。小型モデルの動作速度は4倍に向上し、メモリ使用量は減少しました。

OnePlus 12スマートフォンでの実際のテストでは、この圧縮版は標準版と同等の性能を示しながら、動作効率を大幅に向上させ、モバイルデバイスの計算能力不足という長年の課題を効果的に解決しました。Metaは、QualcommやMediaTekなどの主要なモバイルプロセッサメーカーと連携するオープンな協力体制を採用し、新バージョンはLlama公式ウェブサイトとHugging Faceプラットフォームで同時に公開され、開発者にとって使いやすいアクセス方法を提供します。

この戦略は、他の業界大手とは対照的です。GoogleやAppleが新技術を自社のオペレーティングシステムと深く統合することを選択する一方で、Metaのオープンなアプローチは、開発者に大きなイノベーションの余地を提供します。今回の発表は、データ処理方法が集中型サーバーから個人端末へと移行しつつあることを示しています。ローカル処理ソリューションは、ユーザーのプライバシーをより適切に保護し、より迅速な応答体験を提供できます。

この技術的ブレークスルーは、パーソナルコンピュータの普及期のような大きな変革を引き起こす可能性があります。ただし、デバイスの性能要件や開発者プラットフォームの選択など、課題も残っています。モバイルデバイスの性能が向上するにつれて、ローカル処理ソリューションの利点は徐々に明らかになるでしょう。Metaは、オープンな協力を通じて、業界全体をより効率的で安全な方向へと導き、モバイルデバイスの未来のアプリケーション開発に新たな道を切り開きたいと考えています。