人工知能分野において、画期的な技術が静かに台頭しつつあります。最近、Inception Labsは、Mercuryシリーズ拡散型大規模言語モデル(dLLMs)を発表しました。これは、高速かつ効率的に高品質なテキストを生成することを目的とした、次世代の言語モデルです。従来の自己回帰型大規模言語モデルと比較して、Mercuryは生成速度が最大10倍向上し、NVIDIA H100 GPU上で毎秒1000トークンを超える速度を実現しています。この速度は、これまでカスタムチップに依存して初めて達成できたものです。

Mercuryシリーズの最初の製品であるMercury Coderは、公開テストで登場しました。このモデルはコード生成に特化しており、優れた性能を発揮し、GPT-4o MiniやClaude3.5Haikuなどの既存の速度最適化モデルを複数のプログラミングベンチマークテストで上回っています。同時に、速度も約10倍速くなっています。開発者のフィードバックによると、Mercuryのコード補完機能はより好評で、Copilot Arenaのテストでは、Mercury Coder Miniが性能でトップクラスにランクインし、最速のモデルの一つとなっています。

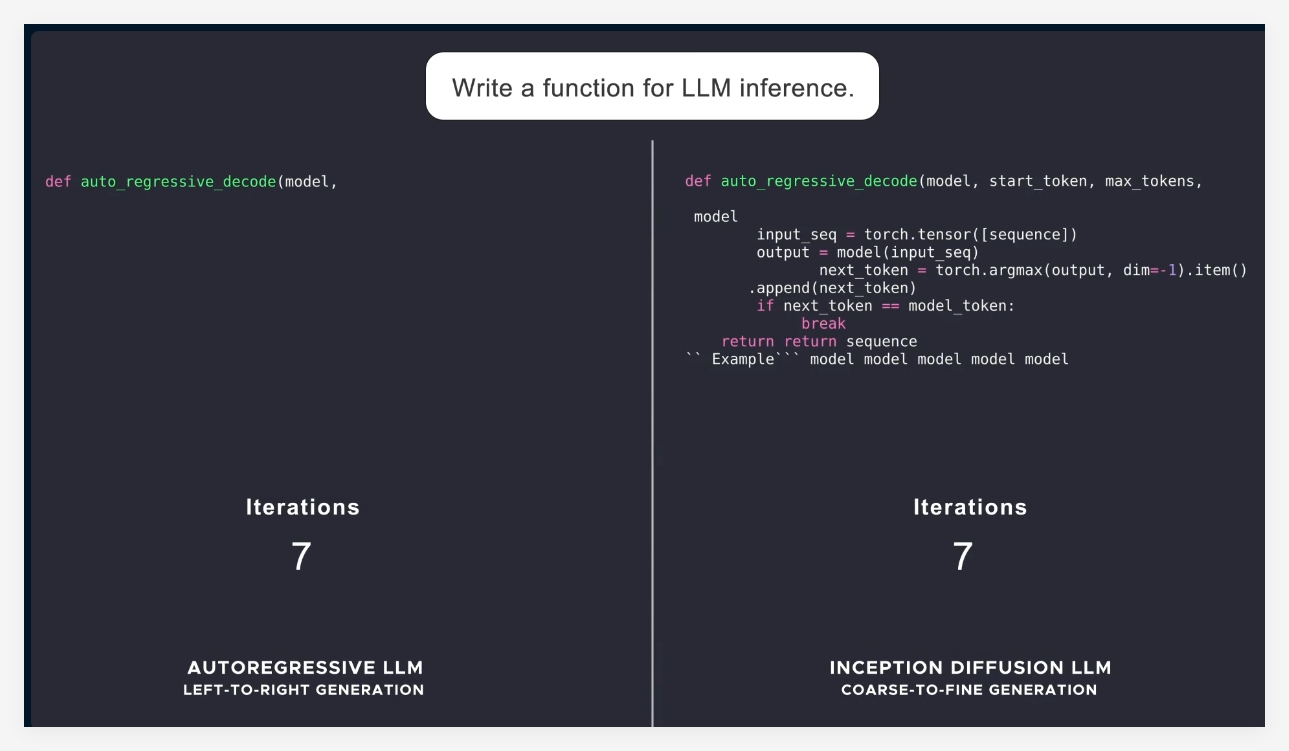

現在の言語モデルの多くは、自己回帰方式を採用しており、左から右へトークンを逐次生成するため、生成プロセスは必然的にシーケンシャルになり、遅延と計算コストが高くなります。一方、Mercuryは「粗から細」への生成方式を採用し、純粋なノイズから始めて、数回の「ノイズ除去」ステップを経て、徐々に詳細な出力を生成します。これにより、Mercuryモデルは生成時に複数トークンの並列処理が可能になり、より優れた推論と構造化された応答能力を実現しています。

Mercuryシリーズの発表により、Inception Labsは、拡散モデルがテキストとコード生成分野における巨大な可能性を示しました。次に、同社はチャットアプリケーション向けの言語モデルを発表し、拡散言語モデルの適用範囲をさらに拡大する予定です。これらの新しいモデルは、より強力なインテリジェントエージェント能力を備え、複雑な計画と長時間の生成を行うことができます。同時に、その効率性により、スマートフォンやノートパソコンなどのリソースの限られたデバイスでも動作します。

総じて、Mercuryの発表は人工知能技術における重要な進歩を示しており、速度と効率の大幅な向上だけでなく、業界に高品質なソリューションを提供しています。

公式紹介: https://www.inceptionlabs.ai/news

オンライン体験: https://chat.inceptionlabs.ai/

要点:

🌟 Mercuryシリーズ拡散型大規模言語モデル(dLLMs)が登場、生成速度は毎秒1000トークンに向上。

🚀 Mercury Coderはコード生成に特化し、ベンチマークテストで多くの既存モデルを凌駕する優れた性能を発揮。

💡 拡散モデルの革新的な手法により、テキスト生成がより効率的で正確になり、インテリジェントエージェントアプリケーションに新たな可能性を提供。