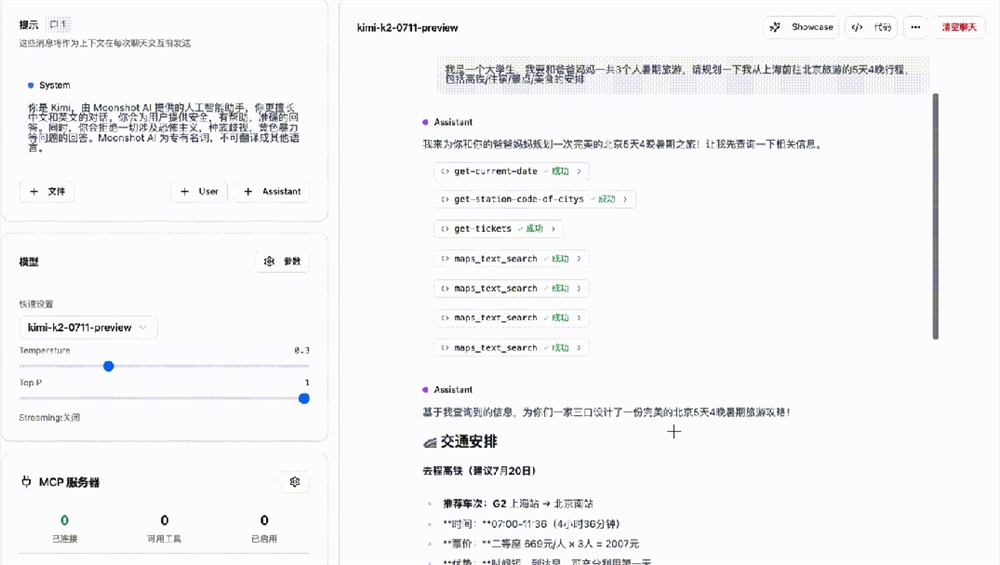

先日、マイクロソフトの研究チームは、BitNet b1.582B4Tというオープンソースの大規模言語モデルを発表しました。このモデルは20億のパラメータを持ち、独自の1.58ビット低精度アーキテクチャでネイティブにトレーニングされています。従来の訓練後の量子化方式と比較して、BitNetは計算資源の必要性が大幅に削減されています。

マイクロソフトの説明によると、このモデルの非埋め込みメモリ使用量はわずか0.4GBで、Gemma-31Bの1.4GBやMiniCPM2Bの4.8GBなど、市場にある他の同種製品をはるかに下回っています。

BitNetの高効率性能は、革新的なアーキテクチャ設計によるものです。従来の16ビット数値を放棄し、カスタムのBitLinear層を採用することで、重みを-1、0、+1の3つの状態に制限し、三値システムを形成しています。これにより、各重みの情報保存に必要なビット数は約1.58ビットに削減されます。さらに、層間の活性化値は8ビット整数で量子化され、W1.58A8の構成となっています。マイクロソフトはTransformerアーキテクチャにも調整を加え、平方ReLU活性化関数、標準回転位置埋め込み(RoPE)、subln正規化を導入することで、低ビット数トレーニングの安定性を確保しています。

開発プロセスでは、BitNetは3つの段階を経てきました。まず、4兆トークンのウェブデータ、コード、合成数学データセットを用いて事前トレーニングを行い、次に公開および合成命令データセットを用いて教師あり微調整を行い、最後に直接選好最適化(DPO)手法を用いて、UltraFeedbackなどのデータセットを用いてモデルの対話能力と安全性を向上させました。

マイクロソフトのテスト結果によると、BitNetはGSM8K(数学)やPIQA(物理常識)などのベンチマークテストで非常に優れた性能を示し、主流の10億~20億パラメータの全精度モデルと同等の全体的な性能を達成しつつ、エネルギー消費(トークンあたり0.028ジュール)とCPUデコード遅延(29ミリ秒)において明確な優位性を持っています。

BitNetは大きな可能性を示していますが、その高効率性はマイクロソフトが提供する専用のC++フレームワークbitnet.cppに依存しています。Hugging Face transformersライブラリなどの一般的なツールでは、その速度とエネルギー消費の利点を完全に発揮できません。マイクロソフトは今後、GPUとNPUのサポートを最適化し、コンテキストウィンドウを4096トークンに拡張し、より大規模なモデルや多言語機能の開発も検討しています。現在、BitNet b1.582B4TはMITライセンスの下、Hugging Faceプラットフォームで公開されており、多くの開発者や研究者がテストや利用を行うことができます。

論文:https://arxiv.org/html/2504.12285v1

huggingface:https://huggingface.co/microsoft/bitnet-b1.58-2B-4T

要点:

🌟 20億パラメータでメモリ使用量はわずか0.4GBと、同種製品を大幅に下回ります。

🔧 従来の16ビット数値を放棄し、1.58ビット低精度で重みを保存する革新的なアーキテクチャを採用しています。

🚀 Hugging Faceで公開されており、マイクロソフトはモデルの機能と性能の更なる最適化を計画しています。