最近、MiniMax社は新たなモデル「MiniMax-M1」の発表を行いました。このモデルは、世界初となるオープンソースの大規模ハイブリッドアーキテクチャ推論モデルで、生産性を重視した複雑なシナリオにおいて卓越したパフォーマンスを示し、オープンソースモデルの中でも突出しています。MiniMax-M1は国内のクローズドソースモデルを上回り、海外の最先端モデルに匹敵するだけでなく、業界内でも最もコストパフォーマンスが高い点が特徴です。

MiniMax-M1の最大の特徴の一つは、最大100万のコンテキスト入力をサポートすることです。これはクローズドソースモデルのGoogle Gemini2.5Proと同等であり、DeepSeek R1の8倍の能力を持ちます。また、最大8万トークンの推論結果を出力できます。この成果はMiniMax独自の「ライトニングアテンションメカニズム」を基盤としたハイブリッドアーキテクチャによるもので、長文コンテキストの処理や深い推論において効率を大幅に向上させています。例えば、8万トークンでの深い推論を行う際、MiniMax-M1はDeepSeek R1よりも約30%の計算能力しか必要とせず、トレーニングや推論プロセス全体で計算効率の優位性を示しています。

さらに、MiniMaxはより高速な強化学習アルゴリズム「CISPO」を提案しました。これは重要なサンプリング重みをクリッピングすることで強化学習の効率を向上させる手法です。AIMEの実験では、CISPOアルゴリズムは字節が最近提案した「DAPO」を含む他の強化学習アルゴリズムよりも収束速度が2倍速く、DeepSeekが以前使用していた「GRPO」アルゴリズムと比べても非常に優れた結果を示しました。これらの技術革新により、MiniMax-M1の強化学習プロセスは異常なほど効率的で、わずか512個のH800を使用して3週間で完了し、レンタルコストも大幅に削減され、当初の予想よりもコストが1桁少なかったことが証明されました。

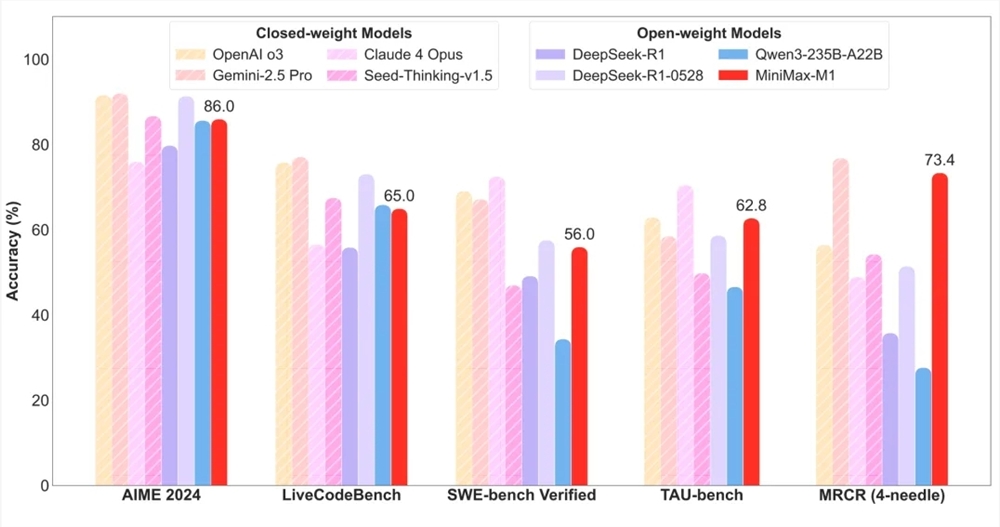

評価面では、MiniMax-M1は業界標準の17つの評価セットすべてで優れた結果を達成しています。特にソフトウェアエンジニアリング、長文コンテキストの理解、ツールの利用など、生産性を重視した複雑なシナリオにおいては、MiniMax-M1が顕著な優位性を示しています。例えば、SWE-bench検証ベンチマークでは、MiniMax-M1-40kとMiniMax-M1-80kがそれぞれ55.6%と56.0%のスコアを記録しました。DeepSeek-R1-0528の57.6%には及ばないものの、他のオープンソースモデルを大きく上回っています。また、100万級のコンテキストウィンドウを活用したMiniMax-M1は、長文理解タスクにおいて他のすべてのオープンソースモデルを凌駕し、一部の分野ではOpenAI o3やClaude4Opusと肩を並べるほどの実績を収め、グローバルランキングで第2位となっています。

特に注目すべきは、MiniMax-M1がタスク代理ツール使用シナリオ(TAU-bench)においてもすべてのオープンソースモデルをリードし、Gemini-2.5Proにも勝利したことです。さらに、MiniMax-M1-80kはほとんどのベンチマークテストにおいてMiniMax-M1-40kを上回るパフォーマンスを示し、計算資源の拡張の有効性を立証しました。

価格面では、MiniMax-M1は業界内で最も低い価格を維持しています。MiniMaxのAPPやWebサイトでは、ユーザーが無制限で無料でこのモデルを利用でき、公式サイトでは競争力のある価格でAPIサービスを購入することができます。この取り組みにより、MiniMax-M1の市場での普及と活用がさらに促進されることが期待されます。