Willkommen bei der Rubrik „AI-Tagesbericht“! Hier finden Sie Ihren täglichen Leitfaden zur Erkundung der Welt der Künstlichen Intelligenz. Täglich präsentieren wir Ihnen die wichtigsten Themen aus dem KI-Bereich, mit Fokus auf Entwickler, um Ihnen zu helfen, Technologietrends zu erkennen und innovative KI-Produktanwendungen kennenzulernen.

Neue KI-Produkte hier entdecken: https://top.aibase.com/

1. Claude 3.5 Sonnet-Modell erhält PDF-Verarbeitungsfunktion

Das von Anthropic kürzlich veröffentlichte Claude 3.5 Sonnet-Modell verfügt nun über eine PDF-Verarbeitungsfunktion. Benutzer können damit Text- und visuelle Elemente in PDF-Dokumenten analysieren, einschließlich Bildern, Diagrammen und Tabellen. Es eignet sich für diverse Anwendungsfälle.

【AiBase Zusammenfassung:】

📄 Das Claude 3.5 Sonnet-Modell bietet jetzt die Verarbeitung von PDF-Dateien mit Text- und Bildanalyse.

🖼️ Die Verarbeitung umfasst Textextraktion, Seiten-zu-Bild-Umwandlung und umfassende Analyse.

💰 Die Kosten hängen von der Dokumentlänge und -dichte ab. Es gelten Beschränkungen bezüglich Dateigröße und Seitenzahl.

2. OpenAI o1-Modell komplett enthüllt: Extrem leistungsstark, verarbeitet 200.000 Token

Ich habe das kürzlich enthüllte OpenAI o1-Modell bewertet. Es wird als das leistungsstärkste Modell von OpenAI bezeichnet und kann große Textmengen verarbeiten und Bilder analysieren. Es eignet sich besonders für komplexe Schlussfolgerungen und kreative Aufgaben. Die vollständige Version wird voraussichtlich später in diesem Jahr erscheinen und hat in der KI-Community großes Interesse geweckt. Die Nutzer erwarten gespannt die Erfahrung mit dem o1-Modell.

【AiBase Zusammenfassung:】

🌟 Das o1-Modell war kurzzeitig verfügbar und kann ca. 200.000 Wörter verarbeiten und Bilder analysieren.

🚀 OpenAI bezeichnet es als sein „leistungsstärkstes Modell“, geeignet für komplexe Schlussfolgerungen und kreative Aufgaben.

📅 Die vollständige Version ist noch nicht veröffentlicht, wird aber voraussichtlich später in diesem Jahr erscheinen.

3. Schluss mit zufälliger Generierung! Runway präsentiert erweiterte Kamerasteuerung – Regie führen leicht gemacht

Die neue erweiterte Kamerasteuerung von Runway ermöglicht es Benutzern, die Kamerabwegung in virtuellen Szenen wie ein Regisseur zu steuern. Dies bietet beispiellose Flexibilität und Kontrolle bei der Erstellung von AI-Videos. Benutzer können horizontale Bewegungen, Rundum-Aufnahmen, Positionsänderungen und Loop-Aufnahmen realisieren, was die kreativen Möglichkeiten enorm erweitert. Diese Funktion verändert die Arbeitsweise mit digitalen Kameras und ermöglicht nahtlose Übergänge und verbesserte Szenenkomposition.

【AiBase Zusammenfassung:】

🎥 Benutzer können die Kamerabwegung in virtuellen Szenen präzise steuern wie ein Regisseur und verschiedene Effekte erzielen, darunter horizontale Bewegungen und Rundum-Aufnahmen.

🔍 Mit der Loop-Aufnahmefunktion mit variabler Geschwindigkeit lassen sich aufmerksamkeitsstarke visuelle Loops oder Übergänge generieren, was die kreativen Möglichkeiten enorm erweitert.

📽️ Die erweiterte Kamerasteuerung ermöglicht die präzise Kontrolle über die Darstellung von Szenen und Motiven und versetzt den Zuschauer in eine lebensechte, scheinbar 3D-Welt.

Mehr Infos: https://top.aibase.com/tool/runway

4. Nur 60+ zahlende Nutzer, aber 30.000 € monatlicher Umsatz! Das Erfolgsgeheimnis des Open-Source-KI-Chattools LobeChat

Das LobeChat-Team erzielte in der öffentlichen Cloud-Testphase seines Open-Source-KI-Chattools LobeChat erste Erfolge: Ein monatlicher Umsatz von über 30.000 € wurde erreicht, aber die niedrige Zahl der zahlenden Nutzer stellt eine Herausforderung dar. Das Team plant, dieses Problem durch differenzierte Funktionen und Anpassung des Abonnementmodells zu lösen und gleichzeitig die Herausforderungen im Produktdesign anzugehen. Der Gewinnraum ist begrenzt, daher wird der MRR-Wert (Monthly Recurring Revenue) im Auge behalten, um nachhaltiges Wachstum zu sichern.

【AiBase Zusammenfassung:】

📈 LobeChat Cloud-Service erzielte einen monatlichen Umsatz von über 30.000 €, mit über 60 zahlenden Nutzern – ein vielversprechendes Zeichen für die Kommerzialisierung.

🔍 Die niedrige Conversion-Rate von weniger als 1% ist möglicherweise auf den starken Wettbewerb und funktionale Unterschiede zurückzuführen.

💡 Das LobeChat-Team plant, differenzierte Funktionen einzuführen und das Abonnementmodell anzupassen, wobei der MRR-Wert für nachhaltiges Wachstum im Fokus steht.

Mehr Infos: https://lobechat.com/welcome

5. Diffusion-Modelle können auch „verallgemeinern“? Alibabas IC-LoRA verleiht Bildgenerierungsmodellen episodisches Gedächtnis

Neueste Forschungsergebnisse aus dem Alibaba Tongyi-Labor zeigen, dass bestehende Text-zu-Bild-Diffusion-Transformer-Modelle bereits in der Lage sind, mehrere Bilder mit spezifischen Beziehungen zueinander zu generieren. Durch den Einsatz von IC-LoRA wird das Modell intelligenter und kann mit wenigen Beispielen neue Fähigkeiten erlernen. Die Forscher haben einen einfachen und effektiven Prozess entwickelt, um die „kontextuelle Lernfähigkeit“ von Diffusion-Modellen zu aktivieren, wodurch die Trainingskosten für KI-Modelle erheblich reduziert werden und mehr Menschen an der KI-Kreation teilnehmen können. IC-LoRA stellt einen Meilenstein in der KI-Bildgenerierung dar und ermöglicht es jedem, ein Künstler zu sein.

【AiBase Zusammenfassung:】

🔍 Bestehende Text-zu-Bild-Diffusion-Transformer-Modelle können bereits mehrere Bilder mit spezifischen Beziehungen zueinander generieren.

🧠 IC-LoRA macht das Modell intelligenter, sodass es mit wenigen Beispielen neue Fähigkeiten erlernen kann.

💡 Ein einfacher und effektiver Prozess aktiviert die „kontextuelle Lernfähigkeit“ von Diffusion-Modellen.

Mehr Infos: https://ali-vilab.github.io/In-Context-LoRA-Page/

6. Revolutionär für die Videobearbeitung! Das Open-Source-Tool ComfyUI-MochiEdit ermöglicht Video-zu-Video-Konvertierung und lokale Bearbeitung

Ich habe mir schon immer vorgestellt, Videos wie Text zu bearbeiten – jetzt ist es Realität. ComfyUI-MochiEdit ist ein Open-Source-Videobearbeitungstool, das auf ComfyUI und Genmo Mochi basiert und eine völlig neue Herangehensweise an die Videobearbeitung bietet: Videos werden in Rauschen umgewandelt und dann durch Ziel-Prompts neu abgetastet, um ein neues Video zu generieren. Diese Methode ermöglicht lokale Bearbeitung und Video-zu-Video-Konvertierung, sodass Benutzer problemlos Teile eines Videos ändern können, ohne das gesamte Video bearbeiten zu müssen.

【AiBase Zusammenfassung:】

⚙️ Video-zu-Rauschen-Umwandlung und erneute Abtastung ermöglichen lokale Bearbeitung und Video-zu-Video-Konvertierung.

🎨 Eingangsvideos können in Videos mit spezifischem Stil oder Inhalt umgewandelt werden.

🔧 Benutzer können das Endergebnis durch Anpassung der Knotenparameter steuern.

Mehr Infos: https://github.com/logtd/ComfyUI-MochiEdit?tab=readme-ov-file#mochi-unsampler

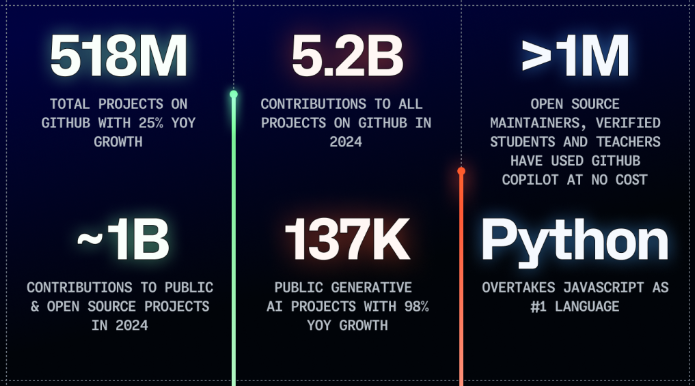

7. KI-Boom treibt es voran! Python überholt JavaScript und wird zur beliebtesten Programmiersprache auf GitHub

Python hat auf der Entwicklerplattform GitHub JavaScript überholt, hauptsächlich aufgrund des Booms der generativen KI. GitHub stellt fest, dass KI die Codequalität von Open-Source-Projekten nicht beeinträchtigt, sondern die Beiträge zu KI-Projekten sogar gefördert hat. Entwickler integrieren immer häufiger KI-Modelle in ihre Toolchains und konzentrieren sich auf kleine, effiziente Modelle und KI-Agenten zur Automatisierung. Das im Jahr 2024 am meisten beachtete Open-Source-KI-Projekt ist „ollama/ollama“, was die rasante Entwicklung im KI-Bereich verdeutlicht.

【AiBase Zusammenfassung:】

🌟 Python hat JavaScript überholt und ist die beliebteste Programmiersprache auf GitHub geworden, angetrieben vom Boom der generativen KI.

📈 Beiträge zu generativen KI-Projekten sind um 59% gestiegen, die Gesamtzahl um 98%, was die Entwicklung im KI-Bereich vorantreibt.

🤖 GitHub stellt fest, dass KI die Codequalität von Open-Source-Projekten nicht beeinträchtigt, und Entwickler zeigen großes Interesse an kleinen, effizienten Modellen und der Automatisierung durch KI-Agenten.

8. Metas neueste Technologie: Sparsh verleiht Robotern „menschenähnliches“ Tastgefühl – geschickte Manipulation wird Realität!

Die Meta FAIR Labs haben kürzlich die „Sparsh“-Technologie vorgestellt, eine künstliche multimodale Fingerspitzen-Tastwahrnehmung, die Robotern ein nahezu menschliches Tastgefühl verleiht und die Robotik revolutionieren wird. Die Technologie nutzt selbstüberwachtes Lernen und wurde mit über 460.000 Tastbildern vortrainiert. Sie unterstützt verschiedene visuelle und taktile Sensoren und verbessert die Leistung von Robotern bei taktilen Wahrnehmungsaufgaben deutlich. Das Sparsh-Modell markiert einen bedeutenden Durchbruch im Bereich der KI-Tastwahrnehmung und wird die Art und Weise, wie Roboter mit der physischen Welt interagieren, verändern.

【AiBase Zusammenfassung:】

🤖 Das Sparsh-Modell verwendet selbstüberwachtes Lernen und wurde mit über 460.000 Tastbildern vortrainiert, ohne dass manuell beschriftete Daten benötigt werden.

👆 Das Sparsh-Modell unterstützt verschiedene visuelle und taktile Sensoren wie DIGIT, GelSight 2017 und GelSight Mini und verbessert die Leistung von Robotern bei taktilen Wahrnehmungsaufgaben.

🌟 Das Sparsh-Modell zeigt hervorragende Ergebnisse auf der TacBench-Benchmark-Plattform und erzielt auch bei der Verwendung von nur 1% beschrifteter Daten zufriedenstellende Ergebnisse bei Aufgaben wie Kraftschätzung und Gleitdetektion.

Mehr Infos:

https://scontent-sjc3-1.xx.fbcdn.net/v/t39.2365-6/464969941_1107633400780143_7479102347328147009_n.pdf?_nc_cat=103&ccb=1-7&_nc_sid=3c67a6&_nc_ohc=y8Ui1HEw3BQQ7kNvgFe-ePu&_nc_zt=14&_nc_ht=scontent-sjc3-1.xx&_nc_gid=AeaFsuZziasVwPfMQsEoZqu&oh=00_AYAMqxGq0ATCySDxZWB0ZT8BgSkogYmj13c9f3ytVtkmSg&oe=672DEEE4

9. Neues Open-Source-Audiomodell Hertz-Dev: extrem niedrige Latenz für KI-Konversationen in Echtzeit

Im heutigen technologischen Umfeld sind konversationelle KI-Systeme ein wichtiger Bestandteil unseres Lebens. Das von Standard Intelligence Lab entwickelte Open-Source-Audiomodell Hertz-Dev ermöglicht KI-Konversationen in Echtzeit mit extrem niedriger Latenz und bietet neue Möglichkeiten für die Interaktion zwischen Mensch und Maschine.

【AiBase Zusammenfassung:】

🌟 Hertz-Dev ist ein Open-Source-Audiomodell mit 850 Millionen Parametern. Die theoretische Latenz beträgt nur 80 Millisekunden, die tatsächliche Latenz 120 Millisekunden, was das Echtzeit-Konversationserlebnis erheblich verbessert.

💡 Unabhängige Entwickler und Forscher können einfach auf fortschrittliche KI-Technologien für Echtzeit-Konversationen zugreifen, ohne aufwendige Hardware zu benötigen.

🚀 Die breite Anwendung von Hertz-Dev wird die Entwicklung von KI in Bereichen wie Kundensupport und Smart Home vorantreiben und die Interaktion zwischen Mensch und Maschine natürlicher gestalten.

Mehr Infos: https://github.com/Standard-Intelligence/hertz-dev

10. Ex-XPeng-Manager gründet KI-Begleitroboter-Unternehmen und sichert sich Millionen-Finanzierung!