Alibaba hat heute Abend die Video-Generations-Modell „Tongyi Wanxiang Wan2.2“ offiziell als Open Source freigegeben. Bei dieser Veröffentlichung werden drei Kernmodelle eingeführt: das Text-zu-Video-Modell (Wan2.2-T2V-A14B), das Bild-zu-Video-Modell (Wan2.2-I2V-A14B) und das einheitliche Video-Generations-Modell (Wan2.2-IT2V-5B). Dies markiert einen bedeutenden Durchbruch in der Technologie der Video-Generation.

Erstmalige Implementierung des MoE-Architekturentwurfs, Rechenleistung um 50 % gesteigert

Tongyi Wanxiang 2.2 ist das erste Video-Generations-Modell, das den MoE-(Mixture of Experts)-Architekturentwurf in Diffusionsmodellen für die Video-Generation einführt. Dadurch wird das Problem der übermäßigen Ressourcenverbrauch bei der Verarbeitung langer Token in der Video-Generation effektiv gelöst. Das Text-zu-Video-Modell und das Bild-zu-Video-Modell haben insgesamt 27 B Parameter, davon 14 B aktivierte Parameter. Sie sind die ersten Video-Generationsmodelle der Branche, die den MoE-Architekturentwurf verwenden.

Diese Architektur besteht aus einem Expertenmodell mit hoher Rauschintensität und einem Expertenmodell mit niedriger Rauschintensität, wobei jeweils die Gesamtstruktur und die Feinabstimmung des Videos bearbeitet werden. Bei gleicher Parametergröße können etwa 50 % der Rechenressourcen eingespart werden, gleichzeitig wird eine signifikante Verbesserung in Dimensionen wie komplexer Bewegungsanimation, menschlicher Interaktion und künstlerischer Ausdrucksweise erzielt.

Erstmalige Einführung des Filmästhetik-Kontrollsystems

Eine der Stärken von Wan2.2 ist das „Filmästhetik-Kontrollsystem“, das in Aspekten wie Licht, Farbe, Komposition und Mikroexpressionen auf professionalem Filmniveau liegt. Nutzer können durch Eingabe von Schlüsselwörtern wie „Abend“, „weiches Licht“, „Kantenlicht“, „warmen Ton“ oder „zentrale Komposition“ ein romantisches Bild mit goldenem Sonnenuntergang generieren lassen; durch die Kombination von „kalten Tönen“, „hartem Licht“, „ausgewogenen Kompositionen“ oder „niedrigem Winkel“ kann das Modell hingegen ein Bild erzeugen, das dem eines Science-Fiction-Films ähnelt.

Einheitliches Modell im Umfang von 5B, das auf Verbrauchergrafikkarten installiert werden kann

Tongyi Wanxiang hat zudem ein kleines einheitliches Video-Generations-Modell mit 5B Parameter veröffentlicht. Das Modell unterstützt sowohl Text-zu-Video- als auch Bild-zu-Video-Generationsfunktionen. Es verwendet eine hochkomprimierte 3D-VAE-Architektur, wobei die Zeit- und Raumkompression bis zu 4×16×16 liegt und die Informationskomprimierung auf 64 erhöht wurde, was den höchsten Wert unter den Open-Source-Modellen darstellt.

Dieses Modell benötigt nur 22 Gbyte Grafikspeicher (eine einzelne Verbrauchergrafikkarte), um innerhalb von Minuten ein 5 Sekunden langes HD-Video zu generieren. Es ist das schnellste Grundmodell zur Erzeugung von 24 Frames pro Sekunde und 720P-Bildqualität, wodurch der technische Zugang zu AI-Video-Generations-Technologien deutlich reduziert wird.

Verschiedene Kanäle für den Zugriff

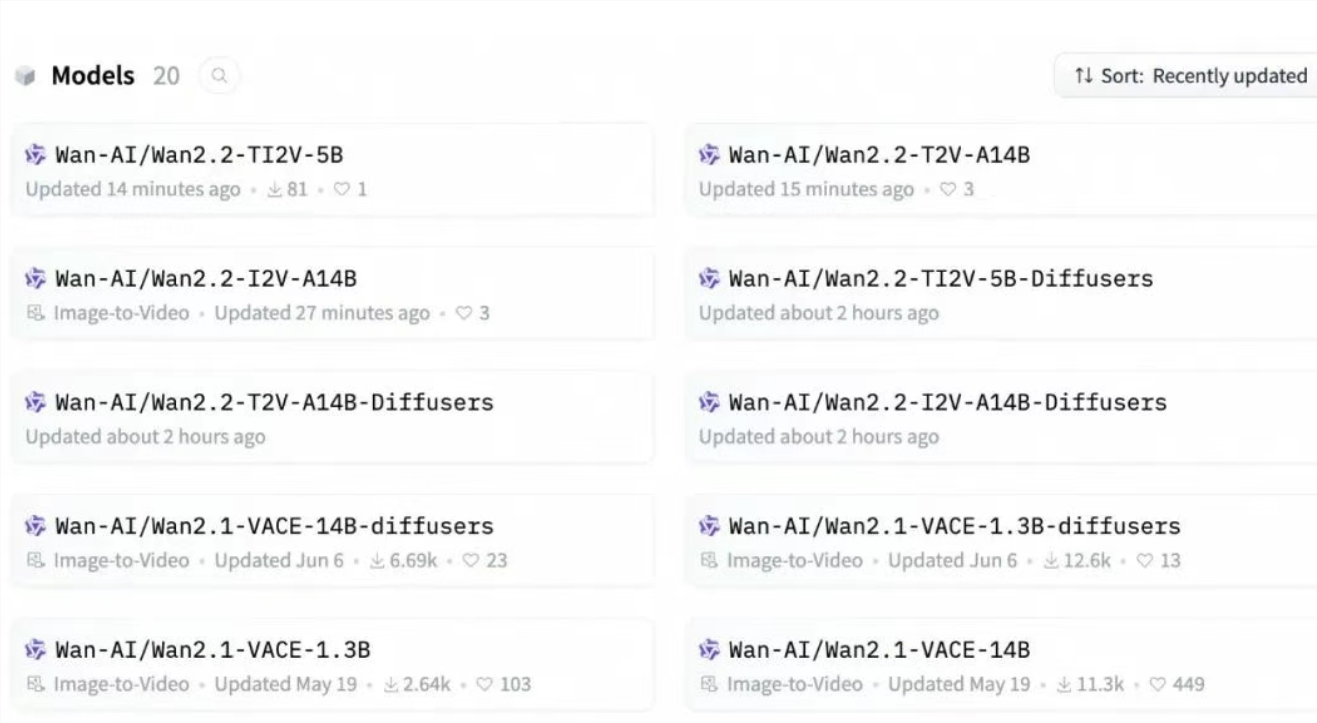

Entwickler können die Modelle und Codes auf GitHub, HuggingFace und dem Moba-Community-Portal herunterladen. Unternehmen können über Alibaba Cloud BaiLian die Modell-API aufrufen. Allgemeine Nutzer können zudem direkt die Modelle auf der offiziellen Website von Tongyi Wanxiang und in der Tongyi-APP testen.

Seit Februar dieses Jahres hat Tongyi Wanxiang kontinuierlich mehrere Modelle wie Text-zu-Video-Modell, Bild-zu-Video-Modell, Anfangs- und Endbild-Generations-Modell sowie allgemeines Bearbeitungsmodell als Open Source freigegeben. Die Download-Zahlen im Open-Source-Community liegen bereits über 5 Millionen Mal, was einen wichtigen Beitrag zur Verbreitung und Entwicklung der AI-Video-Generations-Technologie darstellt.