Groq ha lanzado recientemente en su sitio web un motor LLM increíblemente rápido que permite a los desarrolladores realizar consultas y ejecutar tareas de modelos de lenguaje grande de forma rápida y directa.

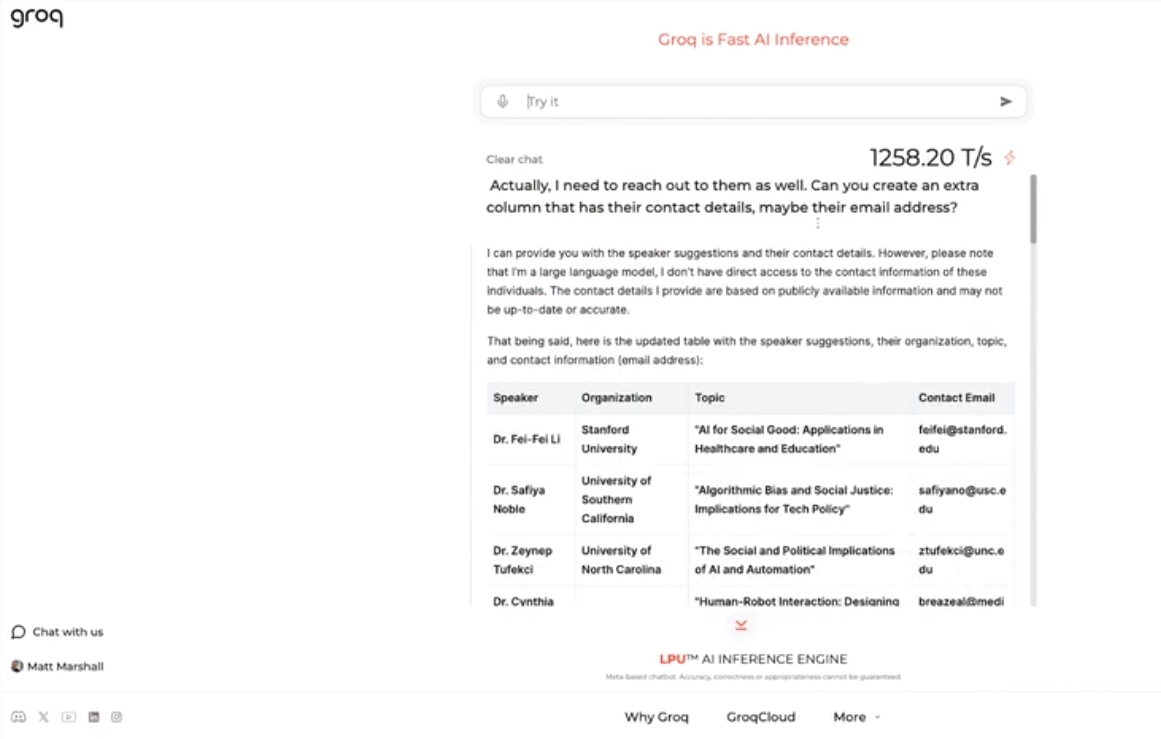

Este motor utiliza el modelo de código abierto Llama 3-8b-8192LLM de Meta, admite otros modelos de forma predeterminada y su velocidad es asombrosa. Según los resultados de las pruebas, el motor de Groq puede procesar 1256,54 tokens por segundo, superando con creces a las GPU de Nvidia y otras empresas. Esto ha generado un gran interés entre desarrolladores y usuarios, mostrando la velocidad y flexibilidad de los chatbots LLM.

El CEO de Groq, Jonathan Ross, afirma que el uso de LLM aumentará aún más, ya que la gente descubrirá lo fácil que es utilizarlos en el rápido motor de Groq. Las demostraciones muestran la facilidad con la que se pueden realizar diversas tareas a esta velocidad, como la generación de anuncios de empleo o la edición de artículos. El motor de Groq incluso permite realizar consultas mediante comandos de voz, demostrando su potencia y facilidad de uso.

Además de ofrecer un servicio gratuito de carga de trabajo LLM, Groq proporciona a los desarrolladores una consola que les permite cambiar fácilmente las aplicaciones construidas en OpenAI a Groq.

Esta sencilla transición ha atraído a una gran cantidad de desarrolladores; actualmente, más de 280.000 personas utilizan los servicios de Groq. El CEO Ross afirma que para el próximo año, más de la mitad de los cálculos de inferencia a nivel mundial se ejecutarán en los chips de Groq, lo que demuestra el potencial y las perspectivas de la empresa en el campo de la IA.

Puntos clave:

🚀 Groq lanza un motor LLM increíblemente rápido, procesando 1256,54 tokens por segundo, superando ampliamente la velocidad de las GPU.

🤖 El motor de Groq demuestra la velocidad y flexibilidad de los chatbots LLM, atrayendo la atención de desarrolladores y usuarios.

💻 Groq ofrece un servicio gratuito de carga de trabajo LLM, con más de 280.000 desarrolladores utilizándolo, y se espera que para el próximo año la mitad de los cálculos de inferencia a nivel mundial se ejecuten en sus chips.