En el campo de la aprendizaje profundo, las redes neuronales recurrentes (RNN) y los modelos Transformer tienen sus propias ventajas. Investigaciones recientes han descubierto que los modelos lineales recurrentes (como Mamba) están desafiando gradualmente el lugar del Transformer gracias a su superior capacidad para procesar secuencias. En particular, en tareas que requieren manejar secuencias extremadamente largas, los modelos recurrentes han mostrado un gran potencial, superando significativamente las limitaciones de los modelos Transformer tradicionales.

Los modelos Transformer suelen verse limitados por una ventana de contexto fija al tratar con contextos largos, y su complejidad computacional aumenta rápidamente a medida que aumenta la longitud de la secuencia, lo que lleva a una disminución en el rendimiento. Por otro lado, los modelos lineales recurrentes pueden manejar secuencias largas de manera más flexible, lo que es una de sus principales ventajas. Sin embargo, en el pasado, los modelos recurrentes no mostraban un buen rendimiento en secuencias cortas, lo que limitaba su aplicación práctica.

Recientemente, investigadores de la Universidad Carnegie Mellon y Cartesia AI han propuesto un método innovador para mejorar la capacidad de generalización de los modelos recurrentes en secuencias largas. Descubrieron que solo se necesitan 500 pasos de intervención de entrenamiento simple para que los modelos recurrentes puedan manejar secuencias de hasta 256k, demostrando una capacidad de generalización asombrosa. Este estudio muestra que los modelos recurrentes no tienen defectos fundamentales, sino que su potencial aún no ha sido plenamente explotado.

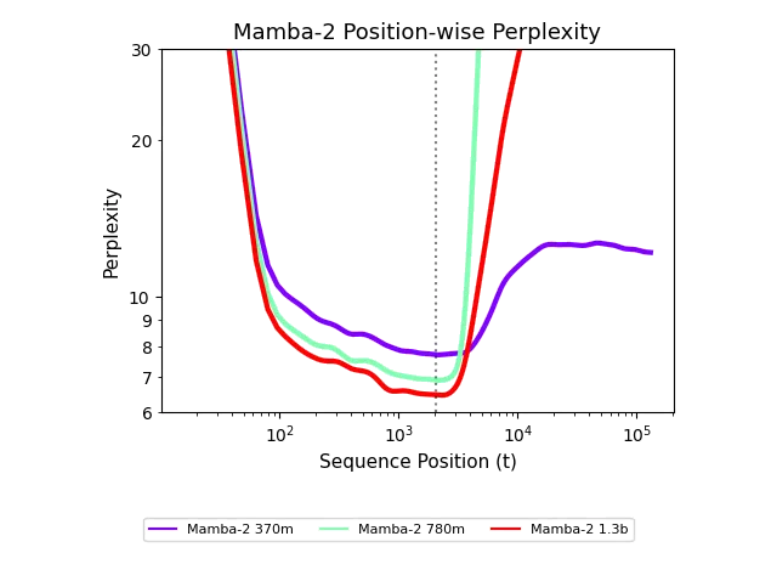

El equipo de investigación propuso un nuevo marco de interpretación llamado "hipótesis de estado no explorado". Esta hipótesis señala que los modelos recurrentes solo entran en contacto con una distribución limitada de estados durante el entrenamiento, lo que hace que su rendimiento sea deficiente cuando se enfrentan a secuencias más largas. Para lograr una generalización en la longitud, los investigadores propusieron una serie de medidas de intervención en el entrenamiento, incluyendo el uso de ruido aleatorio, ajuste de ruido y transmisión de estado. Estas medidas permiten que el modelo se generalice eficazmente durante el entrenamiento en secuencias largas, mejorando significativamente su rendimiento.