Meta et une équipe de chercheurs de l’Université de Waterloo ont collaboré pour développer MoCha, un système d’intelligence artificielle capable de générer des animations de personnages complètes incluant des mouvements naturels et synchronisés avec la parole. Contrairement aux modèles de génération d’animation précédents qui se concentraient uniquement sur le visage, MoCha peut restituer des mouvements corporels complets à partir de plusieurs angles de caméra, incluant la synchronisation labiale, les gestes et les interactions entre plusieurs personnages.

Améliorer la précision de la synchronisation labiale

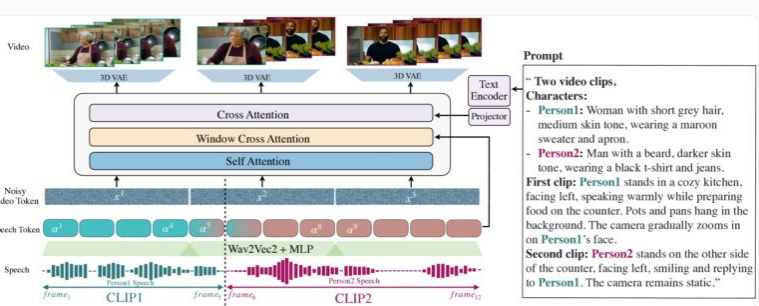

La démonstration de MoCha met l'accent sur la génération synchronisée des mouvements du haut du corps et des gestes en gros plan et en plans moyens. L’originalité du système réside dans son mécanisme d’« attention fenêtre audio-vidéo », qui résout deux défis majeurs de longue date de la génération de vidéos par IA : comment préserver la pleine résolution de l’audio lors de la compression vidéo, et comment éviter les incohérences entre les mouvements des lèvres et l’audio lors de la génération parallèle de vidéos.

L’innovation de MoCha consiste à simuler la façon dont les humains parlent en limitant l’accès à une fenêtre spécifique de données audio pour chaque image : les mouvements des lèvres sont étroitement liés au son immédiat, tandis que le langage corporel est basé sur un modèle textuel plus large. En ajoutant des marqueurs avant et après chaque fenêtre audio, MoCha permet des transitions plus fluides et une synchronisation labiale plus précise.

MoCha génère des vidéos réalistes à partir de descriptions textuelles, incluant des mouvements du visage, des gestes et des mouvements des lèvres.

Pour construire ce système, l’équipe de recherche a utilisé 300 heures de contenu vidéo soigneusement sélectionné et combiné des séquences vidéo basées sur du texte pour étendre les possibilités d’expression et d’interaction. Notamment dans les scènes à plusieurs personnages, MoCha a démontré sa puissance : il suffit de définir les personnages une seule fois, puis de les appeler facilement dans différentes scènes à l’aide d’étiquettes (comme « personnage 1 » ou « personnage 2 »), sans avoir à les décrire à nouveau.

Gestion de plusieurs personnages

Lors de tests sur 150 scénarios différents, MoCha a surpassé les systèmes similaires en termes de qualité de la synchronisation labiale et de la naturalité des mouvements. Des évaluateurs indépendants ont unanimement estimé que les vidéos générées par le système étaient extrêmement réalistes et présentaient une précision et une naturalité sans précédent.

Les chercheurs ont développé un modèle d’invite permettant aux utilisateurs de faire référence à des personnages spécifiques sans avoir à les décrire à chaque fois.

Le développement de MoCha lui confère un potentiel énorme dans de nombreux domaines d’application, notamment les assistants numériques, les avatars virtuels, la publicité et le contenu éducatif. Bien que Meta n’ait pas encore révélé si le système serait open source ou s’il s’agit toujours d’un prototype de recherche, le lancement de cette technologie ouvre sans aucun doute un nouveau chapitre pour la génération de vidéos pilotée par l’IA.

Dans un contexte de compétition de plus en plus intense dans le domaine de la technologie vidéo basée sur l’IA, le lancement de MoCha est particulièrement remarquable. Meta a récemment lancé le système MovieGen, tandis que ByteDance, la société mère de TikTok, développe ses propres outils d’animation par IA, notamment INFP, OmniHuman-1 et Goku, ce qui témoigne de l’engagement des sociétés de médias sociaux dans ce domaine.