Tencent a publié le rapport technique de TurboS, révélant les innovations centrales et les capacités puissantes de son modèle de langue phare, TurboS.

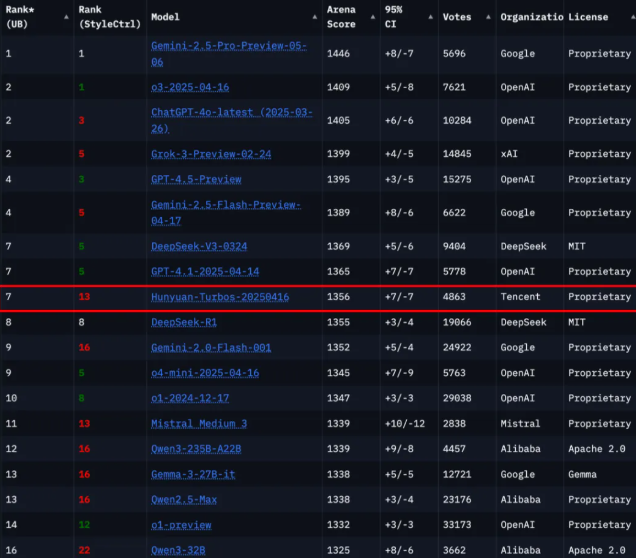

Selon le classement actualisé du plateau d'évaluation mondial des modèles de grande langue, Chatbot Arena, le modèle TurboS de Hunchun figure à la septième place parmi les 239 modèles participants, se classant parmi les meilleurs modèles nationaux derrière Deepseek et devant plusieurs institutions internationales comme Google, OpenAI et xAI.

L'architecture du modèle TurboS de Hunchun combine une structure innovante appelée Hybrid Transformer-Mamba, qui combine l'efficacité du traitement de séquences longues de l'architecture Mamba avec les avantages de la compréhension contextuelle de l'architecture Transformer, permettant ainsi un équilibre entre performance et efficacité. Ce modèle comprend un total de 128 couches et dispose de 56 milliards de paramètres activés, devenant le premier modèle mixte expert Transformer-Mamba à grande échelle déployé dans l'industrie. Grâce à cette innovation architecturale, TurboS a obtenu un score global de 1356 lors des évaluations internationales prestigieuses.

Pour améliorer encore les capacités du modèle, le système de chaîne de raisonnement adaptatif long-courant a été introduit dans TurboS, capable de basculer automatiquement en fonction de la complexité des questions. Ce mécanisme permet au modèle de répondre rapidement aux questions simples tout en fournissant des réponses précises et approfondies pour les questions complexes. De plus, une méthode post-entraînement comprenant quatre modules clés, tels que le fin-tuning supervisé et la fusion adaptative de chaînes de raisonnement (CoT), a été conçue pour renforcer encore davantage les performances du modèle.

Pendant la phase de pré-entraînement, TurboS a été formé sur une base de 16 billions de tokens, garantissant une qualité et une diversité exceptionnelles des données. L'architecture principale du modèle inclut des composants Transformer, Mamba2 et des réseaux neuronaux feed-forward (FFN), avec une construction hiérarchique optimisée pour maximiser l'efficacité de l'entraînement et de la déduction.

La publication de ce rapport technique ne montre pas seulement la force technologique de Tencent dans le domaine des modèles de grandes langues, mais offre également de nouvelles idées et directions pour l'avenir du développement des modèles de grande taille.

Lien vers le papier : https://arxiv.org/abs/2505.15431

Points clés :

🌟 Le modèle TurboS est classé septième dans Chatbot Arena, montrant une compétitivité impressionnante.

💡 L'architecture Hybrid Transformer-Mamba a atteint l'équilibre optimal entre performance et efficacité.

🔍 Le mécanisme de chaîne de raisonnement adaptative long-courant améliore la capacité du modèle à répondre à différents niveaux de complexité des questions.