Récemment, l'équipe Seed de ByteDance a collaboré avec l'Université de Hong Kong et l'Université Fudan pour présenter une nouvelle méthode d'entraînement en apprentissage par renforcement - POLARIS. Cette méthode, grâce à une stratégie d'apprentissage par renforcement optimisée, a réussi à améliorer significativement les capacités de raisonnement mathématique des petits modèles, les rendant comparables aux grands modèles, offrant ainsi une nouvelle voie pour l'optimisation des petits modèles dans le domaine de l'intelligence artificielle.

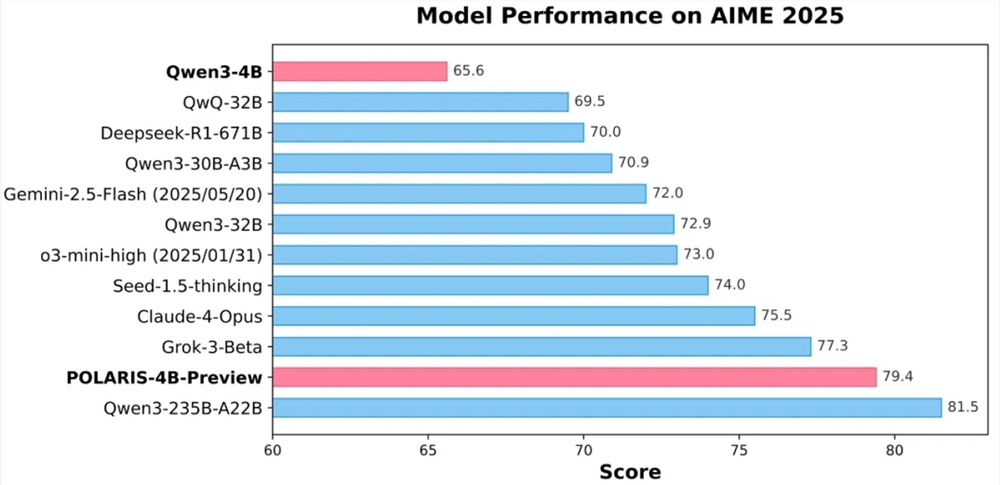

Les résultats expérimentaux montrent que le modèle open source Qwen3-4B de 4 milliards de paramètres entraîné par POLARIS a obtenu des taux d'exactitude élevés de 79,4 % et 81,2 % respectivement sur les tests mathématiques AIME25 et AIME24, dépassant certaines modèles fermés plus volumineux. En particulier, la conception légère du modèle POLARIS-4B permet un déploiement facile sur des cartes graphiques grand public, réduisant ainsi considérablement les barrières d'application.

La principale innovation de POLARIS réside dans sa stratégie d'entraînement. L'équipe de recherche a constaté qu'en adaptant les données d'entraînement et les hyperparamètres au modèle à entraîner, on peut améliorer significativement les capacités de raisonnement mathématique des petits modèles. En pratique, l'équipe a ajusté dynamiquement la distribution de difficulté des données d'entraînement, créant un ensemble de données légèrement orienté vers les problèmes difficiles, afin d'éviter une concentration excessive de la difficulté des échantillons. En outre, une stratégie d'actualisation dynamique des données a été introduite, permettant d'éliminer en temps réel les échantillons trop faciles en fonction des performances du modèle pendant l'entraînement, assurant ainsi l'efficacité de l'entraînement.

En matière de contrôle d'échantillonnage, POLARIS régule finement la température d'échantillonnage pour équilibrer les performances du modèle et la diversité des chemins de génération. La recherche a montré que la température d'échantillonnage a un impact significatif sur les performances du modèle et la diversité des chemins. Une température trop élevée ou trop basse est néfaste à l'entraînement du modèle. Par conséquent, l'équipe a proposé une méthode d'initialisation de température qui contrôle la zone d'exploration, et a ajusté dynamiquement la température d'échantillonnage pendant l'entraînement, afin de maintenir la diversité du contenu généré.

Face aux défis de l'entraînement sur longs contextes, POLARIS a introduit une technologie d'extrapolation de longueur, en ajustant l'encodage de position RoPE, permettant au modèle de traiter des séquences plus longues que celles observées lors de l'entraînement. Cette stratégie innovante compense efficacement les lacunes de l'entraînement sur textes longs, améliorant ainsi les performances du modèle sur les tâches de génération de texte long.

De plus, POLARIS utilise une méthode d'entraînement en RL à plusieurs étapes. Au début, l'entraînement se fait avec une fenêtre de contexte courte, puis lorsque les performances du modèle convergent, la longueur de la fenêtre de contexte est progressivement augmentée. Cette stratégie aide le modèle à s'adapter progressivement à des tâches de raisonnement plus complexes, améliorant ainsi la stabilité et l'efficacité de l'entraînement.

Aujourd'hui, les méthodes d'entraînement détaillées de POLARIS, les données d'entraînement, le code d'entraînement et les modèles expérimentaux sont tous disponibles en open source. L'équipe de recherche a validé l'efficacité de POLARIS sur plusieurs jeux de tests de raisonnement courants. Les résultats montrent que les modèles de différentes tailles et familles de modèles ont vu leurs performances améliorées de manière significative après l'application de la méthode d'entraînement POLARIS.

Page GitHub :

https://github.com/ChenxinAn-fdu/POLARIS

Page Hugging Face :

https://huggingface.co/POLARIS-Project