Qwen3-4B a été lancé par Qwen. Ce nouveau modèle, grâce à sa petite taille et à ses performances puissantes, ouvre de nouvelles possibilités pour le déploiement d'intelligence artificielle sur les appareils terminaux.

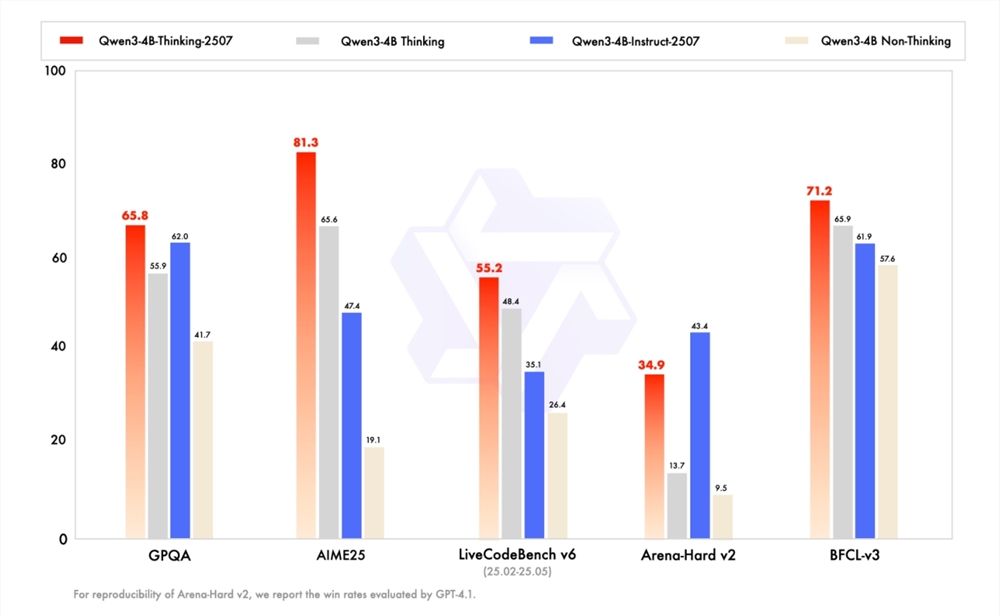

Au cours des deux dernières semaines, l'équipe de développement a mis à jour les versions « 2507 » Instruct/Thinking de Qwen3-235B-A22B et Qwen3-30B-A3B. Ensuite, elle a encore travaillé dur pour présenter les modèles Qwen3-4B-Instruct-2507 et Qwen3-4B-Thinking-2507, plus petits. Ces nouveaux modèles ont obtenu une amélioration significative des performances, en particulier dans les domaines non liés à la réflexion : Qwen3-4B-Instruct-2507 dépasse largement GPT4.1-Nano, un modèle commercial fermé, tandis que Qwen3-4B-Thinking-2507, dans le domaine de la réflexion, montre des performances remarquables, pouvant rivaliser avec Qwen3-30B-A3B (thinking) de taille moyenne.

L'équipe de développement est convaincue que les petits modèles linguistiques (SLM) ont une valeur extrêmement importante pour le développement de l'intelligence artificielle agente (Agentic AI). Le modèle Qwen3-4B de la version « 2507 » lancée cette fois-ci est non seulement petit mais aussi performant, et très compatible avec le déploiement sur des appareils terminaux tels que les téléphones portables. Actuellement, le nouveau modèle est désormais disponible gratuitement sur la communauté ModelScope et Hugging Face, attirant ainsi l'attention et l'expérience de nombreux développeurs.

Les capacités générales du Qwen3-4B-Instruct-2507 ont connu une amélioration significative. Son performance dépasse le modèle commercial fermé à petite échelle GPT-4.1-nano, et même se rapproche de celle du Qwen3-30B-A3B (non-thinking) de taille moyenne. De plus, ce modèle couvre davantage de connaissances de langues rares, renforce l'alignement des préférences humaines dans les tâches subjectives et ouvertes, et peut fournir des réponses plus adaptées aux besoins des gens. Plus surprenant encore, sa capacité à comprendre le contexte s'étend jusqu'à 256K, permettant même à un petit modèle de traiter facilement des textes longs.

En même temps, les capacités de raisonnement du Qwen3-4B-Thinking-2507 ont également connu une amélioration considérable. Dans l'évaluation AIME25 axée sur les compétences mathématiques, ce modèle a obtenu un score impressionnant de 81,3 points avec seulement 4 milliards de paramètres, suffisamment pour rivaliser avec le modèle Qwen3-30B-Thinking de taille moyenne. De plus, ses capacités générales ont également augmenté significativement, dépassant même le modèle Qwen3-30B-Thinking plus grand. Il dispose également d'une capacité de compréhension du contexte de 256K de tokens, supportant ainsi des scénarios plus complexes tels que l'analyse de documents, la génération de contenus longs et le raisonnement entre paragraphes.

Avec le lancement de la série de modèles Qwen3-4B, les perspectives d'applications de l'intelligence artificielle sur les appareils terminaux deviennent plus vastes. Nous espérons bientôt voir plus d'applications innovantes basées sur ce modèle, apportant plus de commodité à la vie et au travail des gens.