À minuit, heure de Pékin, aujourd’hui, l’entreprise OpenAI a officiellement annoncé le lancement du modèle GPT-5. Le PDG d’OpenAI, Sam Altman, a déclaré lors de la conférence de presse que c’était une étape importante vers l’intelligence artificielle générale (AGI), et qu’interagir avec le GPT-5 était aussi naturel et fluide qu’avec un expert humain.

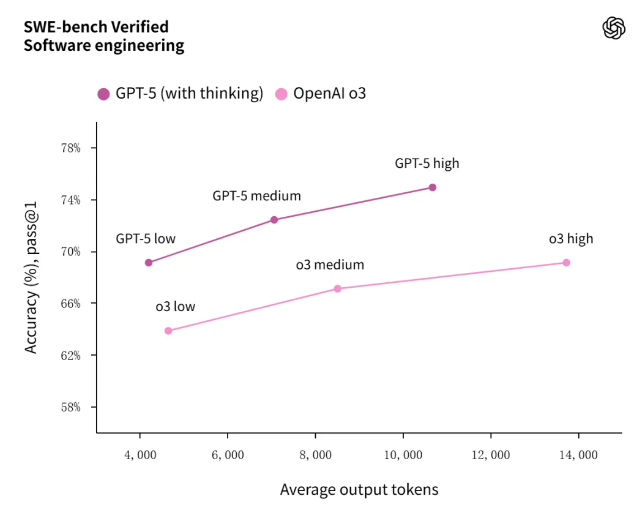

Lors de la conférence de presse, l’équipe d’OpenAI a présenté en détail le modèle GPT-5. Ce modèle a obtenu d’excellents résultats dans plusieurs tests de référence, comme Swe Bench, établissant ainsi un nouveau niveau. Les principales améliorations concernent l’amélioration de la fiabilité et la précision des faits.

En ce qui concerne le plan de lancement, OpenAI a annoncé que le GPT-5 serait disponible pour les utilisateurs gratuits, les abonnés Plus et Pro à partir d’aujourd’hui. Les utilisateurs gratuits pourront l’utiliser gratuitement, mais avec des limites de quota ; les abonnés Plus et Pro bénéficieront d’un accès plus étendu.

Durant la démonstration en direct, le GPT-5 a montré des capacités impressionnantes. Lorsqu’il a été demandé d’expliquer l’effet de Bernoulli, il a répondu rapidement ; lorsqu’il a été chargé de créer des effets visuels, bien que le temps de réponse ait été légèrement plus long, il a accompli la tâche avec succès. Les utilisateurs peuvent également demander au GPT-5 de « réfléchir profondément » ou de « être plus précis » dans des prompts spécifiques, voire voir son processus de pensée. Dans la démonstration de programmation, le GPT-5 s’est révélé extraordinaire, produisant plus de 200 lignes de code en quelques minutes, créant un site web comprenant de nombreux éléments visuels et audio, conçu pour aider les utilisateurs à apprendre le français.

Aparté ses compétences en programmation, le GPT-5 verra bientôt l'arrivée d'une fonctionnalité vocale. Lors de la démonstration en direct, ChatGPT a répondu en utilisant un seul mot dans le mode vocal, et a résumé efficacement : « La fierté et les préjugés constituent le « relation humaine ».

La fonctionnalité de mémoire (Memory) de ChatGPT a également été mise à jour. Les abonnés Pro, Plus et Teams pourront connecter ChatGPT à leur compte Google, accéder aux contenus du calendrier, et interagir avec Gmail et Google Calendar. Cela signifie que le GPT-5 pourra obtenir davantage de contexte à partir des emplois du temps quotidiens des utilisateurs, et même rappeler aux utilisateurs de répondre à leurs courriels. Cette fonctionnalité sera d’abord lancée pour les utilisateurs Pro la semaine prochaine, puis étendue aux abonnés Plus et Teams.

Concernant la sécurité et la prévention de la tromperie, OpenAI a mis beaucoup de soin. L’objectif du GPT-5 est d’aider les utilisateurs autant que possible, tout en restant dans les limites de sécurité. Contrairement aux modèles précédents, tels qu’o3, qui refusaient directement de répondre en disant qu’il s’agissait d’une question de sécurité, le GPT-5 expliquera pourquoi il ne peut pas aider et guidera l'utilisateur vers des tiers ou des manuels pour obtenir de l'information.

Le lancement du GPT-5 inclut trois modèles : GPT-5, GPT-5mini et GPT-5nano, tous avec une longueur de contexte de 400K et une sortie maximale de 128K tokens. En termes de prix API, le coût d'entrée pour chaque million de tokens est de 1,25 dollar pour le GPT-5, et de 10 dollars pour la sortie ; pour le GPT-5mini, le coût d'entrée est de 0,25 dollar par million de tokens, et de 2 dollars pour la sortie ; pour le GPT-5nano, le coût d'entrée est de 0,05 dollar par million de tokens, et de 0,40 dollar pour la sortie.

Il convient de noter que le GPT-5 adopte pour la première fois une architecture intégrée tripartite, composée du GPT-5-main, du GPT-5-thinking et d’un mécanisme de routage en temps réel, accompagné d’une version mini qui se met automatiquement en marche lorsque les quotas sont épuisés. Le mécanisme de routage en temps réel agit comme un « régulateur de circulation », capable de sélectionner le modèle le plus adapté en fonction du scénario de conversation, de sa complexité, des besoins en outils et de l'intention de l'utilisateur, tout en s'évolutionnant continuellement grâce aux retours des utilisateurs réels. Les utilisateurs gratuits de ChatGPT peuvent également expérimenter le GPT-5, mais avec des limites de quota, passant ensuite au GPT-5-mini si ces limites sont dépassées ; les abonnés Plus, Pro, Teams, entreprises et éducation reçoivent des quotas plus élevés ou un accès illimité selon leur niveau d’abonnement, et les utilisateurs Pro peuvent avoir un accès exclusif au mode GPT-5Pro.

Dans plusieurs tests de référence, le GPT-5 a obtenu d’excellents résultats. Lors du concours mathématique américain AIME 2025, la version sans outil a obtenu 94,6 %, tandis que l'utilisation de Python a porté le score à 99,6 %, et le mode Pro a atteint la note maximale. Dans le test SWE-bench, considéré comme une autorité en ingénierie logicielle, le GPT-5-thinking a battu le record avec 74,9 %, loin devant o3 avec 69,1 %. Dans le sous-ensemble HealthBench Hard du domaine de la santé, le GPT-5-thinking est passé de 31,6 % à 46,2 %, prenant la tête mondiale. Du point de vue de la sécurité, le taux d'erreurs dans les scénarios à haut risque est 50 fois inférieur à celui du GPT-4o, et le taux de « hallucinations » potentielles est 8 fois inférieur à celui de o3, avec zéro erreur dans les scénarios de santé à l'échelle mondiale. Cependant, pendant la démonstration en direct, une petite erreur est survenue : le graphique de la présentation officielle a malheureusement représenté la barre de o3 sur SWE-bench à la même hauteur que celle de 4o, ce qui a provoqué des commentaires humoristiques.

OpenAI souligne que les données d'entraînement du GPT-5 proviennent toujours du réseau public, des partenariats autorisés et du contenu généré par les utilisateurs, mais ont été significativement réduites grâce à une stratégie de filtrage améliorée et à l'API de modération ; l'apprentissage par renforcement a été utilisé pour la première fois dans la chaîne de raisonnement « penser avant de répondre », améliorant ainsi la logique et la précision du modèle.