हाल ही में, बाइटडैंस सीड टीम ने हांगकांग विश्वविद्यालय और फूदन विश्वविद्यालय के साथ मिलकर एक नई मजबूत सीखने की विधि - पोलरिस लॉन्च की। इस विधि ने डिज़ाइन किए गए स्केलिंग आरएल रणनीति के माध्यम से, छोटे मॉडल की गणितीय तर्क क्षमता को अत्यधिक बड़े मॉडल के स्तर तक बढ़ा दिया, जो कि कृत्रिम बुद्धिमत्ता के क्षेत्र में छोटे मॉडल अनुकूलन के लिए एक नई राह प्रदान करता है।

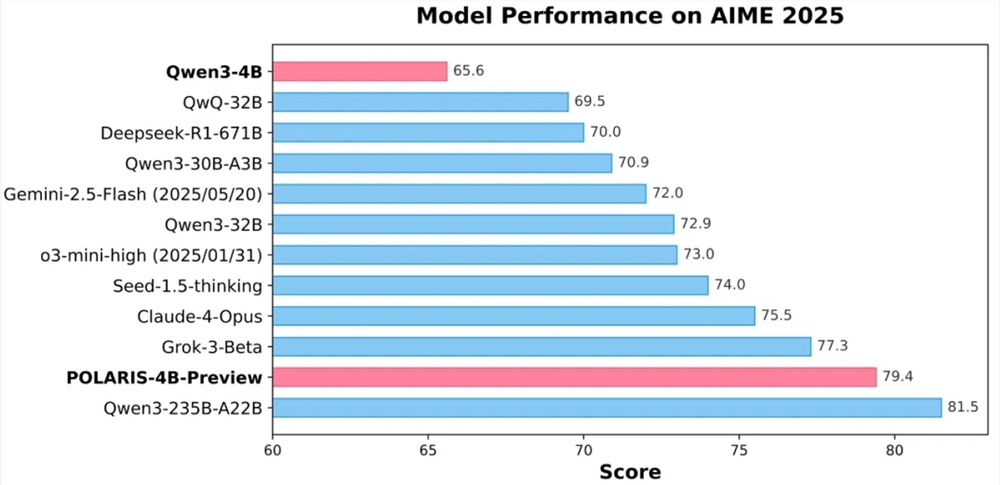

परीक्षण परिणामों के अनुसार, पोलरिस से प्रशिक्षित 4 बिलियन पैरामीटर ओपन सोर्स मॉडल Qwen3-4B ने AIME25 और AIME24 गणितीय परीक्षण में क्रमशः 79.4% और 81.2% की उच्च सटीकता प्राप्त की, जो कि कुछ बड़े पैमाने पर बंद मॉडल से भी बेहतर है। विशेष रूप से, पोलरिस-4B मॉडल के हल्के डिज़ाइन के कारण, यह उपभोक्ता स्तर के ग्राफिक्स कार्ड पर आसानी से स्थापित किया जा सकता है, जो अनुप्रयोग के प्रवेश के बाधाओं को काफी कम करता है।

पोलरिस का मुख्य नवाचार इसकी प्रशिक्षण रणनीति में है। अनुसंधान टीम ने पाया कि अपने प्रशिक्षण मॉडल के आसपास विशेष रूप से डेटा और सुपरपैरामीटर सेटिंग के माध्यम से, छोटे मॉडल की गणितीय तर्क क्षमता को बहुत अधिक सुधारा जा सकता है। व्यावहारिक अभ्यास में, टीम ने प्रशिक्षण डेटा के कठिनाई वितरण को डायनामिक रूप से समायोजित किया, कठिन समस्याओं के थोड़ा झुकाव वाले डेटा सेट बनाए जिससे सैंपल कठिनाई बहुत अधिक केंद्रित न हो। साथ ही, डेटा के डायनामिक अपडेट रणनीति का भी उपयोग किया गया, जो मॉडल के प्रशिक्षण प्रक्रिया में प्रदर्शन के आधार पर बहुत आसान सैंपल को तत्काल हटा देता है, ताकि प्रशिक्षण की प्रभावशीलता सुनिश्चित रहे।

नमूना नियंत्रण के बारे में, पोलरिस नमूना तापमान के सूक्ष्म नियंत्रण के माध्यम से मॉडल के प्रदर्शन और उत्पन्न पथ के विविधता के बीच संतुलन बनाए रखता है। अनुसंधान खोज के अनुसार, नमूना तापमान मॉडल प्रदर्शन और पथ विविधता पर निर्णायक प्रभाव डालता है, उच्च या निम्न तापमान दोनों ही मॉडल प्रशिक्षण के लिए अनुकूल नहीं होते। इसलिए, टीम ने खोज क्षेत्र के तापमान प्रारंभिक मान की रणनीति प्रस्तावित की, और प्रशिक्षण के दौरान डायनामिक रूप से नमूना तापमान को समायोजित किया, ताकि उत्पन्न सामग्री की विविधता बनी रहे।

लंबे संदर्भ प्रशिक्षण की चुनौतियों के लिए, पोलरिस ने लंबाई बढ़ाओ तकनीक का उपयोग किया, जो स्थिति कोड RoPE के समायोजन के माध्यम से मॉडल को अधिक लंबे अनुक्रमों के साथ निपटने की अनुमति देता है। यह नवाचार रणनीति लंबे लेख प्रशिक्षण में कमी की भरपाई करती है, और लंबे लेख उत्पादन कार्य में मॉडल के प्रदर्शन को बढ़ाती है।

इसके अलावा, पोलरिस ने बहु-चरण RL प्रशिक्षण विधि का उपयोग किया, जहां शुरू में छोटे संदर्भ विंडो का उपयोग किया जाता है, जब मॉडल के प्रदर्शन स्थिर हो जाता है, तब धीरे-धीरे संदर्भ विंडो की लंबाई बढ़ाई जाती है। यह रणनीति मॉडल के लिए अधिक जटिल तर्क कार्यों के साथ धीरे-धीरे अनुकूलित होने में मदद करती है, जो प्रशिक्षण की स्थिरता और प्रभावशीलता को बढ़ाती है।

वर्तमान में, पोलरिस के विस्तृत प्रशिक्षण विधि, प्रशिक्षण डेटा, प्रशिक्षण कोड और प्रयोग मॉडल पूरी तरह से ओपन सोर्स हैं। अनुसंधान टीम ने कई मुख्य तर्क परीक्षण सेट पर पोलरिस की प्रभावशीलता की जांच की, जिसके परिणामों से पता चलता है कि पोलरिस प्रशिक्षण विधि के उपयोग से विभिन्न आकार के मॉडल और विभिन्न मॉडल परिवारों के प्रदर्शन में महत्वपूर्ण सुधार हुआ।

GitHub मुख्य पृष्ठ:

https://github.com/ChenxinAn-fdu/POLARIS

Hugging Face मुख्य पृष्ठ:

https://huggingface.co/POLARIS-Project