Recentemente, o Instituto de Automação da Academia Chinesa de Ciências e a equipe Zhongke Zidong Taichu lançaram um novo método — Vision-R1, que utiliza a técnica de aprendizado por reforço semelhante ao R1 para melhorar significativamente a capacidade de localização visual. Este método não apenas alcançou uma melhoria de desempenho de 50% em tarefas complexas como detecção de objetos e localização visual, mas também superou os modelos de ponta (SOTA) existentes com mais de 10 vezes o tamanho de parâmetros.

Atualmente, os grandes modelos de texto e imagem geralmente dependem do método "pré-treinamento + ajuste supervisionado" para melhorar sua capacidade de resposta a instruções do usuário, mas este método apresenta grandes desafios em termos de consumo de recursos e eficiência de treinamento. O Vision-R1 inova ao combinar dados de alinhamento de instruções de alta qualidade e aprendizado por reforço, mudando essa situação. O método fornece um forte suporte à capacidade de localização de objetos do modelo através do design de um mecanismo de recompensa impulsionado pela avaliação de tarefas visuais.

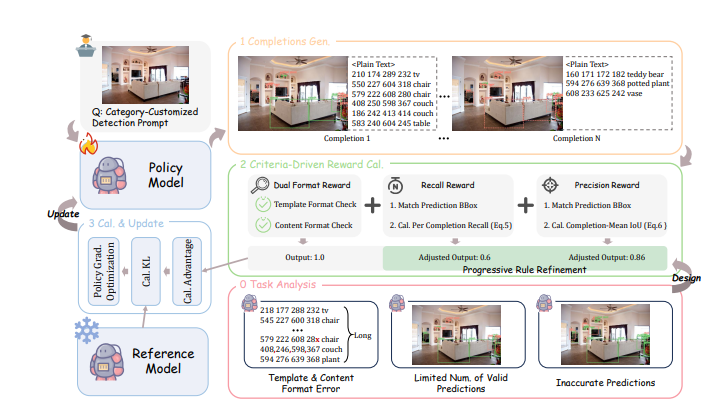

Especificamente, o mecanismo de recompensa do Vision-R1 inclui quatro partes principais: primeiro, ele emprega uma abordagem de previsão multi-objetivo para garantir uma avaliação eficaz da qualidade da previsão em cenários densos; segundo, um sistema de recompensa de formato duplo é projetado para resolver problemas de erros de formato em previsões de sequências longas; terceiro, a recompensa de recuperação incentiva o modelo a identificar o máximo possível de objetos; e por último, a recompensa de precisão garante uma qualidade superior das caixas delimitadoras geradas pelo modelo. Essas arquiteturas interagem, criando um efeito de otimização "1+1>2", fazendo com que o modelo tenha um desempenho ainda melhor em tarefas visuais complexas.

Para enfrentar o desafio de prever caixas delimitadoras de alta qualidade, a equipe de pesquisa também propôs uma estratégia de ajuste de regras progressivo, ajustando dinamicamente as regras de cálculo de recompensa para impulsionar a melhoria contínua do desempenho do modelo. O processo de treinamento é dividido em estágios inicial e avançado, aumentando gradualmente os padrões de recompensa para alcançar uma transição de precisão básica para alta precisão.

Em uma série de testes, o Vision-R1 exibiu desempenho excepcional nos conjuntos de dados clássicos de detecção de objetos COCO e ODINW-13 em cenários diversos. Independentemente do desempenho básico, após o treinamento com o Vision-R1, o desempenho do modelo melhorou significativamente, aproximando-se ainda mais dos modelos de localização profissionais. Este método não apenas melhora efetivamente a capacidade de localização visual de grandes modelos de texto e imagem, mas também fornece novas direções para futuros aplicativos de IA multimodal.

Endereço do projeto: https://github.com/jefferyZhan/Griffon/tree/master/Vision-R1