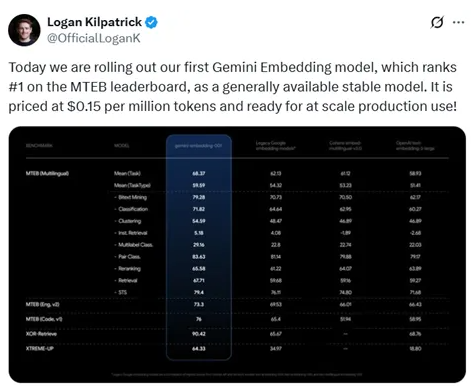

O Google lançou oficialmente seu primeiro modelo de embedding Gemini às 1h da manhã em 15 de julho de 2023. O modelo obteve uma pontuação alta de 68,37 no benchmark de texto múltiplo (MTEB), ficando em primeiro lugar, superando os 58,93 pontos da OpenAI. Este resultado demonstra não apenas a liderança do Google na tecnologia de embedding, mas também oferece uma opção mais econômica para criadores independentes e profissionais freelancers: o custo de uso do modelo Gemini Embedding é de 0,15 dólares por 1 milhão de tokens.

A potente funcionalidade do modelo Gemini Embedding

De acordo com os resultados dos testes, o modelo Gemini Embedding se destacou em várias tarefas, como mineração de dupla língua, classificação, agrupamento, recuperação de instruções, classificação de múltiplas etiquetas, classificação de pares, reordenação, recuperação e similaridade de textos semânticos, tornando-se o modelo de embedding mais forte atualmente. Sua capacidade multilíngue aumenta seu potencial de aplicação em escala global, especialmente entre um grande número de usuários que não têm inglês como língua materna.

Estrutura do modelo e inovações tecnológicas

O modelo Gemini Embedding foi projetado com uma arquitetura codificador de Transformer bidirecional, mantendo a mecanismo de atenção bidirecional do modelo Gemini, aproveitando plenamente sua capacidade de compreensão linguística pré-treinada. Com base nos 32 níveis inferiores de Transformer, o modelo adicionou uma camada de pooling para aglomerar os embeddings de cada token da sequência de entrada, gerando um único vetor de embedding. A estratégia de pooling médio é simples e eficaz, melhorando a adaptabilidade do modelo.

Método de treinamento e controle de qualidade dos dados

Na fase de treinamento, o modelo Gemini Embedding adotou uma estratégia de treinamento em etapas múltiplas, dividida em duas etapas: pré-ajuste e ajuste fino. Na etapa de pré-ajuste, o modelo foi treinado com dados de grandes coleções Web, com o objetivo principal de adaptar os parâmetros das tarefas de geração autoregressiva para as tarefas de codificação. Na fase de ajuste fino, o modelo foi treinado de forma mais detalhada com dados de tarefas específicas, garantindo um desempenho eficiente nas tarefas de recuperação, classificação e agrupamento.

Para melhorar a qualidade dos dados, a equipe de pesquisa desenvolveu uma estratégia de geração de dados sintéticos e utilizou o Gemini para filtrar os dados de treinamento, removendo amostras de baixa qualidade e garantindo a eficácia do modelo durante o treinamento.

O lançamento do modelo Gemini Embedding marca uma importante evolução do Google na tecnologia de embedding, reforçando sua competitividade no campo de inteligência artificial. À medida que esse modelo for amplamente adotado, espera-se que impulso o desenvolvimento de aplicações como busca e recomendações personalizadas.

Endereço de experiência: https://aistudio.google.com/prompts/new_chat