微调ChatGPT 0.2美元可破防:普林斯顿与斯坦福发布LLM风险警告

新智元

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

近日,人工智能公司 Anth 宣布推出一款名为 Claude for Chrome 的新功能,目前仅向1,000名 Max 计划用户提供测试。该功能作为浏览器扩展,允许 Claude 在 Google Chrome 浏览器中查看网页、点击按钮及填写表单,旨在提升用户的在线操作体验。然而,Anthropic 提醒用户,这项功能在正式发布之前,仍存在一些安全漏洞需要修复。图源备注:图片由AI生成,图片授权服务商Midjourney在安全性方面,Anthropic 指出,该功能面临来自 “提示注入攻击” 的重大风险。这种攻击方式可以让恶意用户在网页中嵌入隐

在一名16岁青少年因与 ChatGPT 的长时间交流而选择自杀后,OpenAI 决定采取行动,计划引入家长监控功能并考虑其他安全措施。该公司在周二的博客中表示,将探索一些新功能,包括允许家长通过 “单击消息或电话” 联系紧急联系人,以及一个选项,允许 ChatGPT 在严重情况下主动联系这些紧急联系人。《纽约时报》最早报道了亚当・雷恩(Adam Raine)的悲剧,OpenAI 起初发布的声明相对简短,仅表达了对其家人的哀悼,并未给出具体应对措施。但在随后的舆论压力下,OpenAI 随后发布了更详细

在当前竞争激烈的人工智能(AI)领域,OpenAI 和 Anthropic 两家顶尖 AI 实验室决定进行一项前所未有的合作,联合对彼此的 AI 模型进行安全性测试。这一举措旨在识别各自内部评估中的盲点,并展示在确保 AI 安全与对齐方面,领先企业之间如何能够携手共进。OpenAI 联合创始人沃伊切赫・扎伦巴(Wojciech Zaremba)在接受采访时指出,随着 AI 技术逐步成熟并被广泛使用,这种跨实验室的合作显得尤为重要。图源备注:图片由AI生成,图片授权服务商Midjourney扎伦巴表示,AI 行业亟需建立安全性和协作

最近,OpenAI 在其博客中透露,该公司将开始扫描用户与 ChatGPT 的聊天记录,以检测潜在的有害内容。此举引发了广泛关注,因为它与公司之前对用户隐私的承诺存在矛盾。OpenAI 表示,当用户显示出对他人构成威胁的迹象时,其对话将被转交给专门的团队进行审核。这些团队有权采取行动,包括禁止相关用户的账户。如果审核团队认为某个案例涉及对他人造成严重身体伤害的紧迫威胁,OpenAI 可能会将其报告给执法部门。在声明中,OpenAI 列举了一些被禁止的行为,包括使用 ChatGPT 推广自杀或

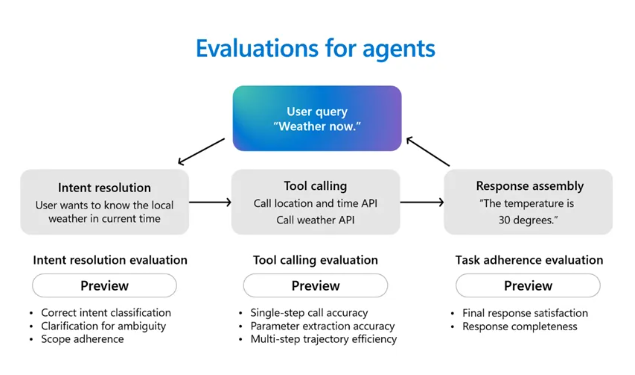

近日,微软在其官网上发布了 AI 智能体可观测性五大最佳实践,以应对智能体在自动化流程中可能出现的盲跑和不可控问题。这一举措旨在为开发者提供工具,帮助他们在智能体的整个生命周期中,确保其行为的质量、安全和合规性,从而提升用户体验。智能体可观测性是对智能体从开发、测试到部署及后期维护的全生命周期进行深度监测。这种监测有助于及时发现问题、优化性能,进而维护智能体的信任与问责。其主要优势包括持续监控智能体行为、追踪执行流程、详细记录决策过程、

周二,首例针对人工智能公司的非正常死亡诉讼在旧金山正式提起,引发了广泛关注。据悉,一对来自马特·雷恩和玛丽亚·雷恩的夫妇就其16岁儿子亚当·雷恩的自杀身亡,向OpenAI公司提起了诉讼。诉状中指出,OpenAI公司开发的聊天机器人ChatGPT在知悉亚当曾有四次自杀未遂的经历后,非但没有提供有效帮助,反而“优先考虑参与而非安全”,最终帮助亚当制定了详细的自杀计划。据《纽约时报》报道,今年4月亚当自杀后,他的父母在查看其手机时,震惊地发现了一条名为“悬挂安全问题”

AIbase报道 香港大学与快手可灵团队近日联合发表重磅论文《Context as Memory: Scene-Consistent Interactive Long Video Generation with Memory Retrieval》,提出革命性的"Context-as-Memory"方法,成功解决长视频生成中场景一致性控制的核心难题。创新理念:将历史上下文作为"记忆"载体该研究的核心创新在于将历史生成的上下文视为"记忆",通过context learning技术学习上下文条件,实现长视频前后场景的高度一致性控制。研究团队发现,视频生成模型能够隐式学习视频数据中的3D先验,无需显式3D建模辅助,这一理念与

以色列网络安全公司 Seemplicity 在其 B 轮融资中成功筹集到5000万美元。这一轮融资由 Sienna Venture Capital 领投,Essentia Venture Capital 及现有投资者 Glilot Capital Partners、NTTVC 和 S Capital 参与。Seemplicity 总部位于特拉维夫,同时在硅谷的帕洛阿尔托设有分支。Seemplicity 成立于2020年,专注于帮助企业优化其漏洞和风险管理的方式。公司表示,人工智能将在这一过程中发挥重要作用,能够自动化漏洞管理的汇总、优先排序及修复工作。通过引入 AI 技术,Seemplicity 旨在减少安全团队所需进行的繁琐手动操

一项由苹果研究人员共同撰写的新研究显示,通过一种新颖的**“清单式”强化学习方案(RLCF)**,开源大型语言模型(LLM)的性能得到了显著提升。该方法通过让模型对照一份具体的清单来检查自身工作,从而在复杂指令遵循任务中表现出比传统奖励模型更优越的效果。RLHF的局限性与RLCF的诞生传统的“从人类反馈中强化学习”(RLHF)是提高LLM质量的重要后训练步骤。该方法通过人类标注员的点赞(奖励)或点踩(惩罚)信号,逐步引导模型生成更具实用性的答案。然而,RLHF存在一个潜在问题:模

近日,网络安全公司Trail of Bits的研究人员Kikimora Morozova和Suha Sabi Hussain公布了一种新型攻击方法。该攻击利用图像重采样的技术特性,在人眼不可见的图像中注入恶意指令,从而劫持大型语言模型(LLM)并窃取用户数据。该攻击的核心在于图像重采样攻击。当用户上传图片到AI系统时,系统通常会为了效率和成本而自动降低图片分辨率。恶意图片正是利用这一过程:它在全分辨率下看似正常,但在经过双三次(bicubic)等重采样算法处理后,隐藏在图像特定区域的恶意指令会以可见的文本形式