Mit der raschen Entwicklung der KI-Technologie wird die Qualität der Videoerzeugung mit erstaunlicher Geschwindigkeit verbessert, von ursprünglich unscharfen Clips bis hin zu heutzutage äußerst realistischen generierten Videos. Dennoch bleibt das Fehlen von Kontroll- und Bearbeitungsfähigkeiten für generierte Videos ein dringendes Problem. Erst mit der neuesten Forschung von NVIDIA und seinen Partnern, DiffusionRenderer, wurde eine neue Lösung für dieses Problem präsentiert.

DiffusionRenderer ist eine wegweisende Forschungsergebnis, das nicht nur Videos generieren kann, sondern auch die 3D-Szenen in den Videos verstehen und bearbeiten kann. Dieses Modell verbindet die Generierung und Bearbeitung nahtlos und entfesselt großes Potenzial für kI-gestützte Inhaltskreation. Frühere Technologien wie Physik-basierte Rendering (PBR) zeigten sich bei der Erzeugung von hochrealistischen Videos gut, konnten jedoch Szenenbearbeitungen nicht bewältigen. DiffusionRenderer verarbeitet 3D-Szenen auf einzigartige Weise und überwindet diese Einschränkung.

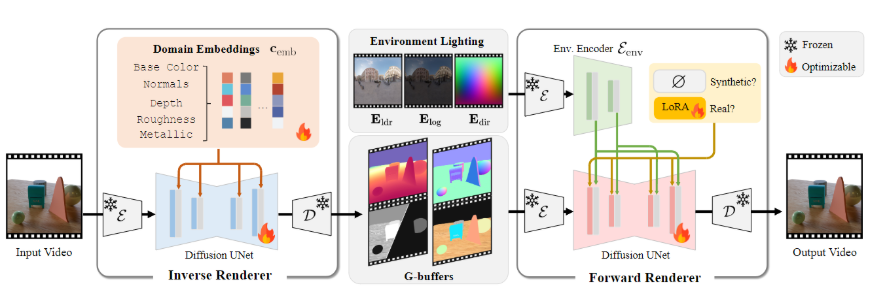

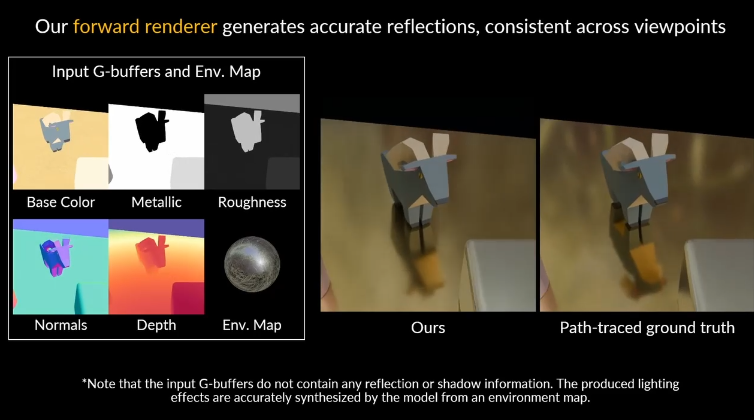

Dieses Modell verwendet zwei neuronale Renderer. Zuerst der neuronale inverse Renderer, der einen Eingabevideo analysiert und aus ihm geometrische und Material-Eigenschaften der Szene extrahiert, um die benötigten Daten-Puffer zu generieren; anschließend der neuronale Vorwärtsrenderer, der diese Daten mit den gewünschten Lichtbedingungen kombiniert, um hochwertige, realistische Videos zu erzeugen. Die Zusammenarbeit beider ermöglicht es DiffusionRenderer, eine starke Anpassungsfähigkeit bei der Verarbeitung realer Daten zu zeigen.

Das Forschungsteam hat eine einzigartige Datenstrategie für DiffusionRenderer entworfen und ein umfangreiches synthetisches Datenset mit 150.000 Videos erstellt, als Grundlage für das Lernen des Modells. Darüber hinaus nutzten sie auch ein Datenset mit 10.510 echten Videos, um automatisch Szenenattributetags zu generieren, sodass das Modell besser auf die Eigenschaften echter Videos reagieren kann.

Die Leistung von DiffusionRenderer ist beeindruckend. In Vergleichstests mit verschiedenen Aufgaben zeigte es Vorteile gegenüber anderen Methoden. Es kann nicht nur realistischere Lichteffekte in komplexen Szenen erzeugen, sondern kann auch bei der inversen Rendering-Prozess genaue Schätzung der Materialeigenschaften der Szene liefern.

Die praktischen Anwendungsmöglichkeiten dieser Technologie sind groß. Benutzer können mit DiffusionRenderer dynamische Beleuchtung, Materialbearbeitung und nahtlose Objekteinfügung durchführen. Der Benutzer muss lediglich ein Video bereitstellen, um leicht Änderungen und Neukreationen der Szene vorzunehmen. Die Veröffentlichung dieser Technologie markiert einen wichtigen Sprung im Bereich der Video-Rendering und -Bearbeitung und bietet mehr Kreativen und Designern größere Freiheit bei der kreativen Arbeit.

- Demo Video https://youtu.be/jvEdWKaPqkc

- github : https://github.com/nv-tlabs/cosmos1-diffusion-renderer

- Projektseite: https://research.nvidia.com/labs/toronto-ai/DiffusionRenderer/

Wichtige Punkte:

🌟 DiffusionRenderer bringt neue Möglichkeiten für die 3D-Szenenerstellung, indem es Generierung und Bearbeitungsfunktionen kombiniert.

🎥 Das Modell nutzt die Zusammenarbeit zwischen dem neuronalen inversen Renderer und dem neuronalen Vorwärtsrenderer, um die Realismus und Anpassungsfähigkeit des Videorenderings zu verbessern.

🚀 Seine praktischen Anwendungen umfassen dynamische Beleuchtung, Materialbearbeitung und Objekteinfügung, wodurch Kreative leichter mit Videoerstellung arbeiten können.