Im Zeitalter der schnellen Entwicklung der KI-Technologie hat die Gruppe für Naturliche Sprachverarbeitung am Institut für Computertechnik der Chinesischen Akademie der Wissenschaften ein Multimodal-Modell namens Stream-Omni entwickelt. Der Kernvorteil dieses Modells besteht darin, dass es gleichzeitig verschiedene Modus-Interaktionsweisen unterstützen kann und so einen flexibleren und reichhaltigeren Nutzererlebnis bietet.

Volle Unterstützung von Multimodal-Interaktion

Stream-Omni ist ein multimodales großes Modell, das auf der GPT-4o-Architektur basiert und hervorragende Fähigkeiten in Text-, Bild- und Sprachmodi zeigt. Durch Dienste für Online-Spracheingabe können Benutzer nicht nur mit Sprache interagieren, sondern auch während des Prozesses Echtzeit-Textergebnisse erhalten, wodurch die Interaktionserfahrung natürlicher wird, als würde man „zugleich sehen und hören“.

Innovative Modus-Alignierung

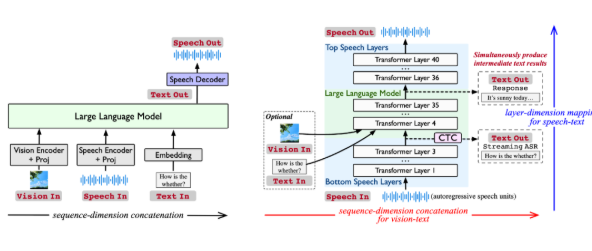

Derzeitige multimodale große Modelle verknüpfen oft die Darstellungen verschiedener Modi und geben sie in das große Sprachmodell ein, um eine Antwort zu generieren. Dieser Ansatz jedoch ist auf große Datenmengen angewiesen und fehlt an Flexibilität. Stream-Omni modelliert die Beziehungen zwischen den Modi gezielter, wodurch der Bedarf an umfangreichen drei Modi-Daten reduziert wird. Es betont die semantische Kohärenz zwischen Sprache und Text und ermöglicht es dem visuellen Inhalt, semantisch mit dem Text komplementär zu sein, was eine effizientere Modus-Alignierung ermöglicht.

Starke Sprachinteraktionsfunktionen

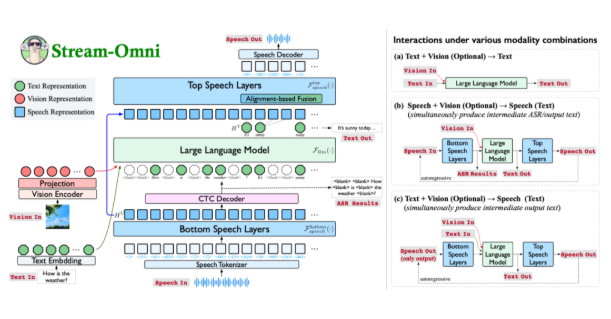

Die einzigartige Sprachmodellierung von Stream-Omni ermöglicht es während der Sprachinteraktion, wie bei GPT-4o, Zwischen-Texttranskriptionsergebnisse auszugeben. Diese Gestaltung bietet den Nutzern eine umfassendere multimodale Interaktionserfahrung, insbesondere in Szenarien, in denen eine Echtzeit-Umwandlung von Sprache in Text erforderlich ist, was die Effizienz und Bequemlichkeit erheblich steigert.

Flexible Interaktion mit beliebigen Modus-Kombinationen

Die Gestaltung von Stream-Omni ermöglicht es, durch flexible Kombination von Bildcodierern, Sprachschichten und großem Sprachmodellen verschiedene Modus-Kombinationen für die Interaktion zu unterstützen. Diese Flexibilität ermöglicht es den Nutzern, je nach Szenario frei die Eingabemethode auszuwählen, ob Text, Sprache oder Bild – in jedem Fall können konsistente Antworten erzielt werden.

In verschiedenen Experimenten ist die visuelle Verständnisfähigkeit von Stream-Omni mit denen von visuellen großen Modellen im gleichen Maßstab vergleichbar, während seine Fähigkeiten zur Sprachinteraktion deutlich besser sind als die bestehenden Technologien. Diese hierarchische Sprach-Text-Zuordnungsmechanik stellt eine präzise semantische Ausrichtung zwischen Sprache und Text sicher und ermöglicht somit konsistentere Antworten unterschiedlicher Modi.

Stream-Omni bietet nicht nur neue Ansätze für die multimodale Interaktion, sondern fördert durch seine flexiblen und effizienten Eigenschaften auch die tiefgreifende Integration von Text-, Bild- und Sprachtechnologien. Obwohl es noch Verbesserungspotenzial in Bezug auf menschenähnliche Darstellung und Vielfalt der Stimmen gibt, legt es zweifellos eine solide Grundlage für zukünftige multimodale intelligente Interaktionen.

Link zum Papier: https://arxiv.org/abs/2506.13642

Open Source Code: https://github.com/ictnlp/Stream-Omni

Modelldownload: https://huggingface.co/ICTNLP/stream-omni-8b