Google lanzó oficialmente y abrió el código fuente de su nuevo modelo de gran tamaño multimodal para dispositivos de borde, Gemma3n, esta innovadora solución trae funciones multimodales poderosas que antes solo se podían experimentar en la nube a dispositivos como teléfonos, tablets y portátiles.

Características principales: pequeño tamaño, gran capacidad

Gemma3n ofrece dos versiones, E2B y E4B. Aunque las cantidades iniciales de parámetros son 5B y 8B respectivamente, mediante innovaciones arquitectónicas, su uso de memoria es equivalente al de modelos tradicionales de 2B y 4B, pudiendo ejecutarse con solo 2GB y 3GB de memoria respectivamente. Este modelo admite nativamente la entrada y procesamiento multimodal de imágenes, audio, video y texto, y soporta la comprensión multimodal en 140 idiomas de texto y 35 idiomas.

Destaca mencionar que la versión E4B obtuvo una puntuación superior a 1300 en la evaluación LMArena, convirtiéndose en el primer modelo con menos de 10 mil millones de parámetros en alcanzar este estándar, logrando mejoras significativas en multilingüismo, matemáticas, codificación y capacidad de razonamiento.

Innovaciones tecnológicas: cuatro arquitecturas revolucionarias

Arquitectura MatFormer: Gemma3n utiliza una nueva arquitectura Matryoshka Transformer, que permite incluir varios tamaños dentro de un solo modelo, como los muñecos rusos. Durante el entrenamiento del modelo E4B, se optimiza simultáneamente el submodelo E2B, brindando a los desarrolladores opciones flexibles de rendimiento. Mediante la tecnología Mix-n-Match, los usuarios pueden crear modelos personalizados entre E2B y E4B.

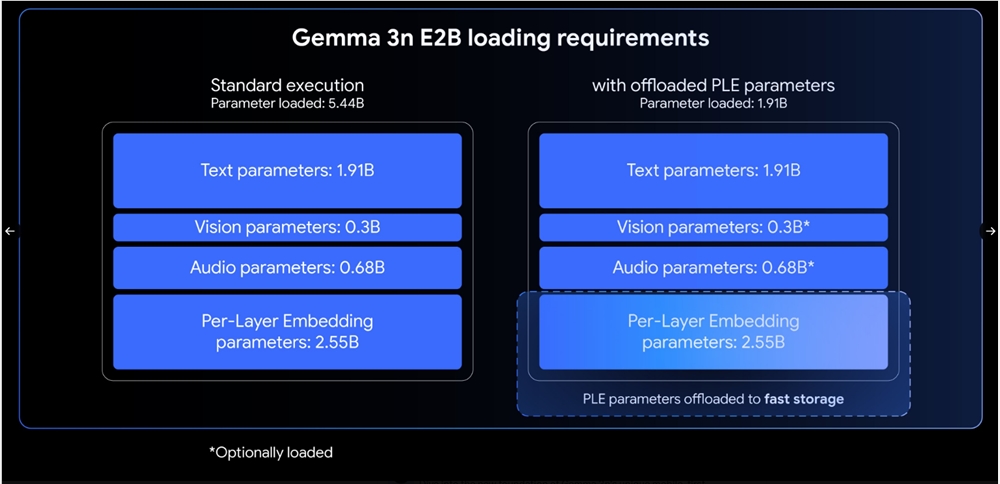

Tecnología de incrustación por capa (PLE): Esta innovación permite cargar y calcular la mayoría de los parámetros en la CPU, mientras que solo los pesos principales de Transformer deben almacenarse en la memoria del acelerador, mejorando significativamente la eficiencia de la memoria sin afectar la calidad del modelo.

Compartir caché KV: Optimizado para el procesamiento de contenido largo, mediante la tecnología de compartición de caché clave-valor, el rendimiento de prellenado se duplica en comparación con Gemma34B, acelerando significativamente el tiempo de generación del primer token en secuencias largas.

Codificador avanzado: En el ámbito del audio, se utiliza un codificador basado en el modelo de voz universal (USM), que admite reconocimiento automático de voz y traducción de voz, pudiendo procesar fragmentos de audio de hasta 30 segundos. En el ámbito visual, se incluye un codificador MobileNet-V5-300M, que admite múltiples resoluciones de entrada, alcanzando hasta 60 cuadros por segundo en Google Pixel.

Funciones prácticas y aplicaciones

Gemma3n destaca especialmente en la traducción de voz, especialmente en la conversión entre inglés y español, francés, italiano y portugués. El codificador visual MobileNet-V5, gracias a tecnologías avanzadas de distilación, logra una aceleración de 13 veces en comparación con el modelo base, reduciendo los parámetros en un 46% y el uso de memoria en un 400%, manteniendo al mismo tiempo una mayor precisión.

Ecosistema abierto y perspectivas futuras

Google ha abierto el código fuente del modelo y los pesos en la plataforma Hugging Face, proporcionando documentación detallada y guías para desarrolladores. Desde la publicación del primer modelo Gemma el año pasado, la serie ha superado 160 millones de descargas, demostrando un ecosistema de desarrolladores sólido.

El lanzamiento de Gemma3n marca una nueva etapa en el desarrollo de la inteligencia artificial en el borde, llevando capacidades multimodales de nivel de nube a los dispositivos del usuario, ofreciendo infinitas posibilidades para aplicaciones móviles, hardware inteligente y otros campos.