Hace unos días, un equipo de investigación formado por NVIDIA, la Universidad de Hong Kong y el Instituto Tecnológico de Massachusetts (MIT) presentó una tecnología innovadora llamada Fast-dLLM, destinada a mejorar la eficiencia de razonamiento de los modelos de lenguaje difusos. A diferencia de los modelos autoregresivos tradicionales, los modelos de lenguaje difusos generan texto eliminando gradualmente el ruido del texto, lo que les permite generar varios palabras en una sola iteración, logrando así una mayor eficiencia general. Sin embargo, en aplicaciones prácticas, la velocidad de razonamiento de muchos modelos de lenguaje difusos de código abierto sigue siendo inferior a la de los modelos autoregresivos, principalmente debido a la falta de soporte para caché de claves y valores (KV) y la caída en la calidad de generación al usar decodificación paralela.

La caché de KV es una técnica comúnmente utilizada en los modelos autoregresivos para acelerar el razonamiento, almacenando y reutilizando los estados de atención calculados previamente, reduciendo así las operaciones redundantes y mejorando la velocidad de generación. Sin embargo, debido a que los modelos de lenguaje difusos utilizan mecanismos de atención bidireccional, aplicar directamente la caché de KV no es sencillo. La innovación de la arquitectura Fast-dLLM radica en dividir el proceso de generación de texto en múltiples bloques, cada uno conteniendo un número determinado de tokens. Con este método de generación por bloques, el modelo puede precalcular y almacenar previamente la caché de KV de otros bloques antes de generar un bloque, evitando así cálculos redundantes.

Aunque el mecanismo de caché de KV mejora efectivamente la velocidad de razonamiento, la calidad de generación suele disminuir durante la decodificación paralela. Esto se debe a que los modelos difusos asumen independencia condicional durante la decodificación, sin embargo, existen relaciones complejas entre los tokens. Para resolver este problema, Fast-dLLM propone una estrategia de decodificación paralela basada en la confianza. En cada paso de decodificación, el modelo calcula la confianza de cada token y selecciona aquellos con confianza superior al umbral para decodificar. Esta estrategia asegura que la decodificación paralela sea segura en condiciones de alta confianza, manteniendo así la coherencia y precisión del texto generado.

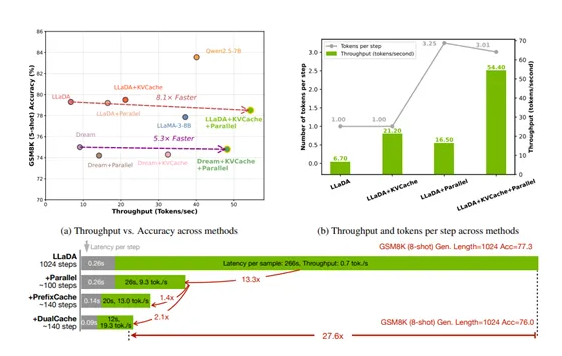

Para verificar el rendimiento de Fast-dLLM, los investigadores realizaron una evaluación exhaustiva de dos modelos de lenguaje difuso, LLaDA y Dream, en una GPU NVIDIA A100 80GB, abarcando tareas como razonamiento matemático y generación de código. En las pruebas del mecanismo de caché de KV, cuando el tamaño del bloque era de 32, el volumen de datos alcanzó 54,4 tokens/s, con una precisión del 78,5%. En las pruebas de decodificación paralela, la estrategia de umbral dinámico superó a la base de número fijo de tokens. En general, el modelo LLaDA logró un aumento de 3,2 veces con el acelerador de caché de KV y 2,5 veces con la decodificación paralela, combinando ambos aumentos de velocidad alcanzó 8,1 veces, y cuando la longitud de generación llegó a 1024 tokens, la aceleración end-to-end fue de 27,6 veces. Todos los resultados de prueba mostraron que Fast-dLLM mantiene la calidad de generación estable mientras acelera el proceso.

Resalta:

🌟 La tecnología Fast-dLLM fue desarrollada en colaboración por NVIDIA y la Universidad de Hong Kong, mejorando la velocidad de razonamiento de los modelos de lenguaje difusos.

⚡ El mecanismo de caché de KV acelera la generación al almacenar y reutilizar los estados de atención, reduciendo así las operaciones redundantes.

📈 La estrategia de decodificación paralela basada en confianza garantiza la coherencia y precisión del texto generado, mejorando el rendimiento general del modelo.