Según informes de medios extranjeros, un nuevo estudio cuestiona las altas puntuaciones matemáticas del modelo Qwen2.5 de Alibaba, señalando que su aparente capacidad de razonamiento matemático podría provenir principalmente de la memoria de los datos de entrenamiento, en lugar de un verdadero razonamiento. Los investigadores descubrieron mediante una serie de pruebas rigurosas que la contaminación de los datos podría ser el factor clave que llevó al buen desempeño de Qwen2.5 en ciertos benchmarks.

La contaminación de los datos sale a la luz: el rendimiento disminuye drásticamente en benchmarks limpios

El hallazgo principal del estudio es que cuando el modelo Qwen2.5 se prueba en "benchmarks limpios", es decir, en conjuntos de datos que no vio durante el entrenamiento, su rendimiento disminuye drásticamente. Esto indica que gran parte del progreso observado en los benchmarks "contaminados" se debe a que el modelo ya había visto esos datos durante el entrenamiento.

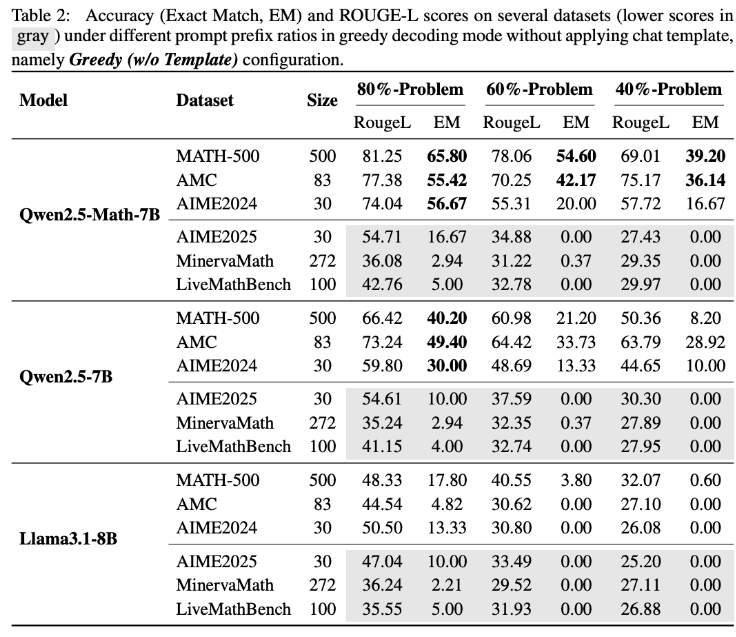

Para verificar esta hipótesis, el equipo de investigación realizó un experimento innovador: solo proporcionaron al modelo Qwen2.5-Math-7B el 60% de los primeros problemas del benchmark MATH500 y le pidieron completar los restantes 40%. El resultado fue sorprendente: Qwen2.5-Math-7B logró reconstruir con éxito la parte faltante con una precisión del 54,6% (un 53,6% de respuestas correctas). En comparación, Llama3.1-8B tuvo una precisión del 3,8% (un 2,4% de respuestas correctas). Esta diferencia significativa sugiere fuertemente que Qwen2.5 ya había "visto" estos problemas durante el entrenamiento.

Prueba LiveMathBench: el índice de finalización de Qwen2.5 cae a cero

Los investigadores luego probaron Qwen2.5 con LiveMathBench (versión 202505). LiveMathBench es un "benchmark limpio" que apareció después del lanzamiento de Qwen2.5, lo que significa que Qwen2.5 no podría haber tenido acceso a sus datos durante el entrenamiento. En este nuevo conjunto de datos, el índice de finalización de Qwen2.5 cayó bruscamente a cero, similar al desempeño de los modelos Llama, y su tasa de precisión en las respuestas también descendió al 2%.

El estudio señala que Qwen2.5 probablemente se haya preentrenado en grandes conjuntos de datos en línea, incluyendo bibliotecas de código en GitHub que contienen preguntas y soluciones de benchmarks. Por lo tanto, incluso si el modelo recibía señales de recompensa aleatorias o incorrectas durante el entrenamiento, podía mejorar su desempeño en MATH-500 debido a haber visto previamente esos datos.

Cambios en los patrones de respuesta y validación con datos sintéticos

Los experimentos adicionales muestran que cuando los patrones de respuesta cambian, el rendimiento de Qwen2.5 en MATH-500 disminuye drásticamente, mientras que Llama-3.1-8B casi no se ve afectado. Esto respalda aún más la dependencia de Qwen2.5 de ciertos patrones de datos específicos.

Para descartar por completo el efecto de la memoria, el equipo de investigación también creó el conjunto de datos RandomCalculation, que contiene problemas aritméticos completamente sintéticos generados después del lanzamiento de Qwen2.5. En estas nuevas preguntas, la precisión de Qwen2.5 disminuyó a medida que aumentaba la complejidad de los problemas. Solo las señales de recompensa correctas podían mejorar el desempeño del modelo, mientras que las señales de recompensa aleatorias causaban inestabilidad en el entrenamiento, y las señales de recompensa inversas incluso reducían sus habilidades matemáticas. Los experimentos controlados de RLVR (aprendizaje por refuerzo con recompensas verificables) también confirmaron estos resultados: solo las recompensas correctas permitieron mejoras estables en el rendimiento, mientras que las recompensas aleatorias o inversas no mejoraron ni redujeron activamente el desempeño.

Implicaciones para la investigación futura en IA

Estos hallazgos plantean serias dudas sobre si las capacidades matemáticas de Qwen2.5 reflejan un razonamiento real, sugiriendo en cambio que el modelo depende en gran medida de los datos memorizados. Alibaba lanzó Qwen2.5 en septiembre de 2024 y posteriormente lanzó la serie Qwen3. Aún no está claro si los hallazgos de este estudio se aplican también a la serie Qwen3.

Los autores del estudio advierten que los benchmarks contaminados pueden llevar a conclusiones engañosas sobre los avances de la inteligencia artificial. Destacan que futuras investigaciones deben basarse en benchmarks limpios y no contaminados, y evaluar múltiples series de modelos para obtener resultados más confiables.