Hace poco, el equipo de inteligencia artificial emergente Thinking Machine lanzó un método revolucionario de entrenamiento: la distilación de estrategia en línea (On-Policy Distillation), que aumenta hasta 50 a 100 veces la eficiencia del entrenamiento de modelos pequeños en tareas específicas. El resultado se anunció inmediatamente y fue reenviado por Mira Murati, ex CTO de OpenAI, lo que generó gran atención en el ámbito académico y empresarial.

Combinar aprendizaje por refuerzo y aprendizaje supervisado para crear un nuevo modelo de "entrenador de IA"

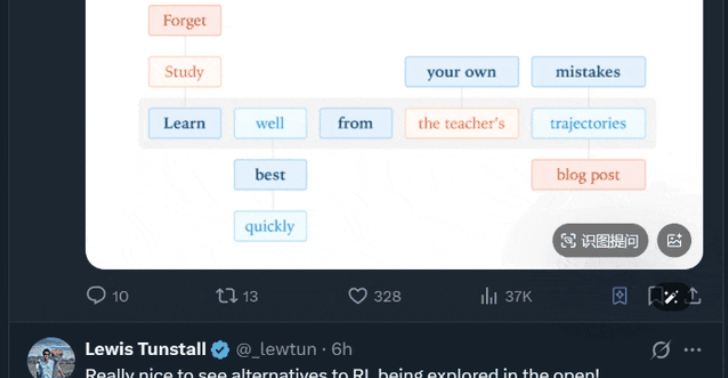

El entrenamiento tradicional de IA enfrenta un dilema constante: el aprendizaje por refuerzo permite que el modelo explore por sí mismo a través de pruebas y errores, siendo flexible pero ineficiente; el ajuste fino supervisado proporciona directamente respuestas estándar, siendo eficiente pero rígido. La distilación de estrategia en línea combina hábilmente ambos enfoques: es como equipar al modelo estudiante con un "entrenador en tiempo real": el estudiante genera contenido por sí mismo, mientras que el modelo maestro fuerte evalúa y guía cada paso de su salida, minimizando la divergencia Kullback-Leibler entre ambos, logrando así una transferencia precisa y estable del conocimiento.

Este mecanismo no solo evita los inconvenientes de la distilación tradicional, que solo enseña resultados sin enseñar procesos, sino que también previene eficazmente que el modelo tome atajos o sobreajuste, mejorando significativamente su capacidad de generalización.

Efectos de prueba sorprendentes: reducción de 7 a 10 veces en pasos, salto de eficiencia de 100 veces

En tareas de razonamiento matemático, el equipo de investigación logró que un modelo pequeño de 8B alcance un nivel de rendimiento cercano a un modelo grande de 32B, usando solo 1/7 a 1/10 de los pasos de entrenamiento de los métodos tradicionales de aprendizaje por refuerzo, reduciendo el costo computacional en dos órdenes de magnitud. Esto significa que empresas pequeñas o equipos de investigación con recursos limitados también pueden entrenar modelos profesionales eficientemente, comparables a los de las grandes empresas.

Más importante aún, este método resolvió con éxito el problema de "olvido catastrófico" en la implementación de IA empresarial. En un experimento con asistentes empresariales, el modelo mantuvo completamente sus capacidades originales de conversación y uso de herramientas mientras aprendía nuevos conocimientos empresariales. Esto ofrece una ruta viable para sistemas de IA industrial que puedan iterar continuamente.

Antecedentes del equipo principal profundos, la tecnología proviene de experiencias prácticas en OpenAI

Este estudio fue liderado por Kevin Lu, quien dirigió varios proyectos clave en OpenAI. Actualmente, como miembro principal de Thinking Machine, trae la experiencia avanzada del entrenamiento de modelos grandes hacia la ecología de modelos pequeños eficientes. Su equipo cree que, en la actualidad, donde la IA se vuelve más vertical y escénica, los modelos "pequeños pero especializados" son el núcleo del despliegue comercial, y la distilación de estrategia en línea es el motor clave para abrir este camino.

A medida que los límites de potencia de cálculo se vuelven más evidentes, la industria está cambiando de la "teoría de modelos grandes" a una nueva forma de "inteligencia eficiente". Esta innovación de Thinking Machine no solo reduce drásticamente la barrera de desarrollo de IA, sino que también anuncia que una era de modelos profesionales de alto valor está acelerando su llegada.

Artículo: https://thinkingmachines.ai/blog/on-policy-distillation/