Récemment, la société MiniMax a annoncé le lancement de son tout nouveau modèle, MiniMax-M1, qui est le premier modèle inférence open source au monde à grande échelle avec une architecture hybride. Ce modèle montre des performances exceptionnelles dans les scénarios complexes liés à la productivité et se distingue comme un excellent modèle open source. MiniMax-M1 dépasse non seulement les modèles propriétaires nationaux, mais se rapproche également du niveau des modèles étrangers les plus avancés, tout en conservant le meilleur rapport qualité-prix du secteur.

Une caractéristique notable de MiniMax-M1 est sa capacité à supporter jusqu'à 1 million d'entrées contextuelles, ce qui est comparable à celui du modèle fermé Google Gemini2.5Pro et huit fois supérieur à celui de DeepSeek R1. Il peut également générer des résultats d'inférence longs de 80 000 Tokens. Cet accomplissement est dû à l'architecture hybride exclusive de MiniMax, principalement basée sur le mécanisme d'attention rapide, qui améliore considérablement l'efficacité lors du traitement d'entrées contextuelles longues et de déductions profondes. Par exemple, lorsqu'il traite 80 000 Tokens pour des déductions profondes, MiniMax-M1 n'a besoin que d'environ 30 % de la puissance de calcul de DeepSeek R1, ce qui lui confère un avantage en termes d'efficacité de calcul pendant l'entraînement et l'inférence.

De plus, MiniMax a proposé un algorithme d'apprentissage par renforcement plus rapide appelé CISPO, qui améliore l'efficacité de l'apprentissage par renforcement en tronquant les poids d'échantillonnage d'importance. Dans les expériences AIME, l'algorithme CISPO a montré une vitesse de convergence deux fois plus rapide que d'autres algorithmes de renforcement, y compris DAPO récemment proposé par ByteDance, et excelle nettement par rapport à l'algorithme GRPO utilisé précédemment par DeepSeek. Ces innovations technologiques rendent le processus d'entraînement renforcé de MiniMax-M1 extrêmement efficace, nécessitant seulement trois semaines avec 512 blocs H800, avec un coût de location largement réduit, diminué d'un ordre de grandeur par rapport aux prévisions initiales.

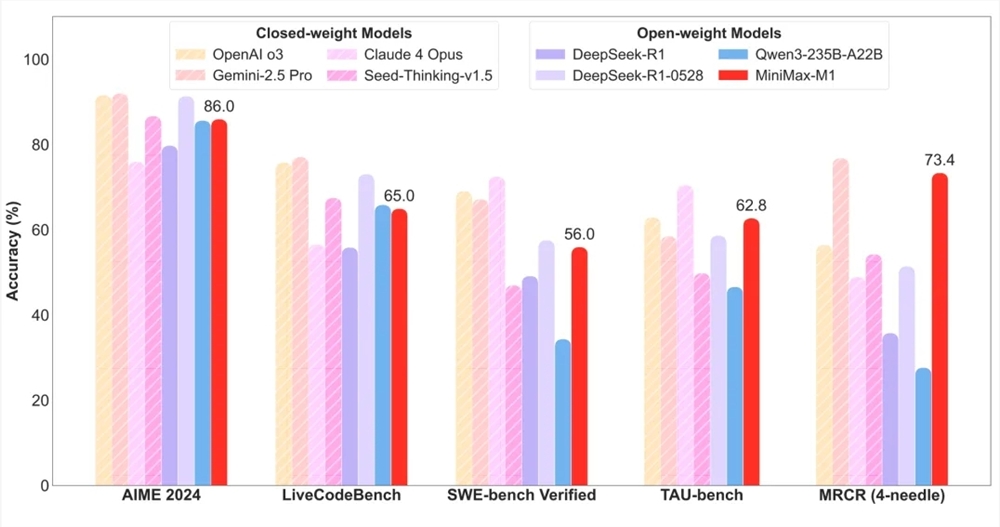

En termes d'évaluation, MiniMax-M1 a obtenu des résultats exceptionnels dans les 17 jeux d'évaluation principaux du secteur. En particulier, dans des scénarios complexes liés à la productivité tels que l'ingénierie logicielle, les contextes longs et l'utilisation d'outils, MiniMax-M1 présente des avantages significatifs. Par exemple, sur le benchmark SWE-bench, MiniMax-M1-40k et MiniMax-M1-80k ont respectivement obtenu des scores de 55,6 % et 56,0 %, ce qui, bien qu'un peu inférieur au score de 57,6 % obtenu par DeepSeek-R1-0528, dépasse nettement d'autres modèles de poids open source. De plus, grâce à sa fenêtre contextuelle à millions de niveaux, MiniMax-M1 excelle dans les tâches de compréhension de contextes longs, surpassant tous les autres modèles de poids open source, et surpassant même certains aspects d'OpenAI o3 et Claude4Opus, se classant deuxième mondial.

Il convient de noter que MiniMax-M1 domine également tous les modèles de poids open source dans les scénarios d'utilisation d'outils (TAU-bench) et a battu Gemini-2.5Pro. De plus, MiniMax-M1-80k est généralement supérieur à MiniMax-M1-40k dans la plupart des benchmarks de test, ce qui valide pleinement l'efficacité des ressources de calcul lors de l'extension des tests.

Enfin, MiniMax-M1 maintient également le prix le plus bas du secteur. Les utilisateurs peuvent utiliser le modèle sans limite via l'application MiniMax ou le site Web, et acheter des services API à un prix très compétitif via le site officiel. Cette mesure favorisera certainement la popularisation et l'adoption du modèle MiniMax-M1 sur le marché.