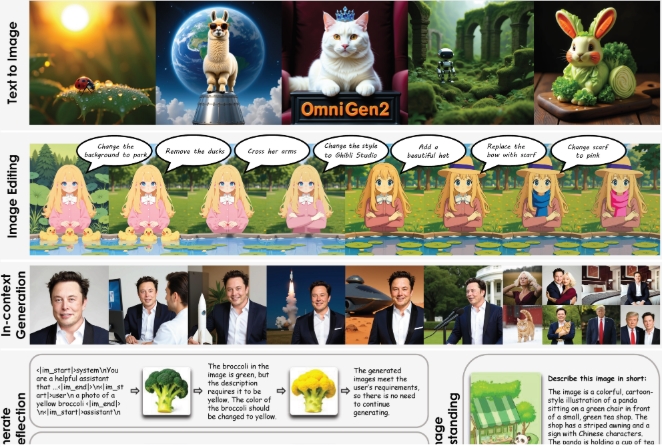

Récemment, l'Institut de l'intelligence artificielle de Pékin a lancé un nouveau système open source - OmniGen2. Ce système se concentre sur la génération d'images à partir de texte, l'édition d'images et la création d'images contextuelles.

Par rapport à la première version OmniGen, lancée en 2024, OmniGen2 utilise deux chemins de décodage indépendants : un pour la génération de texte et un autre pour la génération d'images, chacun possédant ses propres paramètres et un séparateur d'images indépendant. Cette conception permet au modèle de maintenir ses capacités de génération de texte tout en améliorant efficacement les performances des modèles de langage multimodaux.

Le cœur d'OmniGen2 est un grand modèle de langage multimodal (MLLM) basé sur le transformateur Qwen2.5-VL-3B. En ce qui concerne la génération d'images, ce système utilise un transformateur de diffusion personnalisé, avec environ 4 milliards de paramètres. Lorsque le modèle rencontre le marqueur spécial "<|img|>", il passe automatiquement en mode de génération d'images. Il convient de noter qu'OmniGen2 peut traiter diverses instructions et styles artistiques, mais les images générées à haute résolution sont encore insuffisantes en termes de clarté.

Pour former OmniGen2, l'équipe de recherche a utilisé environ 140 millions d'images provenant d'ensembles de données open source et de collections propriétaires. De plus, ils ont développé de nouvelles technologies, extrayant des cadres similaires des vidéos (par exemple, un visage souriant et un visage non souriant), puis utilisant un modèle de langage pour générer des instructions d'édition correspondantes.

Un autre point fort d'OmniGen2 est son mécanisme de réflexion, qui permet au modèle d'évaluer lui-même les images générées et de les améliorer sur plusieurs itérations. Le système peut détecter les défauts dans les images générées et proposer des suggestions spécifiques pour les corriger.

Pour évaluer les performances de ce système, l'équipe de recherche a introduit le benchmark OmniContext, comprenant trois catégories principales : personnages, objets et scènes, chacune comprenant huit sous-tâches et cinq exemples. L'évaluation a été effectuée par GPT-4.1, avec comme critères principaux la précision des instructions et la cohérence du thème. La note totale d'OmniGen2 est de 7,18, surpassant tous les autres modèles open source, tandis que celle de GPT-4o est de 8,8.

Même si OmniGen2 se distingue dans plusieurs benchmarks, il présente encore certaines lacunes : les instructions en anglais donnent de meilleurs résultats qu'en chinois, les variations de forme corporelle sont complexes, et la qualité de sortie dépend de l'image d'entrée. Pour les instructions multi-images floues, le système nécessite des indications précises sur l'emplacement des objets.

L'équipe de recherche prévoit de publier le modèle, les données d'entraînement et le pipeline de construction sur la plateforme Hugging Face.

Points clés :

🌟 OmniGen2 est un système de génération d'images et de texte open source, utilisant des chemins de décodage indépendants pour le texte et les images.

🎨 Il peut gérer la génération d'images dans divers styles artistiques et dispose d'une fonctionnalité d'autoréflexion et d'amélioration.

📈 OmniGen2 s'est distingué dans plusieurs benchmarks, notamment en créant un nouveau record pour les modèles open source en matière d'édition d'images.