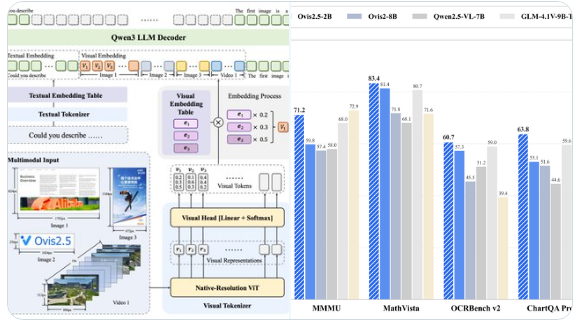

L'équipe d'IA du groupe Alibaba International Digital Trade (AIDC) (AIDC-AI) a récemment lancé un nouveau modèle de langage à grande échelle multimodal, Ovis2.5, disponible en deux versions avec 9 milliards et 2 milliards de paramètres. Ce modèle est positionné comme une solution économique pour le raisonnement visuel, offrant des performances exceptionnelles dans sa taille, et établit un nouveau standard pour les applications d'IA multimodales.

Les caractéristiques principales d'Ovis2.5

1. **Perception native de la résolution** : Ovis2.5 utilise un encodeur visuel NaViT, qui préserve les détails fins et la structure globale de l'image sans perte de qualité, garantissant ainsi une capacité de traitement visuel de haute qualité.

2. **Capacité de raisonnement approfondi** : Le modèle propose un mode "réflexion" optionnel, qui peut reprendre certaines caractéristiques techniques du Qwen3 d'Alibaba. Outre le raisonnement par chaîne de pensée linéaire (CoT), Ovis2.5 est capable de s'auto-vérifier et de se corriger, et prend en charge un budget de réflexion configurable, améliorant ainsi la précision de la résolution des problèmes.

3. **Avantages en matière de reconnaissance optique de caractères (OCR) et d'analyse de graphiques** : Sur les versions de 9 milliards et 2 milliards de paramètres, Ovis2.5 atteint un niveau avancé dans l'analyse de graphiques complexes, la compréhension de documents (y compris les tableaux et formulaires) et la reconnaissance optique de caractères (OCR), offrant un soutien puissant pour les scénarios d'application réels.

4. **Couverture large des tâches** : Ce modèle se distingue dans le raisonnement image, la compréhension vidéo et les tests de base de localisation visuelle, démontrant ainsi une forte capacité multimodale générale.

Le lancement d'Ovis2.5 reflète l'innovation continue d'AIDC-AI dans le domaine de la technologie IA multimodale. En réalisant des performances élevées dans une taille de modèle compacte, Ovis2.5 offre aux développeurs et entreprises une solution efficace et facile à déployer, particulièrement adaptée aux scénarios nécessitant une combinaison de raisonnement visuel et textuel. Le modèle est désormais open source sur les plateformes GitHub et Hugging Face, favorisant davantage la collaboration et l'innovation au sein de la communauté mondiale de l'IA.

Ce lancement marque un autre progrès important réalisé par AIDC-AI sur la base du modèle Ovis, apportant une nouvelle vitalité au développement des modèles de langage à grande échelle multimodaux.