Dans le domaine de l'édition et de la génération d'images par l'intelligence artificielle, une nouvelle technologie révolutionnaire a attiré l'attention. Le système DreamOmni2, développé en collaboration par ByteDance, l'Université chinoise de Hong Kong, l'Université de technologie de Hong Kong et l'Université de Hong Kong, a été officiellement rendu open source, marquant ainsi une nouvelle avancée dans les technologies d'édition et de génération d'images.

La mise sur le marché de DreamOmni2 vise à améliorer la capacité des intelligences artificielles à suivre les instructions lors du traitement des images, permettant ainsi une compréhension véritablement multimodale des instructions. Ce système est capable de comprendre à la fois les instructions textuelles et les images de référence, ce qui améliore significativement les limites des modèles précédents lorsqu'ils traitent des concepts abstraits (comme le style, le matériau ou l'éclairage). L'interaction entre l'utilisateur et l'IA devient plus naturelle, comme si l'on parlait avec un partenaire qui comprend réellement vos intentions.

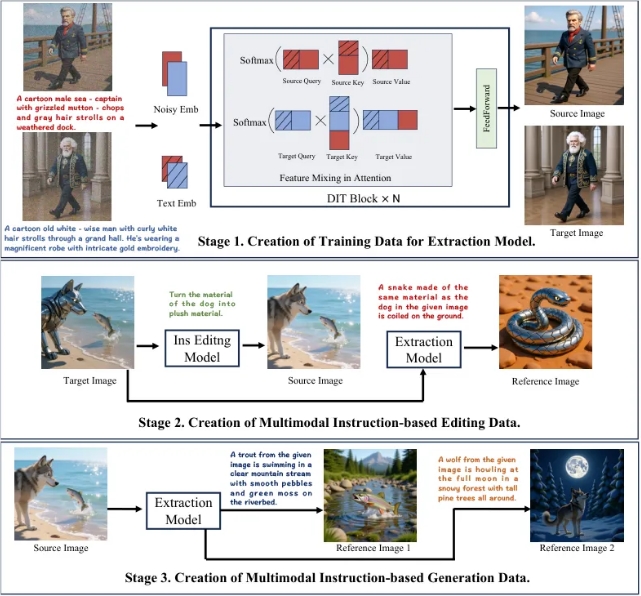

Pour entraîner l'IA à comprendre les instructions complexes en texte et en image, l'équipe de développement de DreamOmni2 a mis au point un processus innovant en trois étapes. Tout d'abord, grâce à un modèle d'extraction, l'IA peut extraire précisément des éléments spécifiques ou des propriétés abstraites d'une image. Ensuite, le modèle d'extraction génère des données d'édition multimodales, formant ainsi des échantillons d'entraînement comprenant une image source, une instruction, une image de référence et une image cible. Enfin, en extrayant et combinant davantage d'images de référence, un ensemble de données multimodal pour la génération d'instructions est construit. Ces étapes successives ont posé une solide base pour l'entraînement de haute qualité du système.

Dans le domaine de l'architecture du modèle, DreamOmni2 a introduit une méthode d'encodage d'index et un décalage d'encodage de position, assurant ainsi que le modèle puisse identifier correctement plusieurs images en entrée. En outre, l'introduction d'un modèle de langage visuel (VLM) a efficacement comblé le fossé entre les instructions des utilisateurs et la compréhension du modèle. Cette conception innovante a amélioré la précision du système lors du traitement des instructions, lui permettant de mieux comprendre les véritables intentions des utilisateurs.

En testant, DreamOmni2 a montré des performances supérieures à tous les modèles open source comparés, se rapprochant des modèles commerciaux de premier plan. Comparé aux modèles commerciaux traditionnels, DreamOmni2 offre une plus grande précision et cohérence lors du traitement des instructions complexes, évitant ainsi des modifications inutiles et des défauts dans les images.