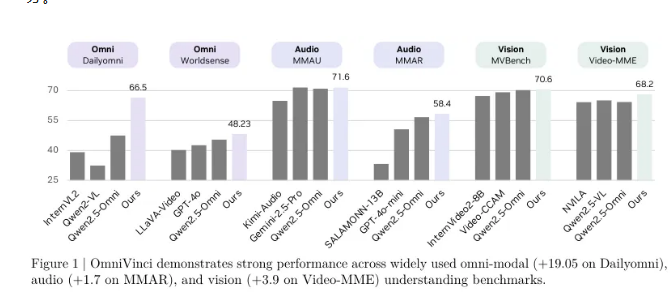

L'équipe de recherche NVIDIA a publié aujourd'hui un modèle de compréhension multimodale nommé OmniVinci, qui a obtenu des résultats remarquables sur les benchmarks clés de la compréhension multimodale, dépassant les modèles les plus avancés de 19,05 points. Ce qui est encore plus impressionnant, c'est que OmniVinci n'a utilisé qu'un sixième des données d'entraînement, démontrant une excellente efficacité des données et une performance élevée.

Le but d'OmniVinci est de créer un système d'IA universel capable de comprendre à la fois l'image, le son et le texte, permettant aux machines de percevoir et de comprendre le monde complexe comme l'humain à travers plusieurs sens. Pour atteindre cet objectif, l'équipe NVIDIA a adopté une conception architecturale innovante et des stratégies de gestion des données, en fusionnant les informations provenant de différents sens dans un espace latent multimodal unique, réalisant ainsi une compréhension et une inférence transmodales.

Dans le benchmark Dailyomni, la performance d'OmniVinci dépasse Qwen2.5-Omni, avec un avantage de 1,7 point dans le test MMAR de compréhension audio, et de 3,9 point dans le test Video-MME de compréhension visuelle. Le nombre de tokens utilisés pour l'entraînement n'est que de 0,2 trillion, contre 1,2 trillion pour Qwen2.5-Omni, ce qui montre que l'efficacité d'entraînement d'OmniVinci est six fois supérieure.

L'innovation principale de ce modèle réside dans le mécanisme d'alignement multimodal, comprenant trois technologies : le module OmniAlignNet, le regroupement d'encodage temporel (TEG) et l'encodage temporel contraint rotatif (CRTE). OmniAlignNet utilise la complémentarité entre les signaux visuels et auditifs pour renforcer leur apprentissage et leur alignement. TEG, quant à lui, encode efficacement les relations temporelles en regroupant les informations visuelles et auditives selon le temps. CRTE résout davantage le problème d'alignement temporel, garantissant que le modèle puisse comprendre les informations temporelles absolues des événements.

L'équipe de recherche a adopté une méthode d'entraînement en deux étapes, commençant par un entraînement spécifique au mode, puis par un entraînement conjoint multimodal, afin d'améliorer progressivement la capacité du modèle à comprendre les données multimodales. En matière d'apprentissage multimodal implicite, les chercheurs ont amélioré davantage la capacité du modèle à comprendre conjointement le son et l'image grâce à des jeux de données existants de questions-réponses vidéo.

L'arrivée d'OmniVinci marque un important progrès pour NVIDIA dans le domaine de l'IA multimodale. Il devrait favoriser le développement des technologies de l'IA dans diverses applications et aider à l'apparition de systèmes et de services plus intelligents. La publication open source de ce modèle offrira également de nouvelles opportunités aux chercheurs et développeurs du monde entier, poussant davantage l'exploration et l'innovation de l'IA dans les applications pratiques.