कृत्रिम बुद्धिमत्ता के तेजी से विकास के पीछे, एक गंभीर समस्या सामने आ रही है - डेटा प्राप्त करने की कठिनाई लगातार बढ़ती जा रही है। MIT जैसे संस्थानों के नवीनतम शोध में पाया गया है कि जो वेब डेटा पहले आसानी से प्राप्त किया जा सकता था, वह अब अधिक से अधिक कठिनाई से उपलब्ध हो रहा है, जो AI के प्रशिक्षण और अनुसंधान के लिए एक बड़ी चुनौती बन रहा है।

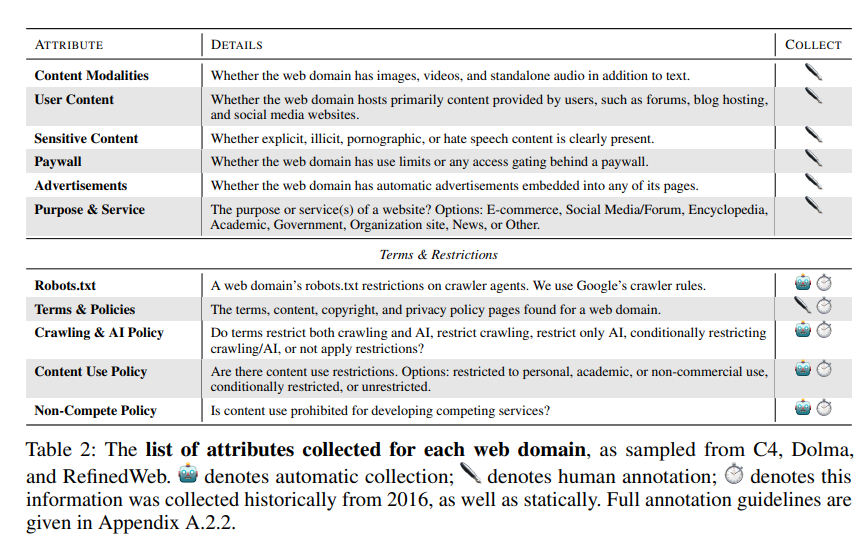

शोधकर्ताओं ने पाया कि कई ओपन-सोर्स डेटा सेट जैसे C4, RefineWeb, Dolma आदि, जिनकी वेबसाइटों को स्क्रैप किया गया है, वे तेजी से अपनी अनुमति नीतियों को कड़ा कर रहे हैं। यह न केवल व्यावसायिक AI मॉडल के प्रशिक्षण को प्रभावित करता है, बल्कि शैक्षणिक और गैर-लाभकारी संगठनों के अनुसंधान में भी बाधा डालता है।

यह शोध MIT मीडिया लैब, वेल्सले कॉलेज, AI स्टार्टअप Raive आदि संस्थानों के चार टीम प्रमुखों द्वारा संयुक्त रूप से किया गया है। उन्होंने指出 किया कि डेटा की सीमाएं बढ़ती जा रही हैं, और अनुमति की असममिति और असंगति की समस्या दिन-ब-दिन बढ़ रही है।

शोध टीम ने अपने शोध विधियों के रूप में रोबोट्स बहिष्करण प्रोटोकॉल (Robots Exclusion Protocol, REP) और वेबसाइट की सेवा शर्तों (Terms of Service, ToS) का उपयोग किया। उन्होंने पाया कि यहां तक कि OpenAI जैसी बड़ी AI कंपनियों के वेब क्रॉलर भी अधिक से अधिक कड़ी सीमाओं का सामना कर रहे हैं।

SARIMA मॉडल के माध्यम से भविष्यवाणी की गई है कि चाहे robots.txt के माध्यम से हो या ToS के माध्यम से, वेबसाइटों पर डेटा की सीमाएं बढ़ती रहेंगी। यह दर्शाता है कि खुले नेटवर्क डेटा की प्राप्ति और भी कठिन होती जाएगी।

शोध ने यह भी पाया कि इंटरनेट पर स्क्रैप किए गए डेटा और AI मॉडल के प्रशिक्षण के उद्देश्यों में असंगति है, जो मॉडल संरेखण, डेटा संग्रह प्रथाओं और कॉपीराइट पर प्रभाव डाल सकती है।

शोध टीम ने वेबसाइट मालिकों की इच्छाओं को दर्शाने के लिए अधिक लचीले प्रोटोकॉल की आवश्यकता की अपील की, जिससे अनुमति प्राप्त और निषिद्ध उपयोग मामलों को अलग किया जा सके और सेवा शर्तों के साथ समन्वयित किया जा सके। साथ ही, वे चाहते हैं कि AI डेवलपर्स खुले नेटवर्क पर डेटा का उपयोग करके प्रशिक्षण कर सकें, और भविष्य के कानून इस दिशा में समर्थन करें।

पत्र का पता: https://www.dataprovenance.org/Consent_in_Crisis.pdf