グーグルは今週金曜日に、新しくてエッジ側のマルチモーダル大規模モデルであるGemma3nを正式にリリースし、オープンソース化しました。この画期的な製品により、スマートフォン、タブレット、ノートPCなどのエッジ端末で、これまでクラウドでのみ体験できた強力なマルチモーダル機能が可能になりました。

コア特徴:小サイズで大容量

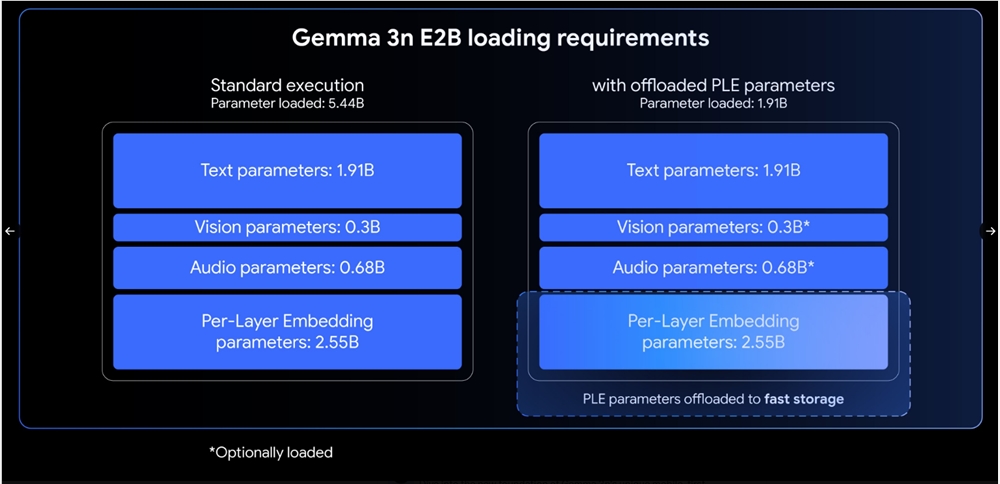

Gemma3nはE2BとE4Bの2つのバージョンを提供しています。それぞれの初期パラメータ数は5Bと8Bですが、アーキテクチャの革新により、メモリ使用量は従来の2Bと4Bモデルに相当します。それぞれ2GBと3GBのメモリで動作可能です。このモデルは画像、音声、動画、テキストのマルチモーダル入力処理をネイティブにサポートしており、140言語のテキストと35言語のマルチモーダル理解をサポートしています。

注目すべきは、E4BバージョンがLMArena評価で1300点を超えたことで、100億パラメータ未満のモデルとしては初めてこの基準に達したことです。多言語、数学、コード作成、推論能力において大幅な向上を実現しています。

技術革新:4つの画期的アーキテクチャ

MatFormerアーキテクチャ: Gemma3nは新しいマトリョーシカ・トランスフォーマー構造を採用しています。ロシアのオモチャのように、一つのモデルにさまざまなサイズを含んでいます。E4Bモデルをトレーニングする際には同時にE2Bサブモデルも最適化されるため、開発者にとって柔軟な性能選択肢を提供します。Mix-n-Match技術により、ユーザーはE2BとE4Bの間でカスタムサイズのモデルを作成できます。

各層埋め込み(PLE)技術: このイノベーションにより、大部分のパラメータをCPU上で読み込んで計算することが可能になります。必要なのは、アクセラレータメモリに格納されるコアトランスフォーマー重みのみです。これによりメモリ効率が大幅に向上しますが、モデル品質には影響を与えません。

KVキャッシュ共有: 長いコンテンツ処理に最適化されており、キーと値のキャッシュ共有技術により、プレフィルの性能がGemma34Bよりも2倍向上します。長文シーケンス処理における最初のトークン生成時間が顕著に短縮されます。

先進的なエンコーダー: 音声面では汎用音声モデル(USM)に基づくエンコーダーを採用しており、自動音声認識や音声翻訳機能をサポートしています。最大30秒の音声セグメントを処理可能です。視覚面ではMobileNet-V5-300Mエンコーダーを搭載しており、さまざまな入力解像度に対応しています。Google Pixelでは秒速60フレームの処理速度を達成できます。

実用機能と応用場面

Gemma3nは音声翻訳において優れた性能を発揮しており、特に英語とスペイン語、フランス語、イタリア語、ポルトガル語の間の変換が特筆に値します。視覚エンコーダーのMobileNet-V5は、先進的な蒸留技術により、ベースラインモデルに対して13倍の高速化を実現し、パラメータ数は46%減少し、メモリ使用量は4倍削減されながらもより高い正確性を維持しています。

オープンソースエコシステムと将来展望

グーグルはHugging Faceプラットフォームでモデルと重みをオープンソース化しており、詳細なドキュメンテーションと開発ガイドを提供しています。昨年最初のGemmaモデルがリリースされてから、シリーズ全体のダウンロード数は1億6,000万回を超え、強力な開発者エコシステムを示しています。

Gemma3nのリリースは、エッジ側AIが新たな段階に入ったことを示しており、クラウドレベルのマルチモーダル機能をユーザーのデバイスに下ろすことで、モバイルアプリケーション、スマートハードウェアなど多くの分野に無限の可能性をもたらします。