Na era em que a tecnologia de inteligência artificial está se desenvolvendo rapidamente, o grupo de processamento de linguagem natural do Instituto de Tecnologia de Computação da Academia Chinesa de Ciências lançou um modelo de grande dimensão multimodal de texto, imagem e áudio chamado Stream-Omni. O destaque principal deste modelo é a capacidade de suportar simultaneamente várias formas de interação, oferecendo aos usuários uma experiência mais flexível e rica.

Suporte abrangente à interação multimodal

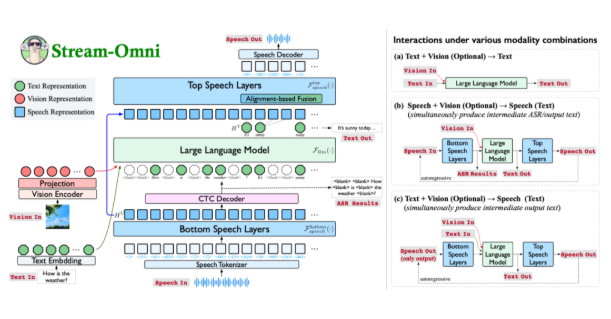

O Stream-Omni é um modelo de grande dimensão multimodal baseado na arquitetura GPT-4o, demonstrando habilidades notáveis nas três modalidades de texto, visão e áudio. Por meio de serviços de voz online, os usuários não apenas podem interagir por voz, mas também podem obter resultados intermediários de transcrição de texto durante o processo, tornando a experiência de interação mais natural, como se estivessem "assistindo e ouvindo ao mesmo tempo".

Forma inovadora de alinhamento multimodal

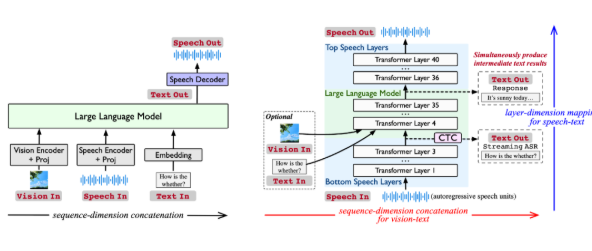

Os modelos atuais de grande dimensão multimodal geralmente combinam as representações de diferentes modalidades e as introduzem no modelo de linguagem grande para gerar respostas. No entanto, esse método depende de grandes quantidades de dados e carece de flexibilidade. O Stream-Omni modela as relações entre as modalidades de forma mais direcionada, reduzindo a dependência de grandes conjuntos de dados trimodais. Ele enfatiza a consistência semântica entre voz e texto e faz com que as informações visuais complementem semanticamente o texto, alcançando um alinhamento multimodal mais eficiente.

Funcionalidades poderosas de interação por voz

A forma única de modelagem de voz do Stream-Omni permite que ele, durante a interação por voz, forneça resultados intermediários de transcrição de texto, como o GPT-4o. Essa design oferece aos usuários uma experiência mais completa de interação multimodal, especialmente em cenários que exigem conversão em tempo real de voz para texto, aumentando significativamente a eficiência e a conveniência.

Interação flexível com quaisquer combinações de modalidades

O design do Stream-Omni permite a combinação flexível de codificadores visuais, camadas de voz e modelos de linguagem grande, apoiando a interação com várias combinações de modalidades. Essa flexibilidade permite que os usuários escolham livremente os métodos de entrada em diferentes cenários, obtendo respostas consistentes seja por texto, voz ou imagem.

Em diversos experimentos, a capacidade de compreensão visual do Stream-Omni é comparável a modelos de grande dimensão visuais de tamanho similar, enquanto sua capacidade de interação por voz é significativamente superior às tecnologias existentes. Esse mecanismo de mapeamento de voz-texto baseado em dimensões hierárquicas garante um alinhamento semântico preciso entre voz e texto, tornando as respostas de diferentes modalidades mais consistentes.

O Stream-Omni não só oferece novas ideias para a interação multimodal, mas também impulsiona a integração profunda das tecnologias de texto, visão e áudio com suas características flexíveis e eficientes. Embora ainda haja espaço para melhoria em aspectos como apresentação humanizada e diversidade de tons de voz, ele certamente estabelece uma base sólida para a interação inteligente multimodal do futuro.

Link do artigo: https://arxiv.org/abs/2506.13642

Código de código aberto: https://github.com/ictnlp/Stream-Omni

Baixar modelo: https://huggingface.co/ICTNLP/stream-omni-8b