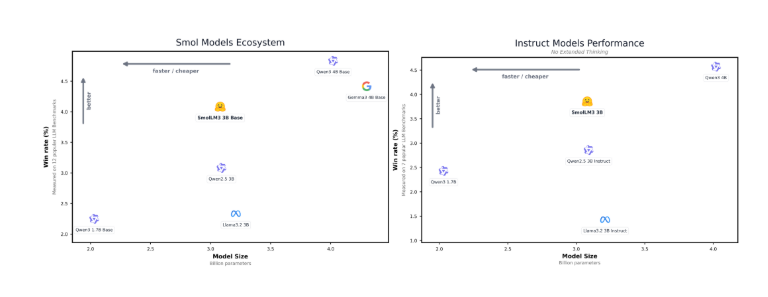

近日,全球知名的大模型开放平台 Hugging Face 正式发布了其最新开源模型 ——SmolLM3。这款模型拥有30亿参数,尽管参数量相对较小,但其性能显著超过了同类的开源模型,如 Llama-3.2-3B 和 Qwen2.5-3B。

SmolLM3不仅支持128k 的上下文窗口,还能够流畅处理英语、法语、西班牙语、德语等多种语言的文本,标志着在小参数模型领域的又一重要进展。

多种推理模式,灵活应对需求

SmolLM3具备深度思考和非思考两种推理模式,用户可以根据实际需要灵活切换。这一创新设计让模型在处理复杂问题时,能够更好地发挥其推理能力,尤其是在需要深入分析的场景下。

开源架构,助力研究与优化

值得注意的是,Hugging Face 对 SmolLM3的架构细节、数据混合方法以及模型训练流程均进行了公开。这一开放策略将极大地促进开发者们对该模型的研究与优化,推动开源 AI 模型的进一步发展。

模型架构与训练配置

SmolLM3采用了先进的 transformer 解码器架构,借鉴了 SmolLM2的设计,同时对 Llama 进行了关键性改进,以提升效率和长上下文的表现。具体而言,模型使用了分组查询注意力机制和文档内掩码技术,以确保长上下文训练的有效性。

在训练配置方面,SmolLM3的参数量为3.08B,使用了36层的深度结构,优化器为 AdamW,经过24天的分布式训练,最终形成了强大的模型。

三阶段混合训练,提升能力

该模型的训练过程分为三个阶段,利用多种类型的数据进行混合训练。在第一阶段,模型通过网络、数学和代码数据的综合训练建立通用能力;第二阶段则引入更高质量的数学与代码数据;最后,在第三阶段中,模型进一步增强了对数学与代码数据的采样,提升了其推理和指令遵循能力。

随着 SmolLM3的发布,Hugging Face 再一次巩固了其在 AI 领域的领先地位。此模型不仅具备强大的推理能力,还以其高效的性能为开发者提供了丰富的应用前景。未来,随着更多的开源研究与社区合作,SmolLM3有望在各类应用场景中发挥更大的作用。

基础模型:https://huggingface.co/HuggingFaceTB/SmolLM3-3B-Base

推理和指导模型:https://huggingface.co/HuggingFaceTB/SmolLM3-3B