Liquid AI 宣布正式开源其下一代 Liquid Foundation Models(LFM2),这一突破性举措在人工智能领域掀起热议。作为专为边缘设备优化的高效混合模型,LFM2在速度、能效和性能上树立了新的行业标准。AIbase 整理了近期网络信息,深入剖析 LFM2的技术亮点及其对 AI 生态的深远影响。

LFM2:重新定义边缘AI的性能边界

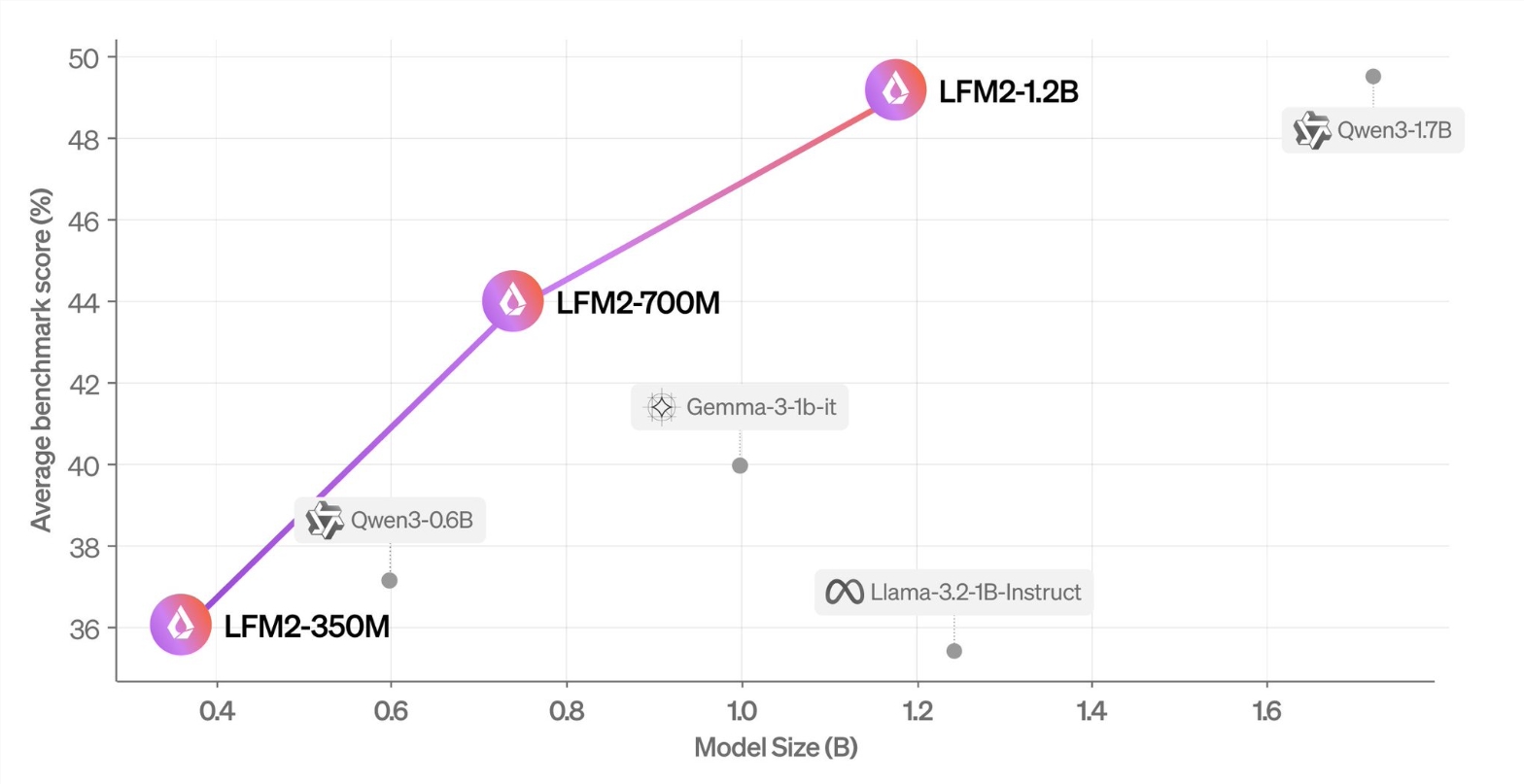

LFM2系列包括350M、700M 和1.2B 三个参数规模的模型,专为智能手机、笔记本电脑、汽车及嵌入式系统等边缘设备设计。与传统基于 Transformer 的模型不同,LFM2采用了创新的结构化自适应算子架构。这种架构显著提升了训练效率和推理速度,尤其在长上下文和资源受限场景下表现出色。据报道,LFM2的推理速度比 Qwen3快2倍,训练速度较 Liquid AI 之前的模型提升3倍,展现了其在边缘计算领域的巨大潜力。

此外,LFM2在指令跟随和函数调用等关键任务上表现优异,平均性能超越同等规模的模型,使其成为本地化和边缘 AI 应用的理想选择。这种高效性不仅降低了部署成本,还为隐私敏感场景提供了更安全的数据处理方案。

开源战略:推动全球AI创新

通过开源 LFM2,Liquid AI 将模型权重完全公开,开发者可通过 Hugging Face 下载并在 Liquid Playground 进行测试。这一举措不仅体现了 Liquid AI 对技术透明化的承诺,也为全球开发者提供了探索新型 AI 架构的机会。LFM2的开源标志着美国企业在高效小型语言模型领域首次公开超越中国领先的开源模型,如阿里巴巴和字节跳动开发的模型,展现了其在全球 AI 竞赛中的技术自信。

值得一提的是,Liquid AI 计划将 LFM2集成到其边缘 AI 平台及即将推出的 iOS 原生应用中,进一步扩展其在消费级市场的应用场景。这一战略布局表明,Liquid AI 不仅关注技术创新,还致力于通过开源和生态建设推动 AI 的普及化。

技术亮点:高效、隐私、长上下文

LFM2的核心优势在于其独特的技术设计。模型支持32K 上下文长度、bfloat16精度和65K 词汇表,采用 ChatML 风格优化交互体验。这些特性使其在处理复杂任务时兼顾高效与精准。此外,LFM2的低延迟和高能效设计使其特别适合资源受限的边缘设备,为隐私敏感的本地化 AI 应用提供了可靠支持。

与此同时,LFM2的开源为开发者提供了深入研究新型 AI 架构的机会。相比传统的 Transformer 模型,LFM2的混合架构在性能和效率之间取得了巧妙平衡,预示着边缘 AI 技术的新方向。

行业影响:边缘AI的未来风向标

LFM2的发布不仅是 Liquid AI 的技术里程碑,也为边缘 AI 领域树立了新标杆。在全球 AI 竞争日益激烈的背景下,LFM2的高效性和开源策略为中小型企业和独立开发者提供了低成本、高性能的 AI 解决方案。同时,其对隐私和本地化计算的重视顺应了数据主权和隐私保护的全球趋势。

AIbase 认为,LFM2的开源不仅推动了技术民主化,还可能激发更多创新应用,从智能家居到自动驾驶,再到医疗设备,LFM2的潜力正在被逐步挖掘。未来,随着更多开发者参与到 LFM2的生态建设中,边缘 AI 的发展将迎来新的加速期。

huggingface:https://huggingface.co/collections/LiquidAI/lfm2-686d721927015b2ad73eaa38