Com o desenvolvimento da inteligência artificial, as aplicações dos modelos de linguagem grande (LLM) estão se tornando cada vez mais amplas. No entanto, os métodos de inferência atuais ainda apresentam muitas limitações. O método tradicional de geração autoregressiva precisa gerar tokens um a um, o que é menos eficiente e não pode aproveitar plenamente a capacidade de computação paralela dos hardwares modernos. Para resolver esse problema, uma equipe de pesquisa da Universidade Carnegie Mellon (CMU) e da NVIDIA lançou um novo modelo de geração chamado Multiverse, com o objetivo de realizar uma geração nativamente paralela, mudando fundamentalmente nossa compreensão sobre a inferência de LLMs.

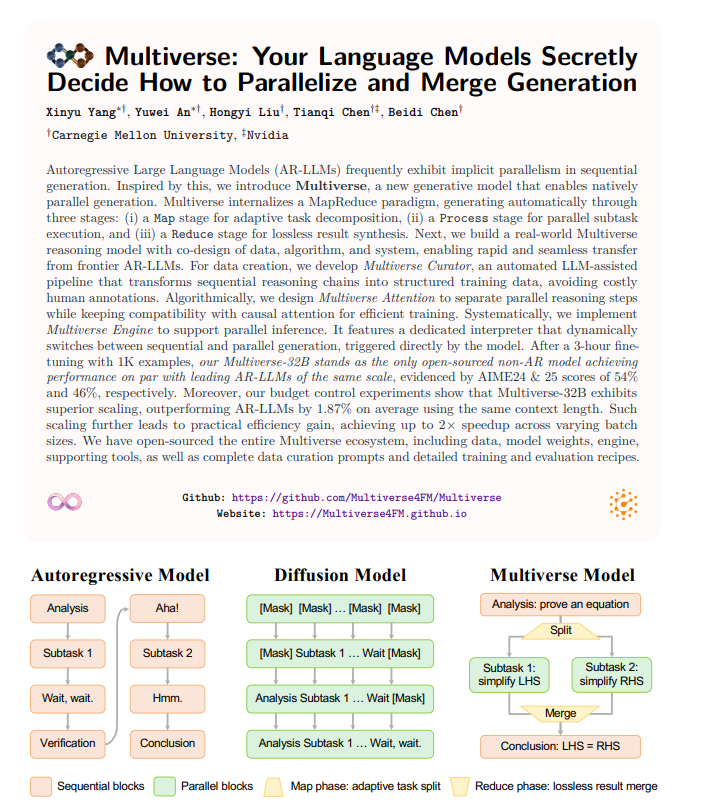

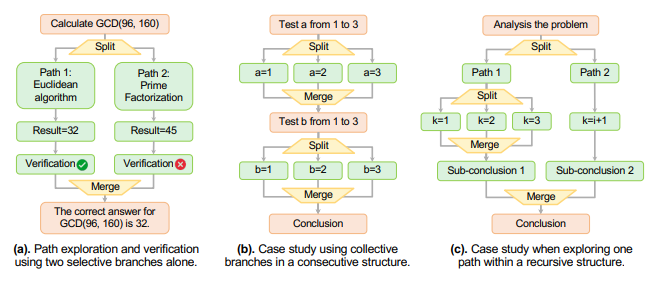

O Multiverse não se limita a acelerar a velocidade de geração; ele repensa a arquitetura do modelo. Os pesquisadores descobriram que os principais modelos de linguagem grandes atuais implicam uma certa paralelização durante o processo de geração. Com essa descoberta, o quadro Multiverse adota uma estrutura semelhante ao MapReduce, dividindo o processo de geração em três estágios: decomposição adaptativa das tarefas, execução paralela das sub-tarefas e combinação sem perdas dos resultados. Esse design pode aproveitar plenamente o potencial dos recursos computacionais, permitindo processos de inferência mais eficientes.

Os dados experimentais mostram que o modelo Multiverse-32B apresenta um desempenho cerca de 2% superior ao dos modelos autoregressivos sob a mesma extensão de contexto. Isso indica que o Multiverse não apenas melhora significativamente a velocidade, mas também se destaca em termos de escalabilidade, conseguindo até duas vezes mais velocidade em diferentes tamanhos de lote. Para que esses resultados possam ser mais amplamente aplicados, a equipe de pesquisa também disponibilizou o ecossistema completo do Multiverse, incluindo dados, pesos do modelo e detalhes do treinamento, facilitando que outros pesquisadores explorem ainda mais.

No uso prático, o Multiverse pode ajustar-se de forma flexível às necessidades de geração e alternar dinamicamente entre sequencial e paralelo por meio de uma tag de controle dedicada, garantindo a coerência e a lógica do conteúdo gerado. O lançamento dessa tecnologia certamente injeta nova energia no campo do processamento de linguagem natural, e esperamos ver seu desempenho em aplicações reais.