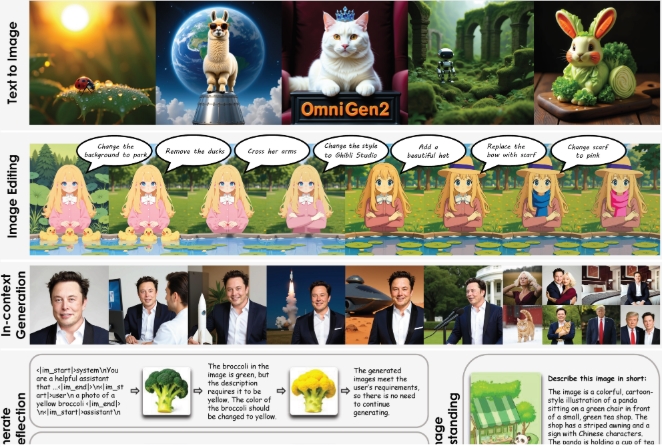

Recentemente, o Instituto de Inteligência Artificial de Pequim lançou um novo sistema de código aberto - OmniGen2. Este sistema se concentra na geração de imagens a partir de texto, edição de imagens e criação de imagens no contexto.

Em comparação com a primeira versão OmniGen lançada em 2024, o OmniGen2 adota duas rotas de decodificação independentes: uma para a geração de texto e outra para a geração de imagem, cada uma com seus próprios parâmetros e um codificador de imagem desacoplado. Essa design permite que o modelo mantenha sua capacidade de geração de texto enquanto efetivamente melhora o desempenho dos modelos de linguagem multimodal.

O núcleo do OmniGen2 é um grande modelo de linguagem multimodal (MLLM) baseado no transformador Qwen2.5-VL-3B. Na geração de imagens, o sistema utiliza um transformador de difusão personalizado com cerca de 4 bilhões de parâmetros. Quando o modelo encontra o marcador especial "<|img|>", ele automaticamente muda para o modo de geração de imagem. Destaca-se que o OmniGen2 é capaz de lidar com diversos tipos de dicas e estilos artísticos, mas as imagens fotográficas geradas ainda têm que melhorar em clareza.

Para treinar o OmniGen2, a equipe de pesquisa utilizou aproximadamente 140 milhões de imagens provenientes de conjuntos de dados de código aberto e coleções proprietárias. Além disso, eles desenvolveram novas tecnologias para extrair quadros semelhantes de vídeos (por exemplo, rostos sorrindo e não sorrindo), e utilizar o modelo de linguagem para gerar instruções de edição correspondentes.

Outro destaque do OmniGen2 é seu mecanismo de reflexão, que permite ao modelo avaliar por si só as imagens geradas e melhorá-las em vários ciclos. O sistema pode identificar defeitos nas imagens geradas e propor sugestões específicas de correção.

Para avaliar o desempenho do sistema, a equipe de pesquisa introduziu o benchmark OmniContext, incluindo três categorias: personagens, objetos e cenários, cada uma com oito sub-tarefas e 50 exemplos. A avaliação foi realizada pelo GPT-4.1, com os critérios principais sendo a precisão das dicas e a consistência do tema. A pontuação total do OmniGen2 foi de 7,18, superando todos os outros modelos de código aberto, enquanto a pontuação do GPT-4o foi de 8,8.

Ainda que o OmniGen2 tenha demonstrado excelentes resultados em vários benchmarks, ainda existem algumas limitações: os efeitos das dicas em inglês são melhores que as em chinês, as mudanças na forma corporal são bastante complexas e a qualidade da saída também depende da imagem de entrada. Para dicas de múltiplas imagens ambíguas, o sistema precisa de indicações claras sobre a colocação dos objetos.

A equipe de pesquisa planeja publicar o modelo, os dados de treinamento e o pipeline de construção na plataforma Hugging Face.

Destaque principal:

🌟 O OmniGen2 é um sistema de geração de texto e imagem de código aberto, que utiliza caminhos de decodificação separados para texto e imagem.

🎨 Ele é capaz de lidar com a geração de imagens em vários estilos artísticos e possui funções de reflexão e melhoria autônoma.

📈 O OmniGen2 demonstrou excelente desempenho em vários benchmarks, especialmente estabelecendo novas marcas em modelos de código aberto na edição de imagens.