Kürzlich hat das Seed-Team von ByteDance gemeinsam mit der University of Hongkong und der Fudan University eine innovative Methode zur Verstärkungslerntraining – POLARIS – eingeführt. Diese Methode verbessert durch sorgfältig gestaltete Scaling RL-Strategien die mathematische Schlussfolgerungsfähigkeit kleiner Modelle auf ein Niveau, das mit großen Modellen konkurrieren kann, und bietet einen neuen Weg für die Optimierung kleiner Modelle im Bereich Künstliche Intelligenz.

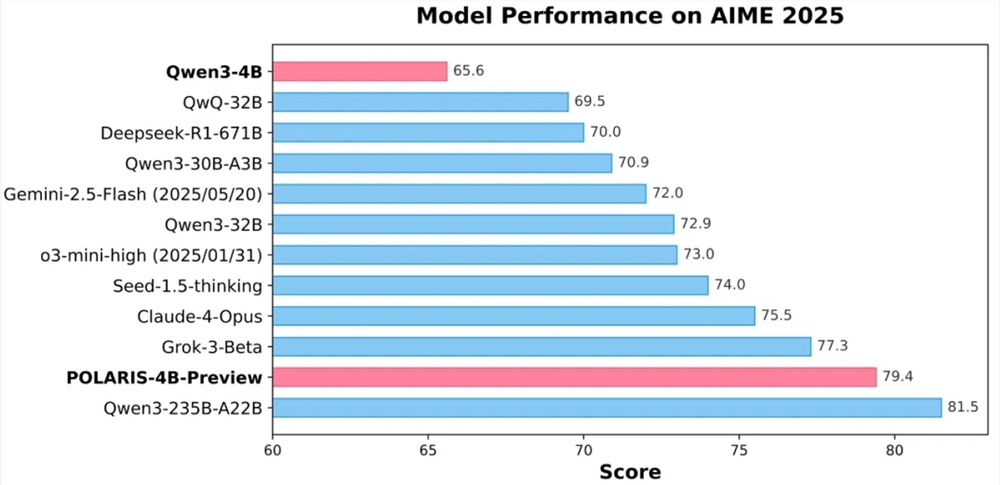

Die Experimente zeigten, dass das 40 Milliarden Parameter umfassende Open-Source-Modell Qwen3-4B, das mit POLARIS trainiert wurde, bei den mathematischen Tests AIME25 und AIME24 mit einer hohen Genauigkeit von 79,4 % bzw. 81,2 % abschnitt und die Leistung einiger größerer geschlossener Modelle übertraf. Besonders hervorzuheben ist die leichte Bauweise des POLARIS-4B-Modells, was es ermöglicht, es problemlos auf Konsumgrafikkarten zu deployen und somit die Anwendungsschwelle stark zu senken.

Der Kerninnovation von POLARIS liegt in seiner Trainingsstrategie. Das Forschungsteam stellte fest, dass durch die Anpassung der Trainingsdaten und der Hyperparameter an das zu trainierende Modell die mathematische Schlussfolgerungsfähigkeit kleiner Modelle erheblich verbessert werden kann. In der Praxis passte das Team dynamisch die Schwierigkeitsverteilung der Trainingsdaten an und erstellte ein leicht nach Problemen tendierendes Datenset, um eine zu starke Konzentration der Schwierigkeit zu vermeiden. Zudem führte das Team eine Strategie zur dynamischen Aktualisierung der Daten ein, um bei Bedarf leichtere Beispiele aus dem Training zu entfernen, um die Effektivität des Trainings sicherzustellen.

Beim Stichprobenkontrollen balancierte POLARIS die Modellleistung mit der Vielfalt der generierten Pfade durch feine Einstellungen der Stichproben-Temperatur. Es wurde festgestellt, dass die Stichproben-Temperatur einen signifikanten Einfluss auf die Modellleistung und die Vielfalt der Pfade hat. Eine zu hohe oder zu niedrige Temperatur ist für das Modelltraining ungünstig. Daher schlug das Team eine Temperaturinitialisierungsmethode vor, die den Erkundungsraum kontrolliert, und passte während des Trainings dynamisch die Stichproben-Temperatur an, um die Vielfalt der generierten Inhalte aufrechtzuerhalten.

Um die Herausforderungen bei der langen Kontexttrainierung zu meistern, führte POLARIS eine Längenausweitungstechnik ein. Durch Anpassungen der Positionscodierung RoPE kann das Modell längere Sequenzen verarbeiten, als es während des Trainings gesehen hat. Diese innovative Strategie kompensierte effektiv die Mängel bei der Langtexttrainierung und verbesserte die Leistung des Modells bei Aufgaben zur Langtextgenerierung.

Zusätzlich verwendete POLARIS auch eine mehrstufige RL-Trainingsmethode. Im frühen Stadium wurde mit einem kurzen Kontextfenster trainiert, und sobald das Modell eine stabile Leistung erreicht hatte, wurde allmählich die Länge des Kontextfensters erhöht. Diese Strategie hilft dem Modell, sich allmählich an komplexe Schlussfolgerungsaufgaben zu gewöhnen und verbessert die Stabilität und Effektivität des Trainings.

Derzeit sind die detaillierten Trainingsmethoden, Trainingsdaten, Trainingscodes und Experimentmodelle von POLARIS vollständig open source. Das Forschungsteam hat die Wirksamkeit von POLARIS an mehreren Hauptverifizierungslisten für Inferenz validiert. Die Ergebnisse zeigen, dass die Modellleistung bei verschiedenen Modellgrößen und Modellfamilien nach Anwendung der POLARIS-Trainingsmethode deutlich verbessert wird.

GitHub-Startseite:

https://github.com/ChenxinAn-fdu/POLARIS

Hugging Face-Startseite:

https://huggingface.co/POLARIS-Project