Hace unos días, el laboratorio de ciencia y tecnología Tongyi de Alibaba y la Facultad de Ciencias de la Computación de la Universidad Nankai anunciaron un método innovador de compresión de modelos de video —— LLaVA-Scissor. Esta tecnología se ha desarrollado para abordar una serie de desafíos en el procesamiento de modelos de video, especialmente los problemas de velocidad de razonamiento y escalabilidad causados por la gran cantidad de tokens que implica el procesamiento tradicional de cuadros de video.

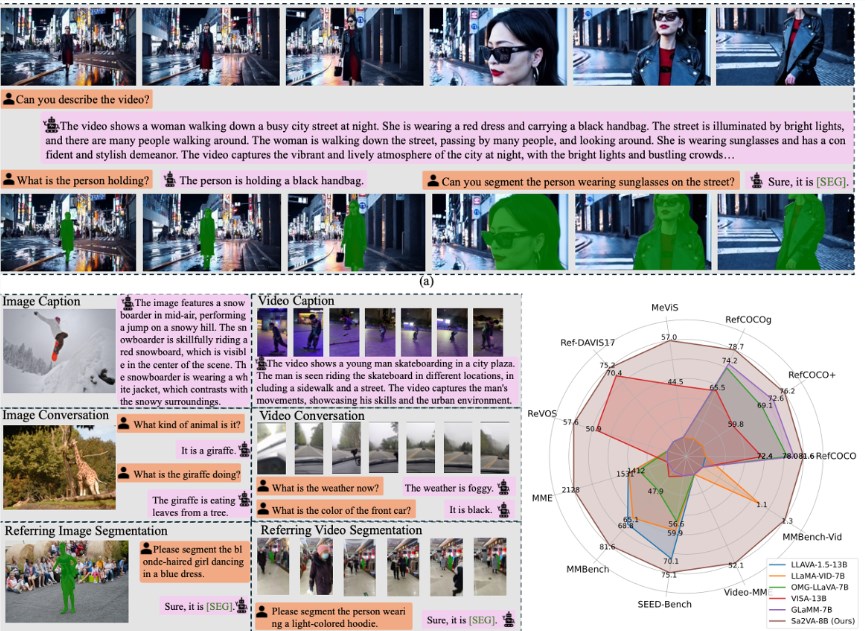

Los modelos de video necesitan codificar cada cuadro individualmente, lo que conduce a un aumento drástico en la cantidad de tokens. Aunque métodos tradicionales de compresión de tokens como FastV, VisionZip y PLLaVA han tenido ciertos resultados en el ámbito de las imágenes, en la comprensión de videos han revelado problemas como una cobertura semántica insuficiente y redundancia temporal. Para resolver esto, LLaVA-Scissor utiliza un algoritmo basado en teoría de grafos —— el método SCC, que puede identificar eficazmente diferentes áreas semánticas en conjuntos de tokens.

El método SCC calcula la similitud entre tokens, construye un gráfico de similitud y identifica componentes conectados en el gráfico. Cada token dentro de un componente conectado puede ser reemplazado por un token representativo, reduciendo así significativamente la cantidad de tokens. Para mejorar la eficiencia del procesamiento, LLaVA-Scissor utiliza una estrategia de compresión espaciotemporal en dos pasos, realizando primero la compresión espacial y luego la compresión temporal. En la compresión espacial, se identifican áreas semánticas en cada cuadro, mientras que en la compresión temporal se eliminan información redundante entre cuadros, asegurando que los tokens generados finalmente puedan representar eficientemente todo el video.

En términos de verificación experimental, LLaVA-Scissor destaca en varios benchmarks de comprensión de video, especialmente mostrando ventajas notables bajo tasas de retención de tokens bajas. Por ejemplo, en el benchmark de preguntas y respuestas de video, LLaVA-Scissor alcanza un rendimiento comparable al modelo original con una tasa de retención de tokens del 50%, y supera a otros métodos con tasas del 35% y del 10%. En pruebas de comprensión de videos largos, el método también muestra un buen rendimiento; en el conjunto de datos EgoSchema, LLaVA-Scissor alcanza una precisión del 57,94% con una tasa de retención de tokens del 35%.

Esta innovadora tecnología de compresión no solo mejora la eficiencia del procesamiento de videos, sino que también abre nuevas direcciones para el desarrollo futuro de la comprensión y el procesamiento de videos. La presentación de LLaVA-Scissor sin duda tendrá un impacto positivo en el campo de la inteligencia artificial de videos.

Puntos clave:

🌟 LLaVA-Scissor es una tecnología innovadora de compresión de modelos grandes de video desarrollada conjuntamente por Alibaba y la Universidad Nankai, diseñada para resolver el problema de aumento excesivo de tokens en métodos tradicionales.

🔍 El método SCC calcula la similitud entre tokens, construye un gráfico y identifica componentes conectados, permitiendo reducir eficazmente la cantidad de tokens y preservar la información semántica clave.

🏆 LLaVA-Scissor muestra un excelente rendimiento en varios benchmarks de comprensión de video, destacando particularmente su ventaja significativa bajo tasas de retención de tokens bajas.