Récemment, la société de vidéos IA Genmo a annoncé le lancement de Mochi1, un nouveau modèle de génération de vidéos open source permettant aux utilisateurs de créer des vidéos de haute qualité à partir d'invites textuelles. Les performances de Mochi1 sont considérées comme comparables, voire supérieures, à celles des principaux concurrents propriétaires du marché, tels que Runway, Dream Machine de Luma AI, Kuaishou Ke Ling, et Hailuo de Minimax.

Ce modèle est disponible sous licence Apache2.0, permettant aux utilisateurs d'accéder gratuitement à une technologie de pointe de génération de vidéos, contrairement à d'autres produits concurrents dont les tarifs varient de plans gratuits limités à 94,99 $ par mois.

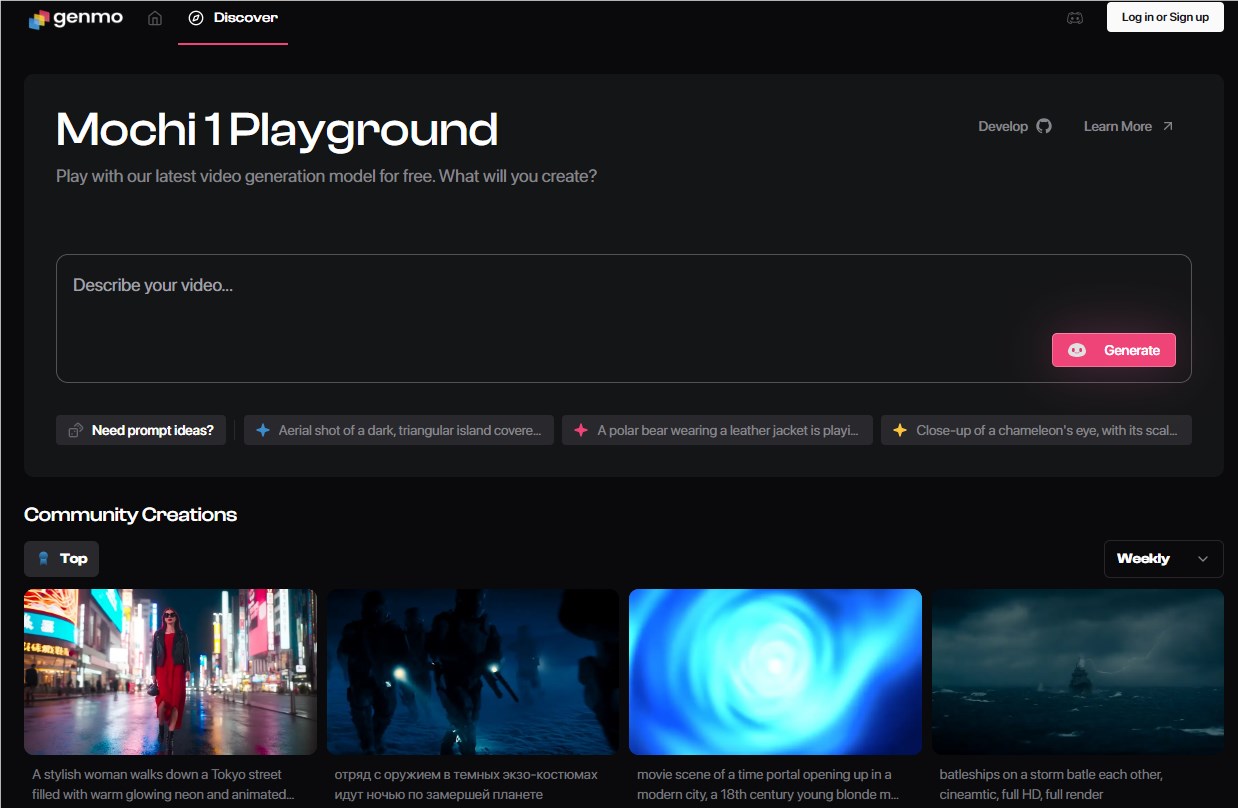

Les poids du modèle et le code de Mochi1 peuvent être téléchargés gratuitement sur Hugging Face. Cependant, pour exécuter ce modèle sur un appareil personnel, il faut au minimum quatre GPU Nvidia H100. Pour permettre aux utilisateurs de découvrir les fonctionnalités de Mochi1, Genmo propose également une plateforme d'essai en ligne.

Exemples de vidéos générées par Mochi1 :

Selon Genmo, Mochi1 excelle dans le respect des instructions détaillées des utilisateurs, permettant un contrôle précis des personnages, des décors et des actions dans les vidéos générées. Genmo affirme que lors de tests internes, Mochi1 a surpassé la plupart des autres modèles d'IA vidéo, y compris les concurrents propriétaires Runway et Luna, en termes de rapidité d'adhérence et de qualité de mouvement.

Mochi1 a réalisé des progrès significatifs dans le domaine de la génération de vidéos, notamment en termes de rendu de mouvements haute fidélité et de précision du suivi des invites. Le PDG de Genmo, Paras Jain, a déclaré que leur objectif était de réduire l'écart entre les modèles de génération de vidéos open source et propriétaires. Il a souligné que la vidéo était la forme de communication la plus importante, et qu'ils souhaitaient donc rendre cette technologie accessible à un plus grand nombre de personnes.

Parallèlement, Genmo a annoncé avoir bouclé un tour de financement de série A de 28,4 millions de dollars, avec la participation de NEA et de plusieurs sociétés de capital-risque. Jain a indiqué que la génération de vidéos n'était pas seulement un outil de divertissement ou de création de contenu, mais aussi un outil important pour les robots et les systèmes autonomes du futur.

L'architecture de Mochi1 est basée sur le transformateur de diffusion asymétrique (AsymmDiT) développé par Genmo, le plus grand modèle de génération de vidéos open source publié à ce jour, avec 10 milliards de paramètres. Ce modèle se concentre sur le raisonnement visuel, ce qui lui confère un avantage dans le traitement des données vidéo.

Exemples de vidéos générées par Mochi1 :

Bien que Mochi1 ait déjà démontré de puissantes fonctionnalités, il présente encore certaines limitations, telles qu'une résolution actuelle de 480p et de légères distorsions visuelles dans les scènes de mouvements complexes. Genmo prévoit de lancer une version Mochi1HD prenant en charge une résolution 720p d'ici la fin de l'année, afin d'améliorer l'expérience utilisateur.

Accès à la démo :https://www.genmo.ai/play

Téléchargement du modèle : https://huggingface.co/genmo/mochi-1-preview

Points clés :

🌟 Mochi1 est un modèle de génération de vidéos open source développé par Genmo, gratuit pour les utilisateurs et offrant des performances comparables à plusieurs produits propriétaires.

💰 Genmo a bouclé un tour de financement de série A de 28,4 millions de dollars, visant à démocratiser la technologie vidéo IA.

🎥 Une version Mochi1HD sera prochainement lancée pour résoudre les limitations actuelles de résolution 480p et de certaines scènes de mouvements complexes.