Un equipo de investigación de la Universidad de Waterloo y Meta han desarrollado conjuntamente MoCha, un sistema de inteligencia artificial capaz de generar animaciones de personajes completas con audio sincronizado y movimientos naturales. A diferencia de los modelos anteriores que se centraban únicamente en la generación de animaciones faciales, MoCha puede renderizar movimientos corporales completos desde múltiples ángulos de cámara, incluyendo sincronización labial, gestos y la interacción entre varios personajes.

Mejorar la precisión de la sincronización labial

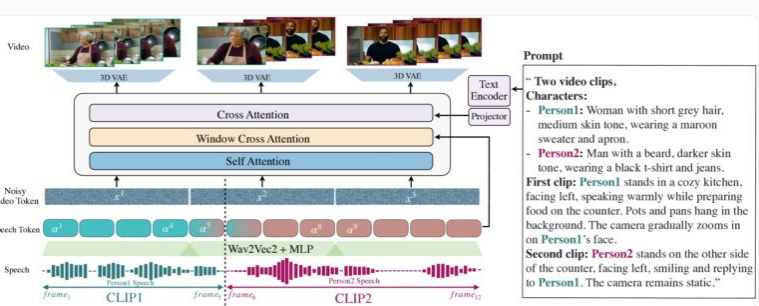

La demostración de MoCha destaca la generación sincronizada de movimientos de la parte superior del cuerpo y gestos en primeros planos y planos medios. La singularidad del sistema radica en su mecanismo de "atención a la ventana de audio-video", que resuelve dos desafíos importantes de larga data en la generación de video con IA: mantener la resolución completa del audio durante la compresión de video y evitar la discrepancia entre el movimiento labial y el audio durante la generación paralela de video.

La innovación de MoCha reside en la simulación de la forma en que los humanos hablan, limitando el acceso a una ventana específica de datos de audio por fotograma. El movimiento de los labios está estrechamente relacionado con el sonido inmediato, mientras que el lenguaje corporal se basa en patrones de texto más amplios. Al agregar marcadores antes y después de cada fotograma de audio, MoCha logra transiciones más suaves y una sincronización labial más precisa.

MoCha genera videos realistas con expresiones faciales, gestos y movimientos labiales a partir de descripciones de texto.

Para construir el sistema, el equipo de investigación utilizó 300 horas de contenido de video cuidadosamente seleccionado y combinó secuencias de video basadas en texto para ampliar las posibilidades de expresión e interacción. Especialmente en escenas con múltiples personajes, MoCha demuestra su potencia; el usuario solo necesita definir los personajes una vez y puede llamarlos fácilmente en diferentes escenas usando etiquetas (como "Personaje 1" o "Personaje 2") sin necesidad de descripciones repetidas.

Gestionar múltiples personajes

En pruebas con 150 escenas diferentes, MoCha superó a sistemas similares en la calidad de la sincronización labial y la naturalidad de los movimientos. Los evaluadores independientes coincidieron en que los videos generados por el sistema eran altamente realistas y mostraban una precisión y naturalidad sin precedentes.

Los investigadores desarrollaron una plantilla de indicaciones para que los usuarios puedan referirse a personajes específicos sin descripciones repetidas.

El desarrollo de MoCha muestra un gran potencial en diversas áreas de aplicación, especialmente en asistentes digitales, avatares virtuales, publicidad y contenido educativo. Aunque Meta aún no ha revelado si el sistema será de código abierto o si se encuentra en fase de prototipo de investigación, el lanzamiento de esta tecnología sin duda abre un nuevo capítulo en la generación de video impulsada por IA.

En un contexto de creciente competencia en la tecnología de video de inteligencia artificial, el lanzamiento de MoCha es especialmente notable. Meta también lanzó recientemente el sistema MovieGen, mientras que ByteDance, la empresa matriz de TikTok, está desarrollando sus propias herramientas de animación de inteligencia artificial, incluyendo INFP, OmniHuman-1 y Goku, lo que demuestra la apuesta activa de las empresas de redes sociales en este campo.