最近、バイトダンスのSeedチームは香港大学と復旦大学と協力して、革新的な強化学習トレーニング方法であるPOLARISを共同で発表しました。この方法は、設計されたScaling RL戦略により、小規模モデルの数学的推論能力を大規模モデルと同等にまで向上させることに成功し、人工知能分野における小規模モデルの最適化に新たな道を開きました。

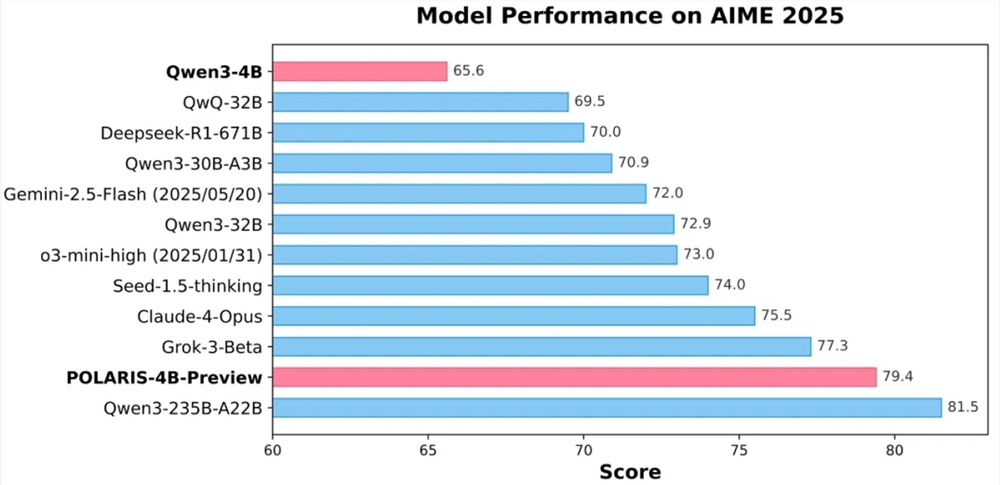

実験結果によると、POLARISでトレーニングされた40億パラメータのオープンソースモデルQwen3-4Bは、AIME25およびAIME24の数学テストにおいてそれぞれ79.4%および81.2%の高い正確率を達成し、一部のより大規模な非公開モデルを上回る性能を示しました。特に注目すべきは、POLARIS-4Bモデルの軽量設計により、コンsumer級のGPUでも簡単にデプロイ可能であり、応用のハードルを大幅に下げた点です。

POLARISの核心的なイノベーションはそのトレーニング戦略にあります。研究チームは、トレーニング対象モデルに合わせてトレーニングデータとハイパーパラメータをカスタマイズすることで、小規模モデルの数学的推論能力を著しく向上させることができることを発見しました。具体的には、トレーニングデータの難易度分布を動的に調整し、やや難問に偏ったデータセットを構築することで、サンプルの難易度が過度に集中しないようにしました。また、データの動的更新戦略を導入し、モデルのトレーニング中のパフォーマンスに基づいて過度に簡単なサンプルをリアルタイムで除外し、トレーニングの効果を保証しました。

サンプリング制御に関しては、POLARISは細かく調整されたサンプリング温度によって、モデルのパフォーマンスと生成パスの多様性のバランスを取っています。研究では、サンプリング温度がモデルのパフォーマンスとパスの多様性に顕著な影響を与えることが判明し、温度が高すぎたり低すぎたりするとトレーニングに不利益になることがわかりました。そのため、探索領域を制御する温度初期化方法を提案し、トレーニング中にサンプリング温度を動的に調整することで、生成コンテンツの多様性を維持しました。

長文のトレーニングに直面する課題に対して、POLARISは長さエクストラポレーション技術を導入し、位置符号化RoPEの調整を通じて、トレーニング時に見たよりも長いシーケンスを処理できるようにしています。このイノベーティブな戦略は、長文トレーニングにおける不足を効果的に補償し、長文生成タスクでのモデル性能を向上させました。

さらに、POLARISは複数段階のRLトレーニング方法を採用しています。初期段階では短いコンテキストウィンドウでトレーニングを行い、モデルの性能が収束した後、徐々にコンテキストウィンドウの長さを増加させます。この戦略により、モデルは徐々に複雑な推論タスクに適応でき、トレーニングの安定性と効果を高めました。

現在、POLARISの詳細なトレーニング方法、トレーニングデータ、トレーニングコード、および実験モデルはすべてオープンソースとなっています。研究チームは複数の主要な推論評価セットでPOLARISの有効性を検証し、結果として、さまざまな規模のモデルおよび異なるモデルファミリがPOLARISトレーニング方法を適用した後のモデル効果が著しく向上していることが確認されました。

GitHub ホームページ:

https://github.com/ChenxinAn-fdu/POLARIS

Hugging Face ホームページ:

https://huggingface.co/POLARIS-Project