Uma equipe de pesquisa da Meta e da Universidade de Waterloo desenvolveram conjuntamente um sistema de inteligência artificial chamado MoCha, capaz de gerar animações de personagens completas, incluindo fala sincronizada e movimentos naturais. Esta inovação se diferencia dos modelos de geração de animação facial existentes, pois o MoCha pode renderizar movimentos corporais completos a partir de múltiplas câmeras, incluindo sincronização labial, gestos e interação entre vários personagens.

Melhorando a precisão da sincronização labial

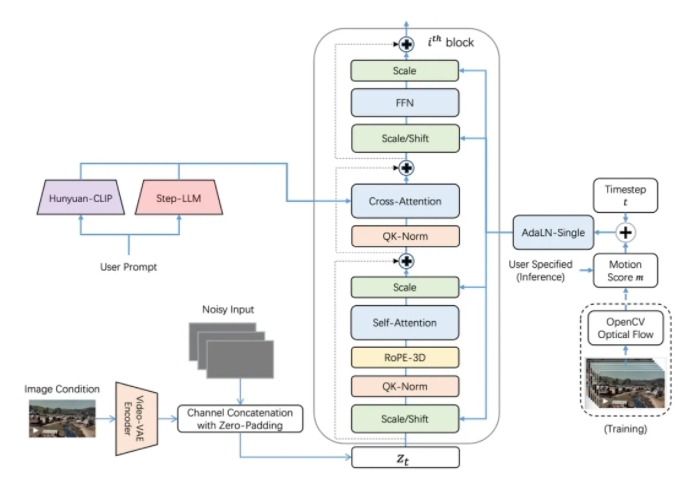

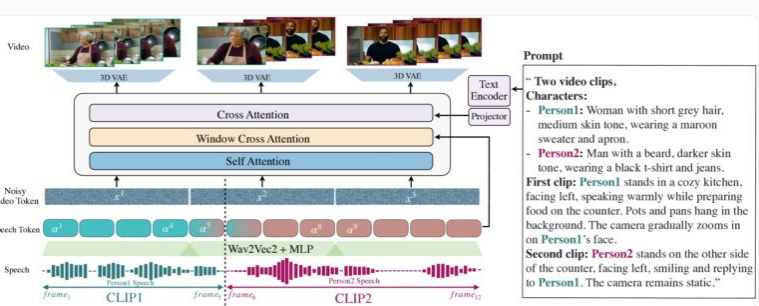

A demonstração do MoCha destaca a geração sincronizada de movimentos da parte superior do corpo e gestos em close-ups e planos médios. A singularidade do sistema reside em seu mecanismo de "atenção da janela áudio-vídeo", que resolve dois desafios de longa data na geração de vídeo por IA: como manter a resolução total do áudio durante a compressão de vídeo e como evitar a dessincronização entre o movimento labial e o áudio durante a geração paralela de vídeo.

A inovação do MoCha está em simular a forma como os humanos falam, limitando o acesso a uma janela específica de dados de áudio para cada quadro – o movimento dos lábios está intimamente relacionado ao som imediato, enquanto a linguagem corporal é baseada em padrões de texto mais amplos. Ao adicionar marcadores antes e depois de cada quadro de áudio, o MoCha consegue transições mais suaves e sincronização labial mais precisa.

O MoCha gera vídeos realistas com rosto, gestos e movimentos labiais com base em descrições de texto.

Para construir o sistema, a equipe de pesquisa utilizou 300 horas de conteúdo de vídeo cuidadosamente selecionado e combinou sequências de vídeo baseadas em texto para expandir as possibilidades de expressão e interação. Especialmente em cenários com múltiplos personagens, o MoCha demonstra sua capacidade robusta; os usuários precisam definir os personagens apenas uma vez e podem chamá-los facilmente em diferentes cenários usando tags (como "personagem 1" ou "personagem 2"), sem necessidade de descrições repetidas.

Gerenciando múltiplos personagens

Em testes com 150 cenários diferentes, o MoCha superou sistemas semelhantes em termos de qualidade de sincronização labial e movimentos naturais. Avaliadores independentes concordaram que os vídeos gerados pelo sistema são altamente realistas e demonstram precisão e naturalidade sem precedentes.

Os pesquisadores desenvolveram um modelo de prompt que permite aos usuários referenciar personagens específicos sem descrições repetidas.

O desenvolvimento do MoCha demonstra um enorme potencial em várias áreas de aplicação, especialmente em assistentes digitais, avatares virtuais, publicidade e conteúdo educacional. Embora a Meta ainda não tenha revelado se o sistema será de código aberto ou se ainda está em fase de protótipo de pesquisa, o lançamento dessa tecnologia certamente abre um novo capítulo para a geração de vídeo impulsionada por IA.

No contexto da crescente competição na tecnologia de vídeo de inteligência artificial, o lançamento do MoCha é particularmente notável. A Meta lançou recentemente o sistema MovieGen, enquanto a ByteDance, empresa-mãe do TikTok, está desenvolvendo suas próprias ferramentas de animação de inteligência artificial, incluindo INFP, OmniHuman-1 e Goku, mostrando a postura ativa das empresas de mídia social neste campo.