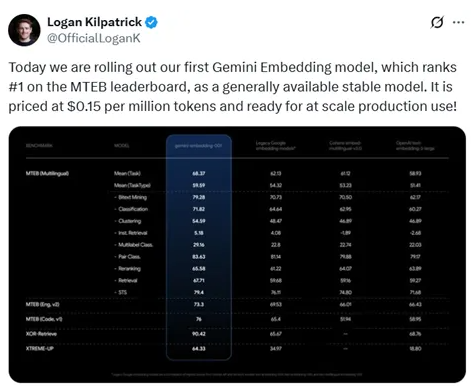

Am 15. Juli 2023 veröffentlichte Google um 1 Uhr morgens offiziell das erste Gemini-Einbettungsmodell. Das Modell erreichte mit einer hohen Bewertung von 68,37 den ersten Platz auf der Benchmark-Plattform für multilinguale Text-Einbettungen (MTEB), wodurch es die Bewertung von OpenAI mit 58,93 übertraf. Dieser Erfolg zeigt nicht nur, dass Google in der Einbettungstechnologie führend ist, sondern bietet auch unabhängigen Kreativen und Freiberuflern eine kosteneffizientere Wahl: Die Kosten für die Nutzung des Gemini-Einbettungsmodells betragen lediglich 0,15 US-Dollar pro 1 Million Token.

Die starken Funktionen des Gemini-Einbettungsmodells

Laut den Testergebnissen schnitt das Gemini-Einbettungsmodell in verschiedenen Aufgaben wie bilingualer Suche, Klassifizierung, Clustering, Anweisungsretrieval, Mehrlabel-Klassifizierung, Paar-Klassifizierung, Neuanordnung, Retrieval und semantischer Textähnlichkeit sehr gut ab und ist somit das leistungsstärkste Einbettungsmodell derzeit. Seine Multisprachfähigkeit macht es besonders vielversprechend für globale Anwendungen, insbesondere bei einer großen Anzahl von Benutzern, deren Muttersprache nicht Englisch ist.

Modellarchitektur und technologische Innovationen

Das Gemini-Einbettungsmodell wurde auf Basis einer bidirektionalen Transformer-Encoder-Architektur entworfen und behält die bidirektionale Aufmerksamkeitsmechanik des Gemini-Modells bei, wodurch seine prätrainierte Sprachverstehensfähigkeit optimal genutzt wird. Auf der Grundlage der untersten 32 Schichten des Transformers wurde ein Pooling-Layer hinzugefügt, der die Embeddings jedes Tokens aus dem Eingabesequenz aggregiert, um einen einzelnen Embedding-Vektor zu generieren. Die verwendete Mittelwert-Pooling-Strategie ist einfach und effektiv und verbessert die Anpassungsfähigkeit des Modells.

Trainingsmethode und Datenqualitätskontrolle

Im Trainingsprozess setzte das Gemini-Einbettungsmodell eine mehrstufige Trainingsstrategie ein, die aus zwei Phasen besteht: Vortuning und Feintuning. In der Vortuning-Phase trainierte das Modell mit Daten aus einem großflächigen Web-Korpus, wobei das Hauptziel darin bestand, die Parameter von autoregressiven Generierungsaufgaben auf Codierungsmissionen anzupassen. In der Feintuning-Phase erfolgte eine feiner abgestimmte Ausbildung anhand spezifischer Aufgaben, um sicherzustellen, dass das Modell bei Aufgaben wie Retrieval, Klassifizierung und Clustering effizient arbeitet.

Um die Datenqualität zu verbessern, entwickelte das Forschungsteam eine Strategie zur Generierung synthetischer Daten und nutzte Gemini, um die Trainingsdaten zu filtern und niedrigwertige Beispiele zu entfernen, um die Effektivität des Modells während des Trainings sicherzustellen.

Die Veröffentlichung des Gemini-Einbettungsmodells markiert einen wichtigen Fortschritt im Bereich der Einbettungstechnologie von Google und verstärkt seine Wettbewerbsfähigkeit im Bereich Künstliche Intelligenz. Mit der Verbreitung dieses Modells wird voraussichtlich die Entwicklung von Anwendungen wie Suche und personalisierte Empfehlungen vorangetrieben werden.

Testadresse: https://aistudio.google.com/prompts/new_chat