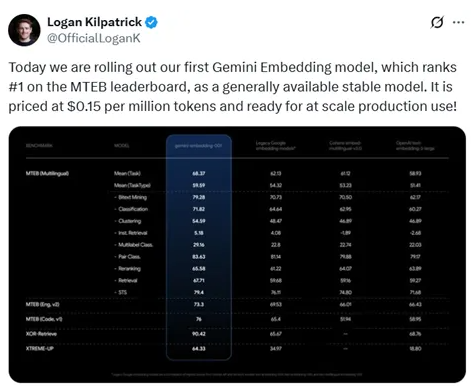

El 15 de julio de 2023, Google lanzó oficialmente su primer modelo de incrustación Gemini a la 1:00 de la madrugada. Este modelo obtuvo una alta calificación de 68,37 en la plataforma de prueba de referencia de incrustaciones de texto multilingüe (MTEB), ocupando el primer lugar, superando los 58,93 puntos de OpenAI. Este logro no solo demuestra la ventaja de Google en la tecnología de incrustación, sino que también ofrece una opción más económica para creadores independientes y profesionales libres: el costo de uso del modelo de incrustación Gemini es de 0,15 dólares por cada 1 millón de tokens.

Las poderosas funciones del modelo de incrustación Gemini

Según los resultados de las pruebas, el modelo de incrustación Gemini destacó en múltiples tareas como minería bilingüe, clasificación, agrupamiento, recuperación de instrucciones, clasificación con múltiples etiquetas, clasificación de pares, reordenamiento, recuperación y similitud semántica de textos, convirtiéndose así en el modelo de incrustación más potente actualmente. Su capacidad multilingüe le da mayor potencial de aplicación a nivel mundial, especialmente entre un gran número de usuarios cuyo idioma materno no es el inglés.

Arquitectura del modelo y innovaciones técnicas

El modelo de incrustación Gemini se diseñó basándose en una arquitectura de codificador de Transformer bidireccional, manteniendo la mecanismo de atención bidireccional del modelo Gemini, aprovechando plenamente su capacidad de comprensión del lenguaje preentrenado. En la base de 32 capas de Transformer en el nivel inferior, se agregó una capa de pooling para agrupar las incrustaciones de cada token de la secuencia de entrada y generar un vector de incrustación único. La estrategia de pooling promedio es simple y efectiva, mejorando la adaptabilidad del modelo.

Métodos de entrenamiento y control de calidad de los datos

Durante el proceso de entrenamiento, el modelo de incrustación Gemini utilizó una estrategia de entrenamiento en varias etapas, dividida en dos etapas: preajuste y ajuste fino. En la etapa de preajuste, el modelo se entrenó utilizando datos de grandes colecciones de Web, con el objetivo principal de adaptar los parámetros de tareas de generación autoregresiva a tareas de codificación. En la etapa de ajuste fino, se realizó un entrenamiento más detallado con datos de tareas específicas, asegurando un rendimiento eficiente del modelo en tareas como recuperación, clasificación y agrupamiento.

Para mejorar la calidad de los datos, el equipo de investigación diseñó una estrategia de generación de datos sintéticos y utilizó Gemini para filtrar los datos de entrenamiento, eliminando muestras de baja calidad y garantizando la eficacia del modelo durante el entrenamiento.

La publicación del modelo de incrustación Gemini marca un avance importante en la tecnología de incrustación de Google, fortaleciendo su competitividad en el campo de la inteligencia artificial. Con la difusión de este modelo, se espera que impulsen el desarrollo de aplicaciones como búsqueda, recomendaciones personalizadas y otras.

Enlace de experiencia: https://aistudio.google.com/prompts/new_chat