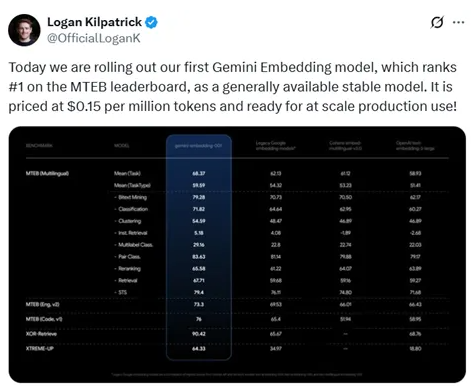

Le 15 juillet 2023, Google a officiellement lancé son premier modèle d'encodage Gemini à 1 heure du matin. Ce modèle a obtenu un score élevé de 68,37 sur la plateforme d'évaluation des modèles d'encodage multilingue (MTEB), se classant ainsi en tête, dépassant le score de 58,93 d'OpenAI. Ce résultat démontre non seulement la position de leader de Google dans le domaine des technologies d'encodage, mais offre également une solution plus économique aux créateurs indépendants et aux travailleurs indépendants : le coût d'utilisation du modèle d'encodage Gemini est de seulement 0,15 dollar par million de tokens.

Les puissantes fonctionnalités du modèle d'encodage Gemini

Selon les résultats des tests, le modèle d'encodage Gemini s'est distingué dans plusieurs tâches telles que l'extraction bilingue, la classification, le regroupement, la recherche d'instructions, la classification à plusieurs étiquettes, la classification par paires, le réordonnancement, la recherche et la similarité sémantique entre textes. Il est devenu le meilleur modèle d'encodage actuel. Sa capacité multilingue lui confère un potentiel d'application mondial, en particulier parmi un grand nombre d'utilisateurs dont la langue maternelle n'est pas l'anglais.

Architecture du modèle et innovations technologiques

Le modèle d'encodage Gemini est conçu sur une architecture de codeur Transformer bidirectionnel, conservant ainsi le mécanisme d'attention bidirectionnelle du modèle Gemini, exploitant pleinement ses capacités de compréhension linguistique préentraînée. Sur la base des 32 couches Transformer inférieures, un couche de pooling a été ajoutée pour agréger les encodages de chaque token de la séquence d'entrée, générant ainsi un seul vecteur d'encodage. La stratégie de pooling moyen est simple et efficace, renforçant l'adaptabilité du modèle.

Méthodes d'entraînement et contrôle de la qualité des données

Pendant le processus d'entraînement, le modèle d'encodage Gemini a adopté une stratégie d'entraînement en plusieurs étapes, divisée en deux étapes : l'entraînement pré-réglage et le réglage fin. Pendant l'étape de pré-réglage, le modèle a été entraîné avec des données provenant d'un corpus Web de grande taille, avec comme objectif principal d'adapter les paramètres des tâches de génération auto-régressive aux tâches de codage. L'étape de réglage fin a ensuite permis un entraînement plus précis sur des données spécifiques à certaines tâches, assurant ainsi une performance efficace du modèle dans les tâches de recherche, de classification et de regroupement.

Pour améliorer la qualité des données, l'équipe de recherche a conçu une stratégie de génération de données synthétiques et a utilisé Gemini pour filtrer les données d'entraînement, éliminant ainsi les échantillons de faible qualité afin de garantir l'efficacité du modèle pendant l'entraînement.

Le lancement du modèle d'encodage Gemini marque une importante avancée pour Google dans le domaine des technologies d'encodage, renforçant sa compétitivité dans le domaine de l'intelligence artificielle. Avec la diffusion de ce modèle, on s'attend à ce qu'il favorise le développement de diverses applications telles que la recherche ou les recommandations personnalisées.

Adresse d'essai : https://aistudio.google.com/prompts/new_chat