A Tencent lançou o relatório técnico do modelo TurboS, revelando as inovações centrais e a capacidade poderosa de seu modelo de linguagem principal, o TurboS.

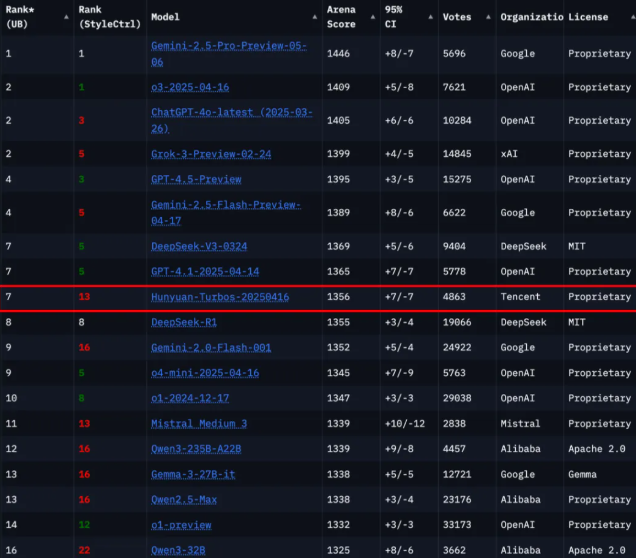

De acordo com a classificação mais recente da plataforma global de avaliação de modelos grandes Chatbot Arena, o TurboS da Hunchun ficou em sétimo lugar entre 239 modelos participantes, tornando-se o modelo de topo doméstico após o Deepseek e ficando atrás apenas de几家 instituições internacionais como Google, OpenAI e xAI.

O modelo de linguagem TurboS adota uma estrutura inovadora chamada Hybrid Transformer-Mamba, que combina eficientemente a arquitetura Mamba na manipulação de sequências longas com os pontos fortes da compreensão de contexto da arquitetura Transformer, alcançando um equilíbrio entre desempenho e eficiência. O modelo totaliza 128 camadas e tem uma quantidade de parâmetros ativos de até 560 bilhões, sendo o primeiro modelo híbrido especialista Transformer-Mamba de grande escala a ser amplamente implantado (MoE). Com essa inovação arquitetônica, o TurboS obteve uma pontuação geral alta de 1356 nos testes autorizados internacionais.

Para melhorar ainda mais a capacidade do modelo, o TurboS introduziu um mecanismo de cadeia de pensamento adaptável de comprimento variável, que pode alternar automaticamente os modos de resposta de acordo com a complexidade da questão. Esse mecanismo permite que o modelo responda rapidamente a questões simples enquanto analisa profundamente e oferece respostas de alta precisão para questões complexas. Além disso, a equipe projetou um processo de pós-treinamento contendo quatro módulos-chave, incluindo microajuste supervisionado e fusão adaptável de cadeias de pensamento de curto e longo prazo, reforçando ainda mais o desempenho do modelo.

No estágio de pré-treinamento, o TurboS foi treinado em um corpus de 16 trilhões de tokens, garantindo a qualidade e diversidade dos dados do modelo. Sua arquitetura central inclui componentes como Transformer, Mamba2 e redes neurais feedforward (FFN), com uma composição de camadas razoável, maximizando a eficiência tanto no treinamento quanto na推理.

O lançamento deste relatório técnico não apenas demonstra o poder tecnológico da Tencent no campo de modelos de linguagem grandes, mas também fornece novas ideias e direções para o desenvolvimento futuro dos modelos grandes.

Link do artigo: https://arxiv.org/abs/2505.15431

Destaque:

🌟 O modelo TurboS classificou-se em sétimo lugar no Chatbot Arena, mostrando uma forte competitividade.

💡 A inovadora arquitetura Hybrid Transformer-Mamba alcançou o melhor equilíbrio entre desempenho e eficiência.

🔍 O mecanismo de cadeia de pensamento adaptável de comprimento variável melhorou a capacidade do modelo de responder a questões de diferentes níveis de complexidade.