Die kürzlich erfolgte Einführung des VLM-R1-Projekts läutet eine neue Ära in diesem Bereich ein. Das Projekt stellt die erfolgreiche Übertragung der R1-Methode des DeepSeek-Teams auf visuelle Sprachmodelle dar und bedeutet einen entscheidenden Fortschritt im Verständnis visueller Inhalte durch KI.

VLM-R1 basiert auf der im letzten Jahr von DeepSeek veröffentlichten R1-Methode. Diese Methode nutzt die verstärkungslernende GRPO-Technik (Generative Reward Processing Optimization) und erzielte bereits bei der Verarbeitung von reinem Text hervorragende Ergebnisse. Das VLM-R1-Team hat diese Methode nun erfolgreich auf visuelle Sprachmodelle angewendet und damit neue Wege in der Forschung an multimodaler KI eröffnet.

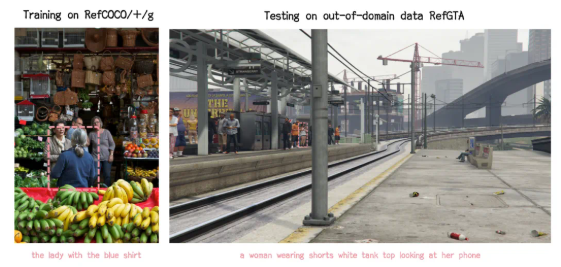

Die Ergebnisse des Projekts sind beeindruckend. Erstens zeigt die R1-Methode eine hohe Stabilität in komplexen Szenarien, was für praktische Anwendungen besonders wichtig ist. Zweitens zeichnet sich das Modell durch seine hervorragende Generalisierungsfähigkeit aus. Im Vergleich zu traditionellen SFT-Modellen (Supervised Fine-Tuning), deren Leistung bei Tests mit ausserhalb des Trainingsbereichs liegenden Daten mit zunehmender Trainingsdauer abnimmt, verbessert sich die Leistung des R1-Modells kontinuierlich. Dies deutet darauf hin, dass die R1-Methode dem Modell ein echtes Verständnis visueller Inhalte vermittelt und nicht nur auf Auswendiglernen basiert.

Darüber hinaus ist VLM-R1 sehr einfach zu bedienen. Das Team stellt Entwicklern einen vollständigen Trainings- und Evaluierungsprozess zur Verfügung, der einen schnellen Einstieg ermöglicht. In einem praktischen Beispiel wurde das Modell aufgefordert, in einem Bild mit reichhaltigem Essen das Lebensmittel mit dem höchsten Proteingehalt zu finden. Das Modell antwortete nicht nur korrekt, sondern markierte auch präzise den proteinreichsten Eierkuchen im Bild – ein Beweis für sein aussergewöhnliches visuelles Verständnis und seine Schlussfolgerungsfähigkeit.

Die erfolgreiche Einführung von VLM-R1 beweist nicht nur die Universalität der R1-Methode, sondern bietet auch neue Ansätze für das Training multimodaler Modelle und läutet eine neue Ära im Training visueller Sprachmodelle ein. Besonders erfreulich ist, dass das Projekt vollständig Open Source ist und interessierte Entwickler die entsprechenden Informationen auf GitHub finden können.

Zusammenfassend lässt sich sagen, dass VLM-R1 der Forschung zu visuellen Sprachmodellen neuen Schwung verleiht. Wir erwarten, dass sich viele Entwickler beteiligen und den Fortschritt der multimodalen KI-Technologie vorantreiben.