ByteDance hat die Open-Source-Veröffentlichung des VINCIE-3B angekündigt, eines Modells mit 3 Milliarden Parametern, das kontextbasierte Bildbearbeitung in fortlaufenden Bildsequenzen unterstützt. Das Modell wurde auf Basis der internen MM-DiT-Architektur entwickelt. Es überwindet die Grenzen traditioneller Bildbearbeitungsmodelle und ermöglicht erstmals, kontextbasierte Bildbearbeitungsfähigkeiten aus einem einzigen Videodatensatz zu lernen, ohne auf komplexe Segmentierungs- oder Reparaturmodelle angewiesen zu sein, um Trainingsdaten zu generieren. Die Veröffentlichung von VINCIE-3B bringt neue Möglichkeiten für kreative Gestaltung, Filmproduktion und Inhaltserstellung mit sich. AIbase analysiert detailliert dessen technische Highlights, Anwendungsfälle und Brancheneffekte.

Technologischer Durchbruch: Von Videos zur kontextbasierten Bearbeitung

Traditionelle Bildbearbeitungsmodelle verlassen sich oft auf spezifische Datenkanäle für Aufgaben, wobei Trainingsdaten durch Expertenmodelle (wie Segmentierung oder Reparatur) generiert werden müssen. Dies ist kostspielig und komplex. VINCIE-3B geht innovativ einen anderen Weg und lernt direkt aus Videos. Dabei wird das Video in ein abwechselndes Multimodal-Sequence (Text + Bild) umgewandelt, um kontextbasierte Bildbearbeitung zu ermöglichen. Zu den technischen Highlights gehören:

- Videogestützte Trainingsmethode: VINCIE-3B nutzt die aufeinanderfolgenden Bilder eines Videos, um automatisch Textbeschreibungen und Bildsequenzen zu extrahieren und so Multimodal-Trainingsdaten zu erstellen. Dieser Ansatz vermeidet die Abhängigkeit von traditionellen Expertenmodellen und senkt deutlich die Kosten für die Datenvorbereitung.

- Block-kausal Transformer für Diffusion: Das Modell verwendet eine block-kausale Aufmerksamkeitsmechanik, um kausale Aufmerksamkeit zwischen Text und Bildblöcken zu ermöglichen. Innerhalb jedes Blocks hingegen wird bidirektionale Aufmerksamkeit verwendet. Diese Architektur sorgt für eine effiziente Informationsübertragung und gewährleistet gleichzeitig die kausale Konsistenz der Zeitreihen.

- Dreifache Agententask-Training: VINCIE-3B wird mit drei Aufgaben trainiert: Vorhersage der nächsten Frame, Vorhersage der aktuellen Frame-Segmentierung und Vorhersage der nächsten Frame-Segmentierung. Dadurch wird das Verständnis dynamischer Szenen und Objektbeziehungen verbessert.

- Kombination von sauberen und Rauschbedingungen: Um Probleme bei der Eingabe von Rauschbildern in Diffusionsmodellen zu lösen, gibt VINCIE-3B sowohl saubere als auch Rauschbilder ein und nutzt Aufmerksamkeitsmasken, um sicherzustellen, dass Rauschbilder nur anhand sauberer Kontexte generiert werden. Dies erhöht die Qualität der Bearbeitung.

In Leistungstests erreicht VINCIE-3B führende Ergebnisse (SOTA) auf dem KontextBench und neuen Benchmark-Tests für mehrstufige Bildbearbeitung. Besonders gut abschneidet es bei Textfolge, Rollenkonsistenz und Komplexitätsbearbeitung (wie Bewegung von dynamischen Objekten). Die durchschnittliche Zeit, um ein hochwertiges bearbeitetes Bild zu generieren, beträgt etwa 4 Sekunden, und die Inferenzgeschwindigkeit ist etwa 8-mal schneller als bei ähnlichen Modellen.

Open-Source-Ökosystem: Entwicklern weltweit zugänglich

Die vollständige Codebasis, Modelldaten und der Prozess der Datenaufbereitung wurden am 14. Juni 2025 auf GitHub und arXiv veröffentlicht. Entwickler können über eine Anfrage den Zugang zum vollständigen Datensatz erhalten (Kontakt-E-Mail: yangsiqian@bilibili.com). Das Modell basiert auf der MM-DiT-Architektur (Versionen mit 3B und 7B Parametern) von ByteDance und wird unter der Apache 2.0-Lizenz veröffentlicht, die nichtkommerzielle Nutzung erlaubt. Für kommerzielle Anwendungen ist eine Lizenz von ByteDance erforderlich.

ByteDance hat zudem einen mehrstufigen Bildbearbeitungsbenchmark veröffentlicht, der echte Szenarien enthält und die Community dazu anregt, die Modellleistung zu überprüfen und zu optimieren. Auf sozialen Medien haben Entwickler die Open-Source-Veröffentlichung von VINCIE-3B positiv aufgenommen und begrüßen seine Methode, „aus Videos zu lernen“, als neue, kostengünstige Strategie für künstliche Intelligenz-Inhaltsproduktion.

Anwendungsfälle: Gewinn für Kreativität und Produktivität

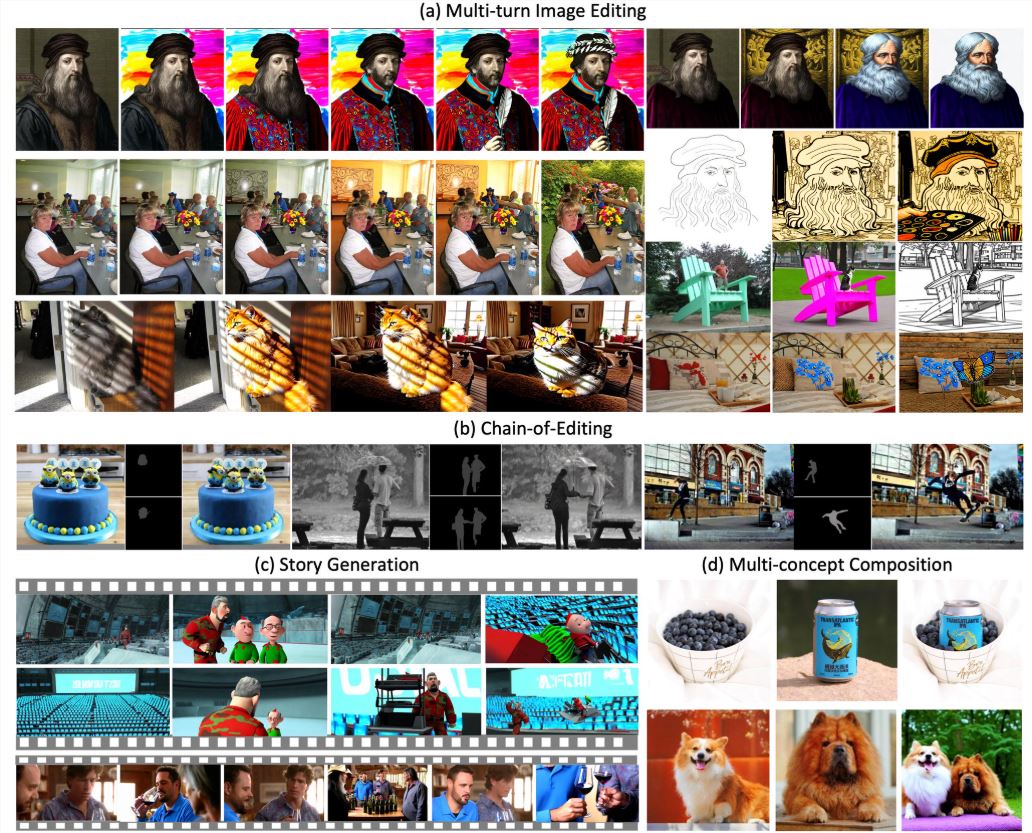

VINCIE-3B unterstützt kontinuierliche Bearbeitung basierend auf Text und vorherigen Bildern und eignet sich für verschiedene Szenarien:

- Filmproduktion: Extraktion von Figuren oder Objekten aus Video-Frames und kontinuierliche Bearbeitung, um sie an unterschiedliche Szenen anzupassen, z. B. das Verschieben einer Figur von innen nach außen, wobei Licht und Perspektive beibehalten werden.

- Markenwerbung: Platzieren von Produkten oder Logo in verschiedenen Hintergründen (z. B. Café, Außendisplay), automatisches Anpassen von Beleuchtung, Schatten und Perspektive, um die Erstellung von Werbematerialien für verschiedene Szenen zu vereinfachen.

- Spiele und Animation: Anpassung von Figurenaktionen oder Szenenelementen per Textanweisung, Unterstützung schneller Prototypenerstellung und Animationsvorschau.

- Social Media-Inhalte: Kreative können aus einem einzelnen Bild eine dynamische Sequenz generieren, z. B. eine statische Figurenbild in eine dynamische Emojis-Galerie umwandeln.

Zum Beispiel kann der Prompt „Bringe das Mädchen in einem roten Kleid vom Park an den Strand, behalte das Kleid-Muster bei und passe es auf Sonnenuntergangsbeleuchtung an“ ein natürlich verschmolzenes Bild generieren, mit hoher Realismus in Kleidmuster und Lichteffekten. Tests von AIbase zeigen, dass VINCIE-3B bei mehrstufiger Bearbeitung eine Rollenkonsistenz von über 90 % aufweist, was besser ist als FLUX.1Kontext [pro] in komplexen Szenen.

Grenzen und Herausforderungen

Obwohl VINCIE-3B hervorragende Leistungen zeigt, gibt es immer noch einige Einschränkungen:

- Einschränkungen bei mehrstufiger Bearbeitung: Zu viele Bearbeitungsschritte können visuelle Artefakte verursachen und die Bildqualität beeinträchtigen. Benutzer werden empfohlen, Bearbeitungen innerhalb von 5 Schritten abzuschließen, um optimale Ergebnisse zu erzielen.

- Sprachunterstützung: Das Modell unterstützt derzeit hauptsächlich englische Anweisungen, während die Textfolge in Chinesisch und anderen Sprachen etwas schlechter ist. ByteDance plant, die Mehrsprachigkeit in zukünftigen Versionen zu optimieren.

- Urheberrechtsfragen: Ein Teil der Trainingsdaten stammt aus öffentlichen Videos und könnte potenzielle Urheberrechtsstreitigkeiten verursachen. Benutzer sollten bei kommerziellen Anwendungen sicherstellen, dass ihre Inhalte rechtskonform sind.

AIbase empfiehlt Benutzern, das mitgelieferte KontextBench-Datenset zu testen, um die Optimierung der Prompt-Designs zu unterstützen. Für kommerzielle Nutzer wird empfohlen, sich direkt an ByteDance zu wenden, um die Lizenzbedingungen zu klären.

Brancheneffekte: Bildbearbeitung neu definiert

Die Veröffentlichung von VINCIE-3B markiert eine Paradigmenverschiebung in der Bildbearbeitung – von statisch zu dynamisch, von einfach zu kontextbasiert kontinuierlich. Im Vergleich zu Black Forest Labs' FLUX.1Kontext (die sich auf statische Bildbearbeitung konzentrieren), ermöglicht VINCIE-3B durch Lernen aus Videos eine stärkere Verarbeitung dynamischer Szenen, insbesondere für Anwendungen mit zeitlicher Konsistenz. Im Vergleich zu Bilibilis AniSora V3 (die sich auf Anime-Videos konzentrieren), ist VINCIE-3B allgemeiner und deckt sowohl reale Szenen als auch virtuelle Inhaltsgenerierung ab.

ByteDances Open-Source-Strategie festigt seine Position als führendes Unternehmen im Bereich KI-Kreativwerkzeuge. AIbase glaubt, dass die „Video-zu-Bild“-Trainingsmethode von VINCIE-3B andere Unternehmen inspirieren könnte, ähnliche Wege zu gehen, die Kosten für KI-Modellentwicklung zu senken und die Demokratisierung der Kreativindustrie voranzutreiben.

huggingface: https://huggingface.co/ByteDance-Seed/VINCIE-3B