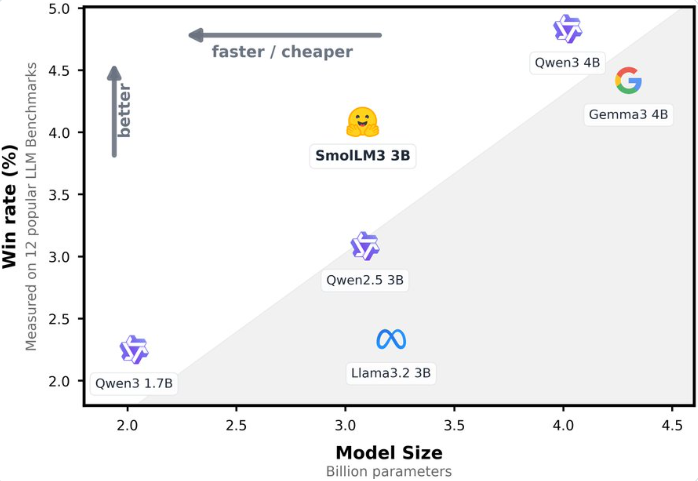

Neulich hat Hugging Face offiziell das neue, vollständig Open-Source-Sprachmodell SmolLM3 vorgestellt. Es handelt sich um ein leichtes großes Sprachmodell (LLM) mit 3B Parametern, das aufgrund seiner hervorragenden Leistung und effizienten Gestaltung große Aufmerksamkeit in der Branche erregt hat. SmolLM3 schneidet in verschiedenen Benchmark-Tests besser ab als Modelle wie Llama-3.2-3B und Qwen2.5-3B mit ähnlicher Größenordnung und ist sogar mit dem größeren Modell Gemma3 mit 4B Parametern vergleichbar.

Adresse: https://huggingface.co/blog/smollm3

3B Parameter, Leistung nahe bei 4B-Modellen

SmolLM3 ist ein Dekoder-spezifisches Transformer-Modell mit 3B Parametern. Es verwendet Techniken wie Gruppen-Abfrage-Attention (GQA) und NoPE, um Effizienz bei der Inferenz und die Fähigkeit zur Verarbeitung langer Kontexte zu kombinieren. Das Modell wurde auf einem vielfältigen Datensatz mit 11,2 Billionen Tokens trainiert, der Webseiten, Code, Mathematik und logische Daten umfasst, wodurch es in Bereichen wie Wissen, Logik, Mathematik und Codierung stark performt. Laut offiziellen Angaben erreicht SmolLM3 in Benchmarks wie HellaSwag, ARC und BoolQ führende Ergebnisse und ist im Vergleich zu 4B-Modellen wie Qwen3-4B und Gemma3-4B nicht schlechter, was die beeindruckende Potenzial von kleinen Modellen unterstreicht.

Zweimodale Inferenz, flexibel für verschiedene Aufgaben

SmolLM3 verfügt über eine einzigartige zweimodale Inferenzfunktion, die „Denken“ (think) und „Nicht-Denken“ (no-think) unterstützt. Bei aktivierter Denkmodus zeigt das Modell bei komplexen Aufgaben wie AIME2025 (36,7 % vs. 9,3 %), LiveCodeBench (30,0 % vs. 15,2 %) und GPQA Diamond (41,7 % vs. 35,7 %) deutliche Verbesserungen. Diese flexible Inferenzmodus ermöglicht es dem Modell, dynamisch an die Anforderungen der Aufgabe anzupassen und gleichzeitig Geschwindigkeit und tiefere Inferenz zu kombinieren, um verschiedene Szenarien wie schnelle Fragen oder komplexe Problemlösungen abzudecken.

Unterstützung von 128K Kontext, sechs Sprachen nahtlos wechseln

SmolLM3 zeigt hervorragende Leistung bei der Verarbeitung langer Kontexte. Während des Trainings unterstützt es einen Kontext von 64K und kann mithilfe der YaRN-Technologie auf 128K Token ausgedehnt werden. Es zeigte während des Ruler64k-Testes eine starke Fähigkeit zur Verarbeitung langer Sequenzen. Darüber hinaus unterstützt das Modell native sechs Sprachen (Englisch, Französisch, Spanisch, Deutsch, Italienisch, Portugiesisch) und wurde auch in Arabisch, Chinesisch und Russisch geringfügig trainiert, wodurch es eine ausgezeichnete Leistung bei multilingualen Aufgaben zeigt. In Tests wie Global MMLU und Flores-200 erreicht SmolLM3 führende Positionen unter Modellen ähnlicher Größenordnung und bietet damit zuverlässige Unterstützung für globale Anwendungen.

Vollständig Open-Source, Entwicklerökologie stärken

Hugging Face vertritt seit langem den Geist der Open-Source-Bewegung. SmolLM3 veröffentlicht nicht nur die Modellgewichte, sondern gibt auch alle Trainingsdaten, Trainingskonfigurationen und Code vollständig frei. Entwickler können detaillierte Informationen über die smollm-Repositorys von Hugging Face erhalten. Dieser transparente „Trainingsplan“ senkt erheblich die Schwelle für akademische Forschung und kommerzielle Anwendungen und ermöglicht es Entwicklern, Modelle basierend auf öffentlichen Datensätzen und Frameworks neu zu erstellen oder zu optimieren. AIbase ist der Meinung, dass diese Maßnahme den Fortschritt der Open-Source-AI-Ökologie weiter vorantreiben wird und mehr Möglichkeiten für Edge-Geräte und benutzerdefinierte Anwendungen bieten wird.

Effiziente Gestaltung, neues Wahl für Edge-Geräte

SmolLM3 ist speziell für effiziente Inferenz gestaltet. Die Gruppen-Abfrage-Attention-Technik reduziert signifikant den Speicherbedarf für KV-Caches bei der Inferenz und kombiniert sie mit WebGPU-Unterstützung, sodass es ideal für die Ausführung im Browser oder auf Edge-Geräten geeignet ist. Im Vergleich zu größeren Modellen findet SmolLM3 einen „Pareto-Optimalpunkt“ zwischen Leistung und Rechenkosten und bietet somit eine kosteneffiziente Lösung für Szenarien wie Bildung, Codierung und Kundenservice.

Industrielle Auswirkungen und zukünftige Perspektiven

Die Einführung von SmolLM3 markiert einen bedeutenden Durchbruch bei der Leistung und Effizienz kleiner Sprachmodelle. Seine Open-Source-Eigenschaften, Unterstützung langer Kontexte und multilinguale Fähigkeiten machen es zu einer idealen Wahl für akademische Forschung, Startups und mittelständische Unternehmen. AIbase prognostiziert, dass SmolLM3 in Bereichen wie Bildung, Kundenservice und lokale Deployment-Anwendungen eine Anwendungswelle auslösen wird. Gleichzeitig wird sein vollständig open-source-Trainingsschema weitere Entwickler dazu motivieren, an der Optimierung und Innovation von KI-Modellen teilzunehmen.

SmolLM3 erreicht mit 3B Parametern Leistungen, die denen von 4B-Modellen entsprechen, und zeigt das unerschöpfliche Potenzial kleiner Modelle im Bereich effizienter KI. Hugging Face hat durch die Offenlegung von Trainingsdetails und Daten ein Vorbild für Transparenz und Zusammenarbeit in der Branche gesetzt. Wir erwarten, dass SmolLM3 in vielen praktischen Anwendungen gute Ergebnisse liefern wird, und werden seine zukünftigen Updates weiterhin verfolgen.

Schlusswort