腾讯は、そのフラッグシップ大言語モデルであるTurboSの核心的な革新と強力な能力を明らかにするため、Hybrid Transformer-Mamba技術レポートを公開しました。

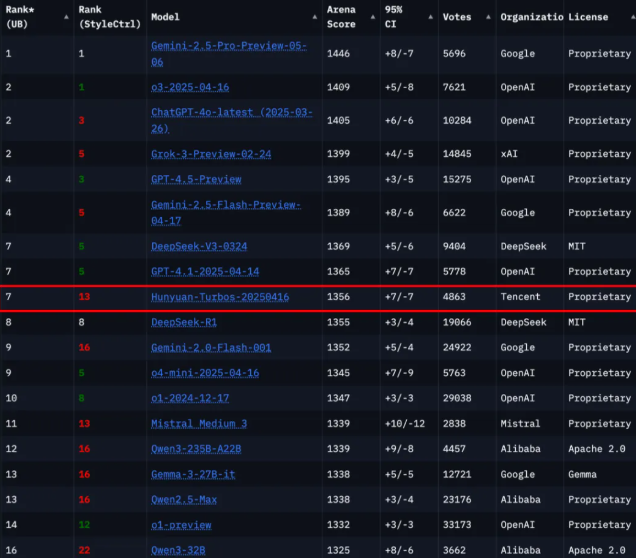

世界中の権威ある大規模モデル評価プラットフォームであるChatbot Arenaの最新ランキングによると、混元TurboSは239の参加モデルの中で第7位にランクされ、Deepseekに次ぐ国内トップモデルとなり、国際的にはGoogle、OpenAI、xAIなどの数社に次ぐ位置にあります。

混元TurboSモデルのアーキテクチャには、革新的なHybrid Transformer-Mamba構造が採用されており、この新しい設計は、Mambaアーキテクチャの長さの長い系列処理の効率性とTransformerアーキテクチャの文脈理解の利点を組み合わせることで、性能と効率のバランスを実現しています。このモデルは合計128層を持ち、アクティベーションパラメータ量は560億を超え、業界初の大規模展開となるTransformer-Mambaエキスパート混合モデル(MoE)です。このようなアーキテクチャの革新により、TurboSは国際的な権威ある評価で全体的なスコア1356を達成しました。

さらに、モデルの能力を向上させるために、混元TurboSは自己適応の長短思考連鎖メカニズムを導入し、問題の複雑さに基づいて応答モードを自動的に切り替えることが可能です。このメカニズムにより、モデルは簡単な問題に対して迅速に応答し、複雑な問題に対しては深く分析して高精度な答えを提供できます。また、チームは、監督微調整、自己適応の長短CoT融合などを含む4つの重要なモジュールで構成される後訓練プロセスを設計し、モデルのパフォーマンスをさらに強化しました。

事前学習段階では、混元TurboSは16兆トークンのコーパスで学習を行い、モデルのデータ品質と多様性を確保しました。その核心アーキテクチャには、Transformer、Mamba2、および前方ニューラルネットワーク(FFN)コンポーネントが含まれており、層の構成が合理的であり、トレーニングと推論の効率を最大限に高めています。

今回の技術レポートの発表は、 Tencent が大言語モデル分野での技術力だけでなく、今後の大型モデルの発展に向けた新たなアイデアや方向性を示すものでもあります。

論文リンク: https://arxiv.org/abs/2505.15431

要点整理:

🌟 TurboS モデルは Chatbot Arena で第7位にランクされ、非常に強い競争力を示しました。

💡 革新的な Hybrid Transformer-Mamba アーキテクチャは、性能と効率の最適なバランスを実現しました。

🔍 自己適応の長短思考連鎖メカニズムは、モデルが異なる複雑さの問題に対する応答能力を向上させました。