Un nuevo y abierto plataforma llamada SciArena ya está en línea, diseñada para evaluar el rendimiento de modelos de lenguaje grandes (LLM) en tareas de literatura científica a través de preferencias humanas. Los resultados iniciales han revelado una gran brecha en el rendimiento entre diferentes modelos.

SciArena fue desarrollado conjuntamente por investigadores de la Universidad de Yale, la Universidad de Nueva York y el Instituto Allen de Inteligencia Artificial, con el objetivo de evaluar de manera sistemática la efectividad de LLM propietarios y de código abierto en tareas de literatura científica, llenando así un vacío en la evaluación sistemática de este campo.

A diferencia de las pruebas tradicionales, SciArena se inspira en el método de Chatbot Arena, dependiendo de investigadores reales para realizar las evaluaciones. Una vez que los usuarios envían preguntas científicas, reciben dos respuestas largas generadas por modelos y citadas, luego los usuarios deciden cuál respuesta es mejor. Las referencias se obtienen a través de un proceso personalizado de búsqueda ScholarQA.

Hasta ahora, la plataforma ha recopilado más de 13.000 evaluaciones de 102 investigadores en áreas como ciencias naturales, ingeniería, ciencias de la vida y ciencias sociales, abarcando temas como explicaciones conceptuales y recuperación de literatura.

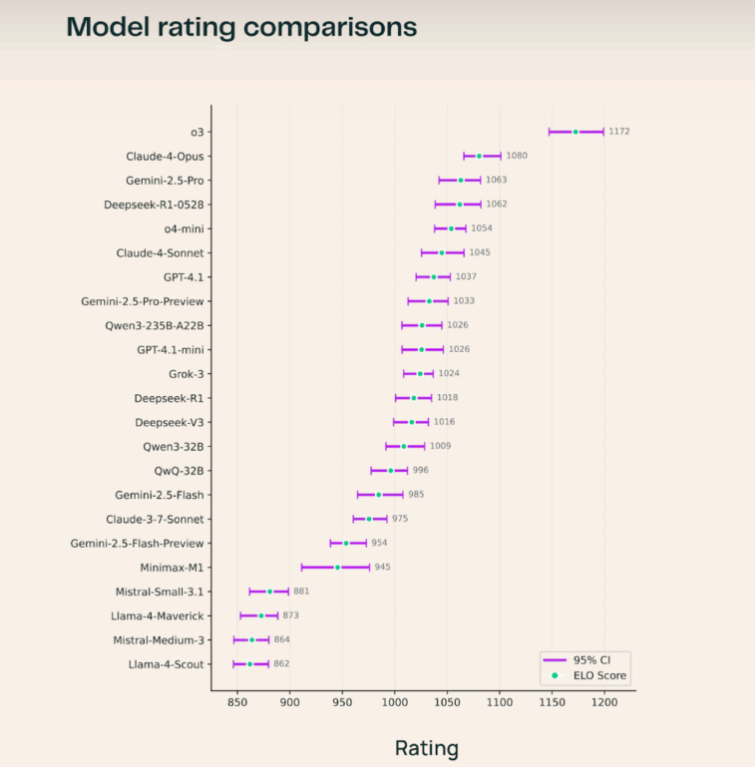

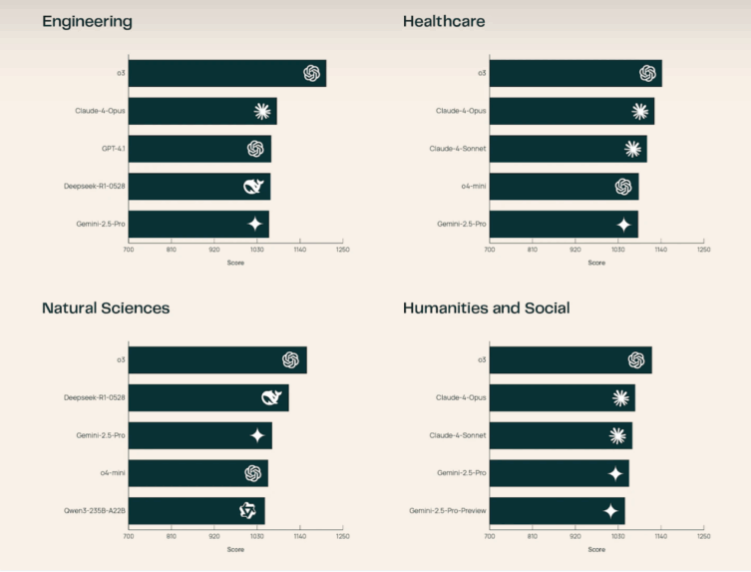

En la actualidad, el modelo o3 de OpenAI ocupa el primer lugar en la clasificación, seguido por Claude-4-Opus y Gemini-2.5-Pro. En modelos de código abierto, Deepseek-R1-0528 destaca, logrando un rendimiento incluso superior a varios sistemas propietarios. El equipo de investigación señaló que o3 muestra un desempeño especialmente destacado en ciencias naturales e ingeniería. Los investigadores también encontraron que los usuarios prestan más atención a si las citas coinciden correctamente con las afirmaciones, más que simplemente al número de citas. Factores como la longitud de las respuestas tienen menos impacto en SciArena que en plataformas como Chatbot Arena o Search Arena.

A pesar de estos avances, la evaluación automatizada sigue siendo un desafío. El equipo también lanzó una nueva prueba de referencia llamada SciArena-Eval, utilizada para probar la capacidad de los modelos de lenguaje para juzgar las respuestas de otros modelos. Sin embargo, incluso los modelos más exitosos solo coinciden con las preferencias humanas alrededor del 65% del tiempo, lo que resalta las limitaciones de los sistemas actuales de LLM como jueces en el ámbito científico.

SciArena está disponible para el público general, y su código, datos y la prueba de referencia SciArena-Eval están disponibles de forma abierta. La plataforma busca apoyar el desarrollo de modelos más cercanos a las necesidades humanas en tareas de información científica. Para el futuro, SciArena planea agregar funcionalidades para evaluar sistemas de investigación basados en agentes.